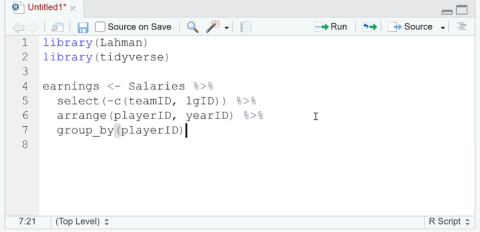

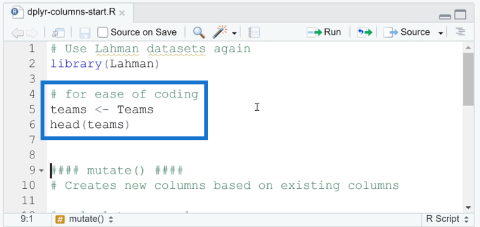

Dodawaj, usuwaj i zmieniaj nazwy kolumn w R za pomocą Dplyr

W tym samouczku omówimy pakiet dplyr, który umożliwia sortowanie, filtrowanie, dodawanie i zmianę nazw kolumn w języku R.

Na tym blogu omówimy analizę tekstu w Pythonie do tworzenia konstruowanych danych z treści tekstowej. Pomoże Ci to analizować duże ilości danych i pochłonie mniej czasu na pracę nad niektórymi zadaniami. Zdobędziesz również wiedzę na temat textblobów zajmujących się zadaniami przetwarzania języka naturalnego.

Analiza tekstu to proces analizy tekstów za pomocą kodów do zautomatyzowanych procesów tworzenia i grupowania danych tekstowych.

Zanim przejdziemy dalej, może być konieczne zainstalowanie biblioteki, której będziemy używać w tym samouczku.

Spis treści

Implementacja analizy tekstu w Pythonie

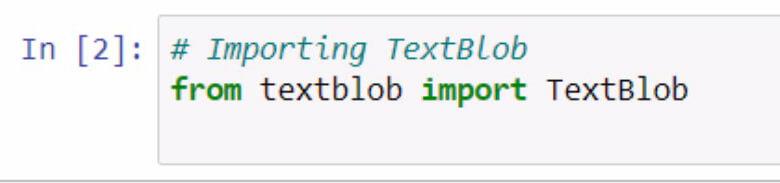

Zacznijmy od zaimportowania obiektu textblob . Pamiętaj, aby dokumentować to, co robisz, za pomocą komentarzy.

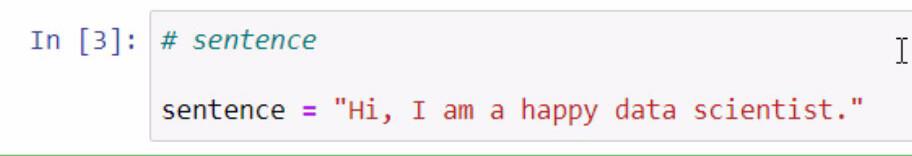

Uruchamiając powyższy kod, mamy teraz dostęp do biblioteki textblob . Następnym krokiem, który zamierzamy zrobić, jest utworzenie zdania, którego użyjemy w naszych przykładach. Zrobimy to, przechowując zdanie w zmiennej o nazwie zdanie .

Pamiętaj, aby zdanie, które chcesz dodać, ująć w podwójny cudzysłów.

Textblob to świetna biblioteka, w której możemy stworzyć obiekt blob i wykorzystać niektóre jego funkcje do analizy tekstu w Pythonie .

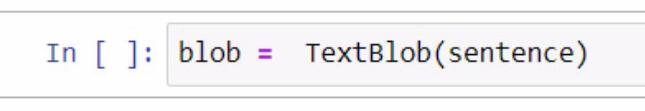

Tworzenie obiektu blob rozpoczynamy od utworzenia zmiennej i nadania jej nazwy blob . W tej zmiennej musimy dodać TextBlob, czyli bibliotekę, której używamy.

W nawiasach użyjemy zmiennej zdania , która zawiera zdanie, które stworzyliśmy wcześniej. Pamiętaj, że możesz zdecydować się na ręczne wpisanie samego zdania w nawiasach dla tej części.

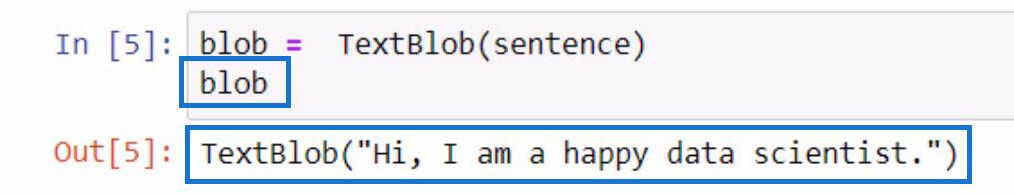

Aby sprawdzić, co robi ta zmienna blob , możesz po prostu ją zainicjować, wpisując nazwę zmiennej i naciskając klawisze Shift + Enter. Dane wyjściowe powinny być podobne do poniższego przykładu.

Jak widać z wyniku, zdanie, które zapisaliśmy w zmiennej zdania , jest teraz zawarte w obiekcie TextBlob .

Tokenizacja danych tekstowych w Pythonie

Jeśli chcesz usunąć niektóre słowa w zdaniu, możemy rozdzielić każde z tych słów na osobne części na liście. W tym zdaniu zrobimy tokenizację lub oddzielimy każde słowo i umieścimy je na liście.

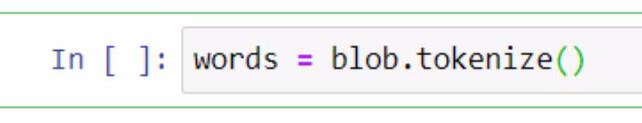

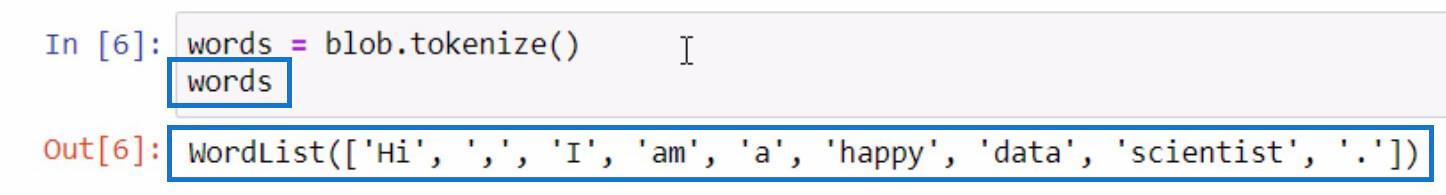

Aby to zrobić, użyjemy zmiennej blob i użyjemy funkcji tokenize . Następnie zapiszemy go w zmiennej o nazwie Words .

Zainicjujmy zmienną Words w ten sam sposób, w jaki inicjowaliśmy zmienną blob , aby zobaczyć, co znajduje się na tokenizowanej liście.

Jak widać, każde ze słów, a nawet znaki interpunkcyjne są teraz oddzielone na liście. Tak działa funkcja tokenizacji .

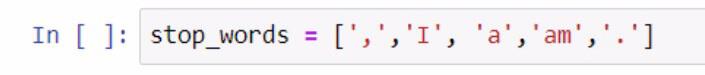

Teraz, gdy mamy listę słów, możemy wykonać z niej inną funkcję. Stwórzmy kolejną listę słów, których nie chcemy uwzględniać na naszej liście, takich jak znaki interpunkcyjne i przedimki. Aby wykonać ten krok, zapoznaj się z poniższym zrzutem ekranu.

Tworząc listę słów pomijanych, użyliśmy nawiasów, aby ująć listę słów pomijanych. Następnie każde ze słów pomijanych jest ujęte w pojedynczy cudzysłów i każde oddzielone przecinkiem. Przechowaliśmy listę w zmiennej stop_words .

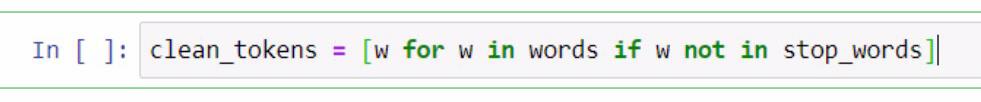

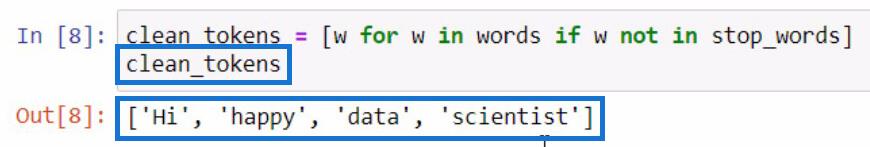

Odtąd wykonamy rozumienie listy , aby usunąć słowa, które są niezbędne do przeprowadzenia analizy tekstu w Pythonie . Obejmuje to czyszczenie zdań, tokenizację i porównywanie różnych list. Teraz porównamy te dwie listy i utworzymy nową listę clean_tokens .

W przedstawionym powyżej kodzie użyliśmy symbolu zastępczego, którym jest w do reprezentowania elementu . W tej części próbujemy pobrać element ze zmiennej Words, jeśli element nie istnieje w zmiennej stop_words . Jeśli zamierzamy zainicjować clean_tokens , to będzie wynik.

W tym procesie jesteśmy w stanie wyczyścić nasze tokeny , usuwając niepotrzebne tokeny, takie jak znaki interpunkcyjne i przedimki. Z tego powodu na naszej liście pozostały tylko słowa esencji.

Łączenie tokenów w celu utworzenia zdania w Pythonie

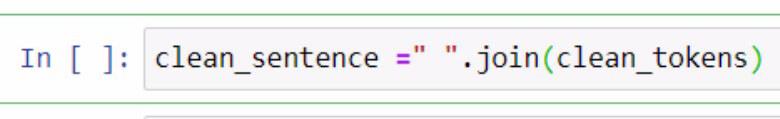

Teraz, gdy oddzieliliśmy czyste tokeny , spróbujmy umieścić je razem w jednym zdaniu. Aby to zrobić, musimy skorzystać z funkcji .join . Sprawdź poniższy przykład w celach informacyjnych.

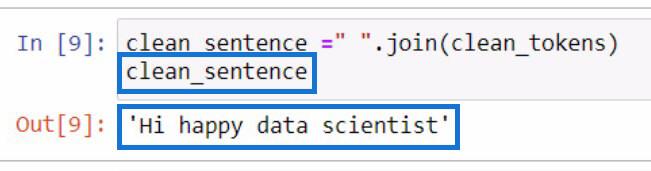

W powyższym przykładzie utworzyliśmy zmienną o nazwie clean_sentence do przechowywania naszych czystych tokenów, które zostaną połączone w zdanie. Możesz również zauważyć, że dodaliśmy spację ujętą w podwójne cudzysłowy i funkcję .join . Wewnątrz parametrów umieściliśmy zmienną clean_tokens .

To będzie wynik, jeśli zainicjujemy zmienną clean_sentence .

Zauważalnie, zdanie nie wygląda poprawnie, ponieważ wcześniej usunęliśmy przedimki i znaki interpunkcyjne.

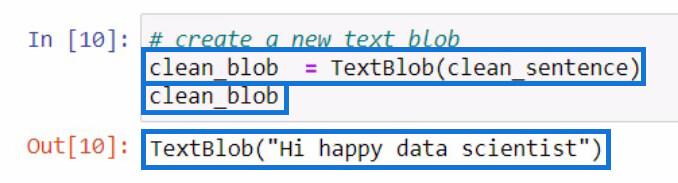

Po utworzeniu clean_sentence spróbujmy utworzyć nowy obiekt tekstowy zawierający właśnie utworzone clean_sentence . Następnie zapiszemy go w nowej zmiennej clean_blob .

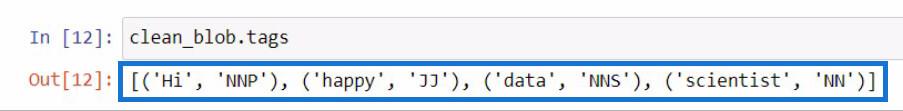

Analiza obiektu tekstowego pod kątem części mowy za pomocą funkcji .tags

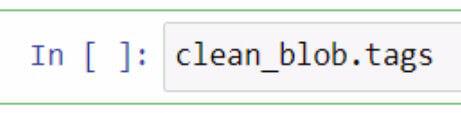

Z tego obiektu blob analizy możemy użyć jego fragmentów, aby sprawdzić części mowy lub wprowadzić jeszcze więcej zmian. Spróbujmy sprawdzić części mowy każdego słowa w naszym nowym obiekcie tekstowym .

Aby sprawdzić części mowy w textblobie, należy skorzystać z funkcji .tags . Zrobiłem to, wykorzystując naszą zmienną clean_blob , a następnie dodałem funkcję .tags zaraz po tym.

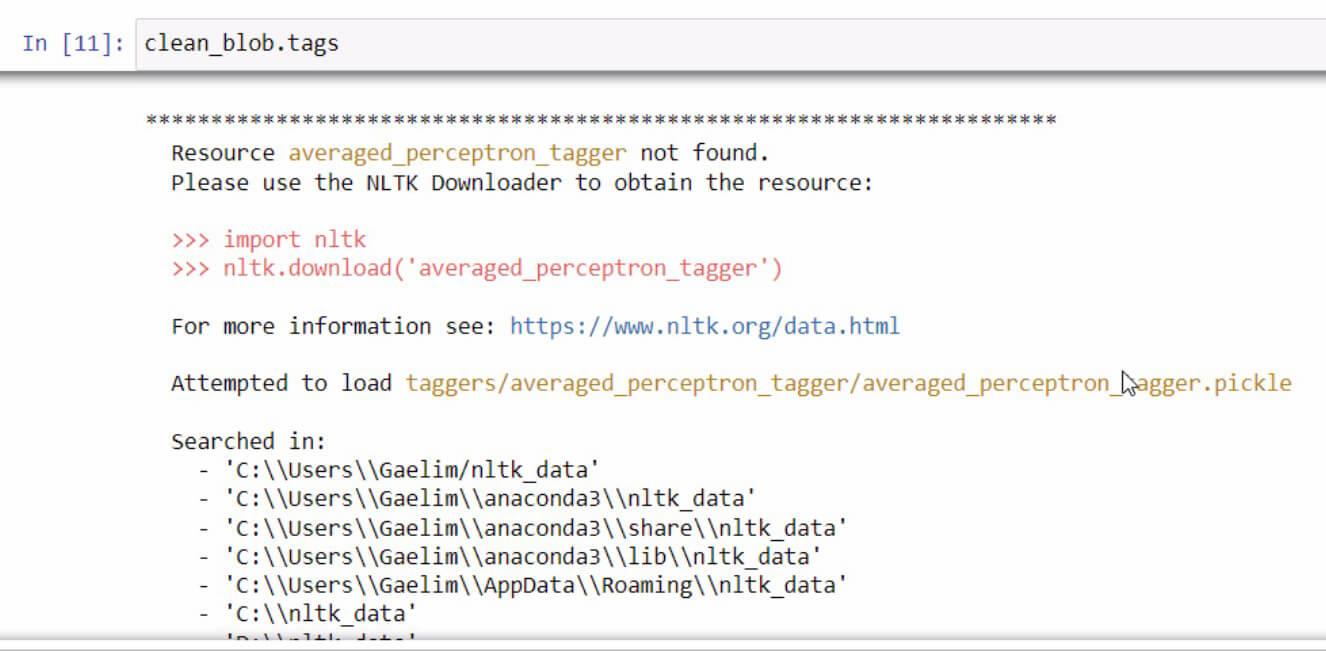

Jeśli kiedykolwiek otrzymasz komunikat o błędzie podczas inicjowania funkcji .tags , po prostu przeczytaj i postępuj zgodnie z instrukcjami, aby naprawić błąd. W tym przypadku wygląda to tak.

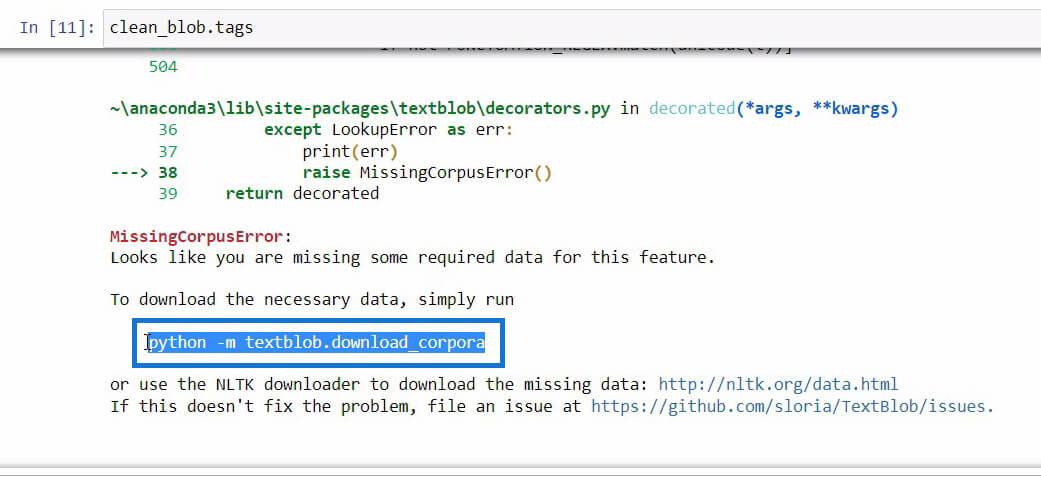

Jeśli przewiniesz w dół na końcu tego komunikatu o błędzie, zobaczysz wymagane dane potrzebne do funkcji, której próbujesz użyć.

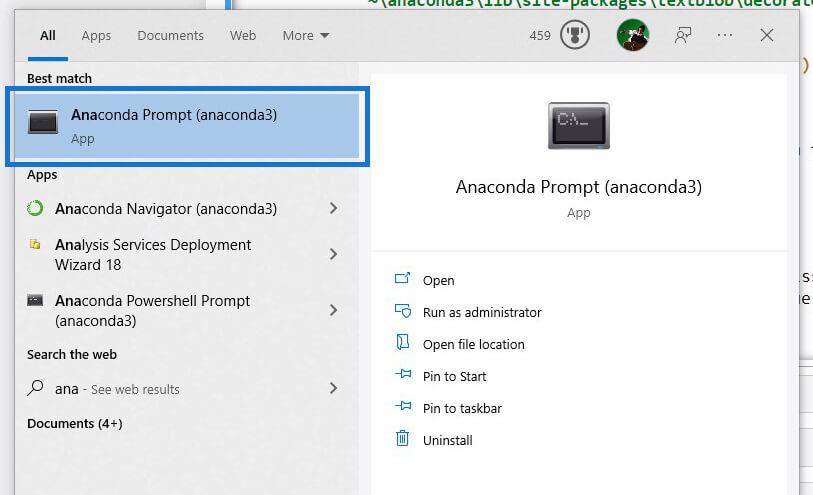

Gdy znajdziemy kod, który musimy zainicjować, aby pobrać niezbędne dane, po prostu skopiuj kod, a następnie otwórz Anaconda Prompt za pomocą Windows Search .

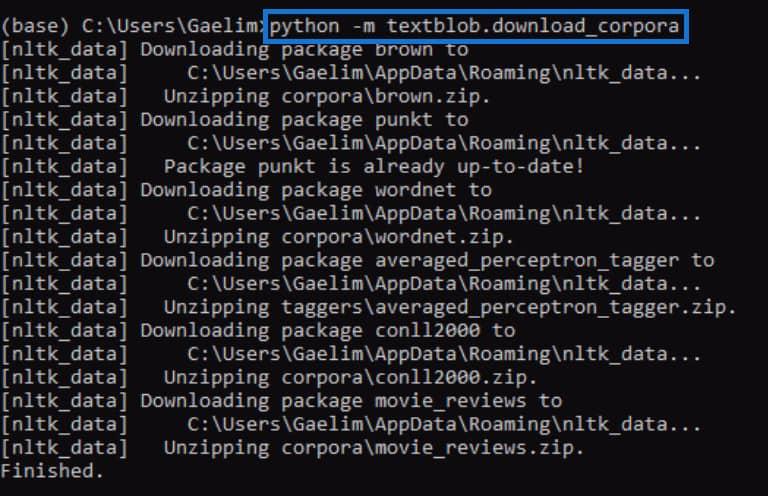

Za pomocą Anaconda Prompt spróbujemy naprawić błąd, który otrzymaliśmy podczas inicjowania funkcji .tags . Teraz wkleimy kod skopiowany wcześniej z komunikatu o błędzie i uruchomimy go, naciskając klawisz Enter .

Po zakończeniu spróbuj ponownie uruchomić funkcję .tags i sprawdź, czy działa.

Po ponownym uruchomieniu kodu widzimy, że błąd został naprawiony i otrzymaliśmy wynik zawierający każde słowo z nowego obiektu tekstowego wraz z tagami lub częściami mowy.

Jeśli nie masz pojęcia, co oznaczają te tagi , możesz po prostu przejść do witryny textblob , aby sprawdzić, co reprezentują te tagi.

Wykorzystanie funkcji ngrams do analizy tekstu w Pythonie

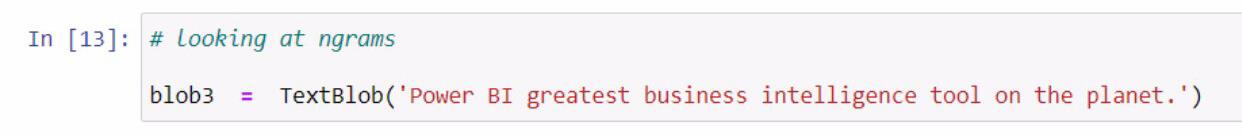

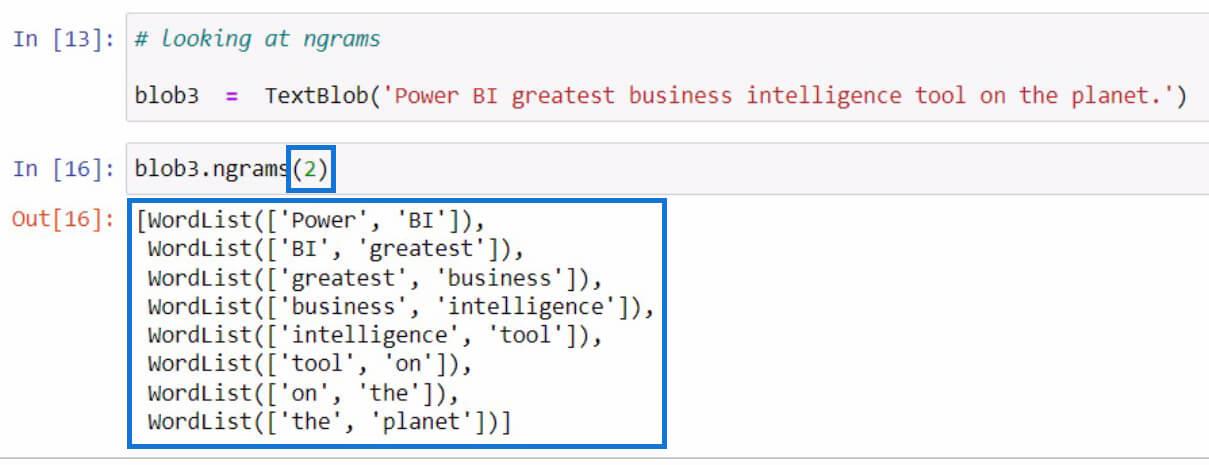

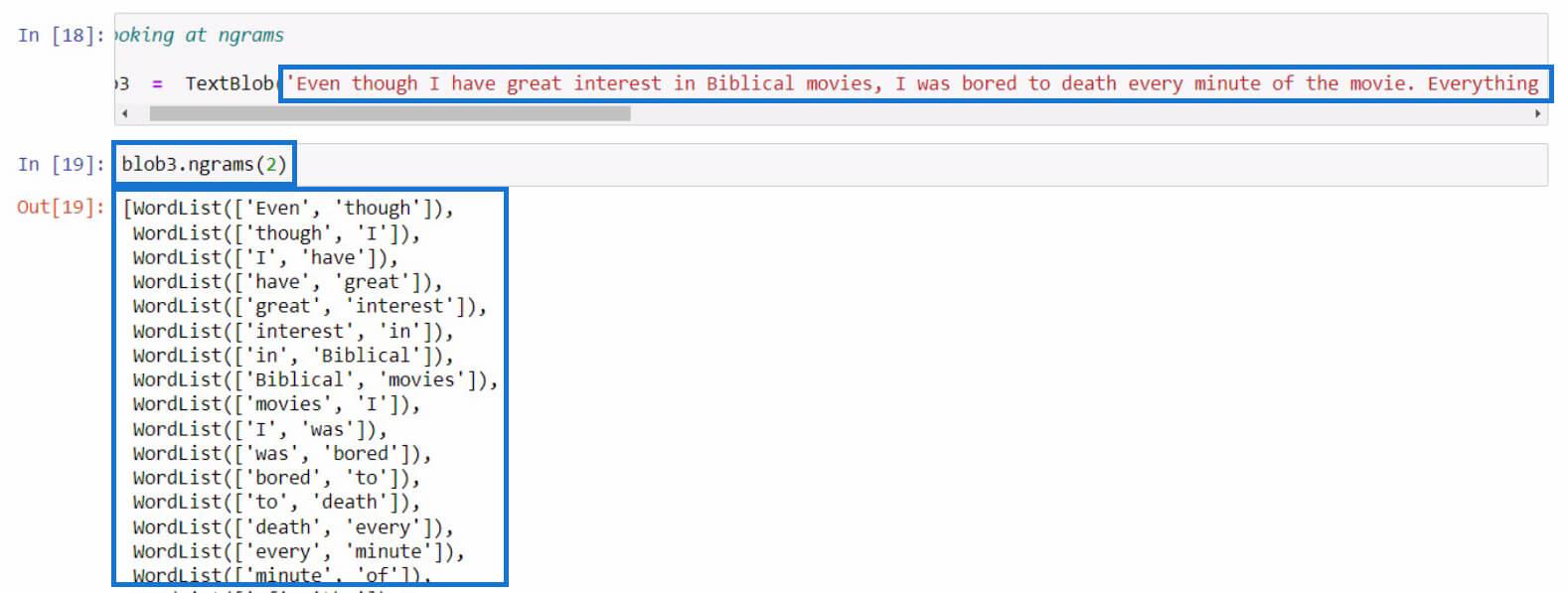

Przejdźmy do innego przykładu, który dotyczy pobierania ngrams . Funkcja ngrams służy do wyszukiwania słów, które często występują razem w zdaniu lub dokumencie. Na przykład zacznijmy od utworzenia nowego obiektu textblob i zapisania go w zmiennej blob3 .

Następnie użyjmy funkcji ngrams w zmiennej blob3 , aby sprawdzić niektóre kombinacje słów.

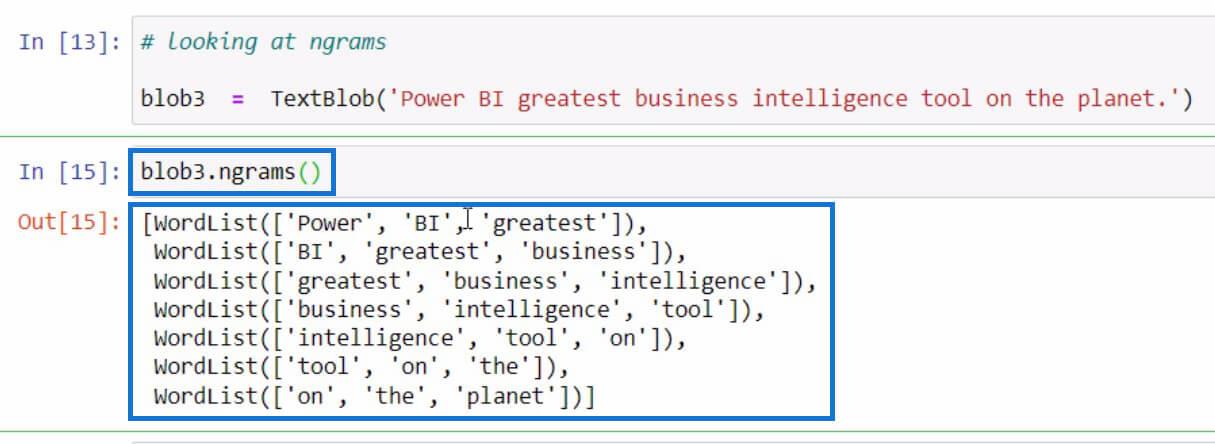

Domyślnie, jeśli nie określiłeś wartości w parametrach, wyświetli trygramy lub kombinacje 3 słów. Ale jeśli chcemy zobaczyć kombinacje 2-wyrazowe ze zdania, możemy ustawić 2 w parametrach, jak w poniższym przykładzie.

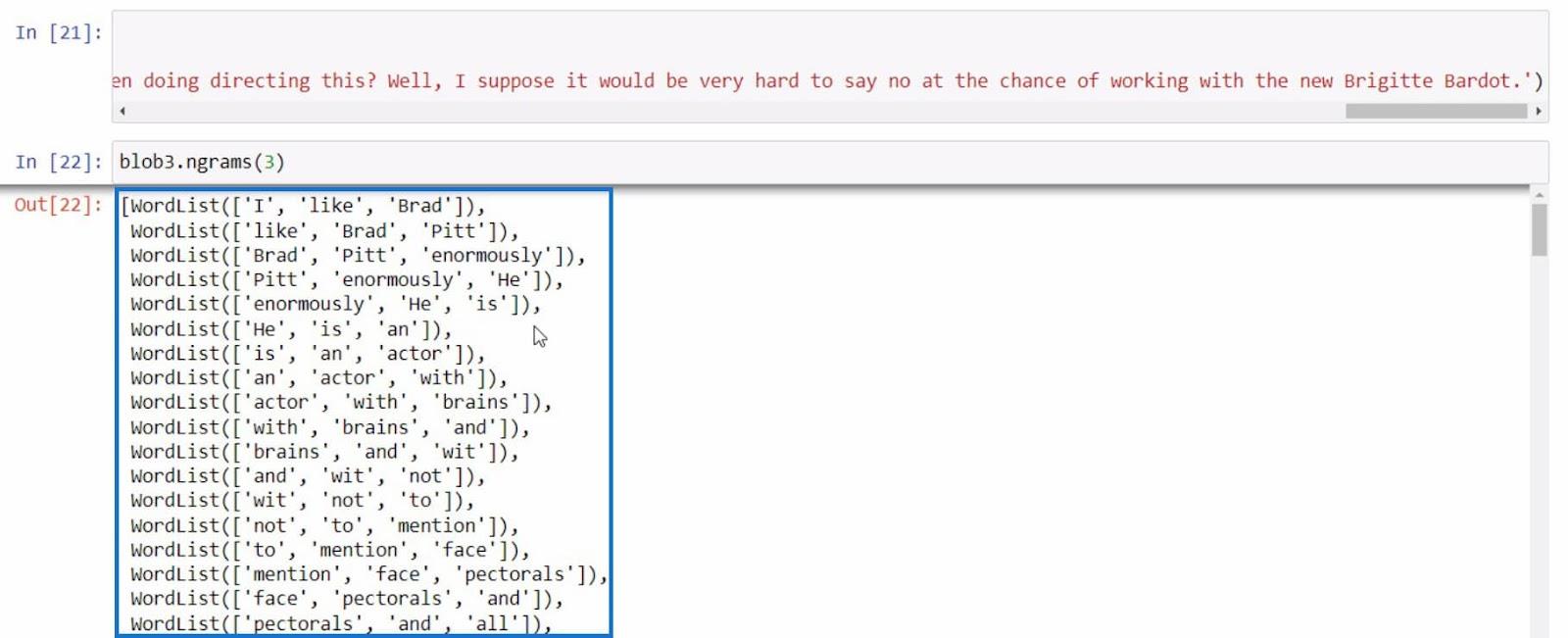

Spróbujmy tym razem z dłuższym zdaniem. W tym przykładzie właśnie skopiowałem dłuższy tekst z recenzji filmu. W tej części możesz użyć dowolnego zdania.

Jako ostatni przykład, spróbujmy jeszcze raz użyć ngramów z bardziej informacyjnym zdaniem.

Dzięki tym wszystkim przykładom możemy przeprowadzić więcej analiz tekstu w Pythonie w oparciu o wyniki, które otrzymujemy za pomocą funkcji ngrams .

Python II dla użytkowników LuckyTemplates – nowy kurs na platformie On-Demand

Jak ładować przykładowe zestawy danych w Pythonie

za pomocą Pythona w LuckyTemplates | Zestaw danych i funkcja łańcuchowa

Wniosek

Podsumowując, poznałeś już różne funkcje, których możesz użyć do analizy tekstu w Pythonie.

Są to funkcja .tokenize do oddzielania słów w zdaniu, funkcja .join do łączenia wyrazów tokenizowanych, funkcja .tags do sprawdzania części mowy słów oraz funkcja ngrams do przeglądania kombinacji słów.

Ponadto nauczyłeś się, jak naprawiać błędy, takie jak to, co zrobiliśmy w funkcji .tags za pomocą Anaconda Prompt . Nauczyłeś się także importować, tworzyć obiekty tekstowe i wykorzystywać tę bibliotekę do przeprowadzania analizy tekstu w języku Python .

Wszystkiego najlepszego,

gaelim

W tym samouczku omówimy pakiet dplyr, który umożliwia sortowanie, filtrowanie, dodawanie i zmianę nazw kolumn w języku R.

Odkryj różnorodne funkcje zbierania, które można wykorzystać w Power Automate. Zdobądź praktyczne informacje o funkcjach tablicowych i ich zastosowaniu.

Z tego samouczka dowiesz się, jak ocenić wydajność kodów DAX przy użyciu opcji Uruchom test porównawczy w DAX Studio.

Czym jest self w Pythonie: przykłady z życia wzięte

Dowiesz się, jak zapisywać i ładować obiekty z pliku .rds w R. Ten blog będzie również omawiał sposób importowania obiektów z R do LuckyTemplates.

Z tego samouczka języka kodowania DAX dowiesz się, jak używać funkcji GENERUJ i jak dynamicznie zmieniać tytuł miary.

W tym samouczku omówiono sposób korzystania z techniki wielowątkowych wizualizacji dynamicznych w celu tworzenia szczegółowych informacji na podstawie dynamicznych wizualizacji danych w raportach.

W tym artykule omówię kontekst filtra. Kontekst filtrowania to jeden z głównych tematów, z którym każdy użytkownik usługi LuckyTemplates powinien zapoznać się na początku.

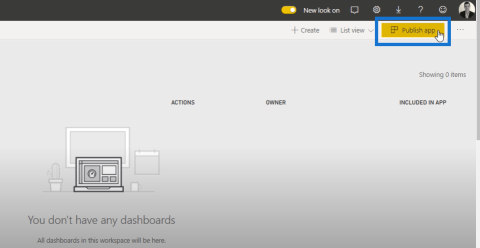

Chcę pokazać, jak usługa online LuckyTemplates Apps może pomóc w zarządzaniu różnymi raportami i spostrzeżeniami generowanymi z różnych źródeł.

Dowiedz się, jak obliczyć zmiany marży zysku przy użyciu technik, takich jak rozgałęzianie miar i łączenie formuł języka DAX w usłudze LuckyTemplates.