Расчет недельных продаж с помощью DAX в LuckyTemplates

В этом руководстве показано, как в конечном итоге можно рассчитать разницу между еженедельными результатами продаж с помощью DAX в LuckyTemplates.

В этом блоге мы собираемся обсудить анализ текста в Python для создания сконструированных данных из текстового содержимого. Это поможет вам анализировать большие объемы данных и тратить меньше времени на работу над определенными задачами. Вы также получите знания о текстовых блобах , связанных с задачами обработки естественного языка.

Анализ текста — это процесс анализа текстов с использованием кодов для автоматизированных процессов создания и группировки текстовых данных.

Прежде чем мы продолжим, вам, возможно, придется установить библиотеку, которую мы будем использовать в этом руководстве.

Оглавление

Реализация анализа текста в Python

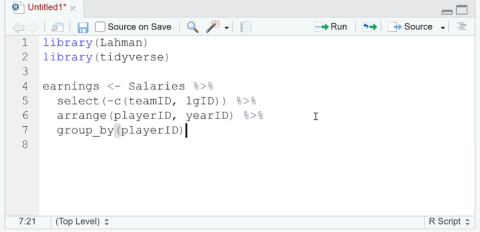

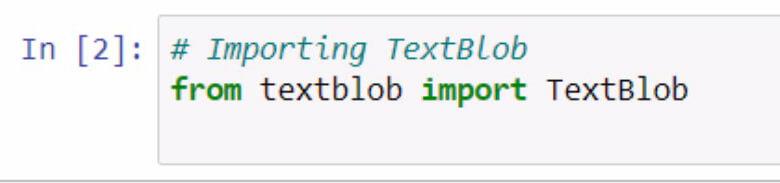

Начнем с импорта textblob . Не забывайте документировать свои действия с помощью комментариев.

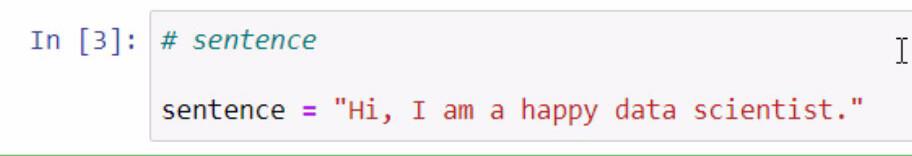

Запустив приведенный выше код, мы получили доступ к библиотеке textblob . Следующим шагом, который мы собираемся сделать, является создание предложения, которое мы собираемся использовать в наших примерах. Мы собираемся сделать это, сохранив предложение в переменной с именем предложение .

Не забудьте заключить предложение, которое вы хотите добавить, в двойные кавычки.

Textblob — отличная библиотека, в которой мы можем создать большой двоичный объект и использовать некоторые из его функций для анализа текста в Python .

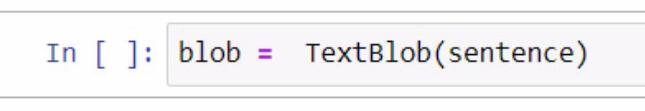

При создании большого двоичного объекта мы начинаем с создания переменной и присваиваем ей имя blob . В эту переменную нам нужно добавить TextBlob — библиотеку, которую мы используем.

Внутри круглых скобок мы будем использовать переменную предложения , которая содержит предложение, которое мы создали ранее. Обратите внимание, что вы можете вручную ввести само предложение в скобках для этой части.

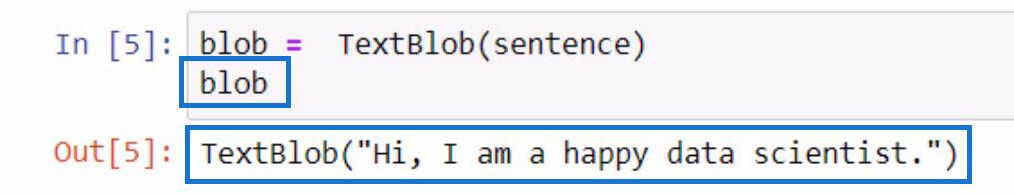

Чтобы проверить, что делает эта переменная большого двоичного объекта , вы можете просто инициализировать ее, введя имя переменной и нажав клавиши Shift + Enter. Вывод должен быть похож на пример ниже.

Как видно из результата, предложение, которое мы сохранили в переменной предложения , теперь содержится в TextBlob .

Токенизация текстовых данных в Python

Если вы хотите удалить некоторые слова в предложении, мы можем разделить каждое из этих слов на отдельные части в списке. Что мы собираемся сделать с данным предложением, так это маркировать их или разделить каждое слово и поместить его в список.

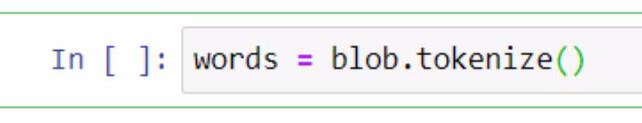

Для этого мы будем использовать переменную blob и использовать функцию tokenize . Затем мы сохраним его в переменной с именем words .

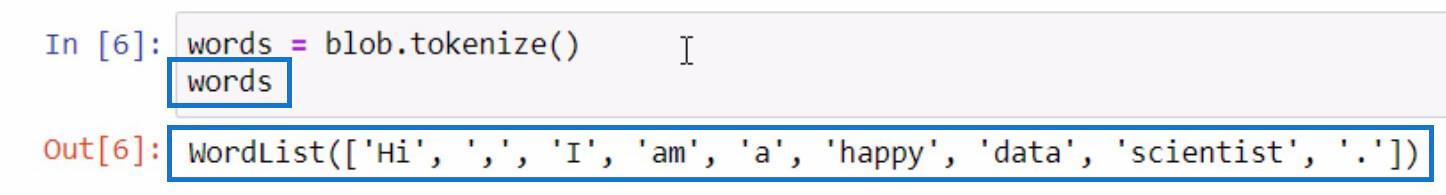

Давайте инициализируем переменную words так же, как мы инициализировали переменную blob , чтобы увидеть, что находится в токенизированном списке.

Как видите, каждое из слов и даже знаки препинания теперь разделены в списке. Вот как работает функция токенизации .

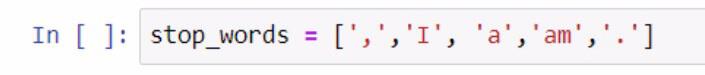

Теперь, когда у нас есть список слов, мы можем выполнить из него другую функцию. Давайте создадим еще один список слов, которые мы не хотим включать в наш список, таких как знаки препинания и артикли. Чтобы выполнить этот шаг, обратитесь к снимку экрана ниже.

При создании списка стоп-слов мы использовали скобки, чтобы заключить список стоп-слов. Затем каждое из стоп-слов заключается в одинарные кавычки и отделяется запятой. Мы сохранили список в переменной stop_words .

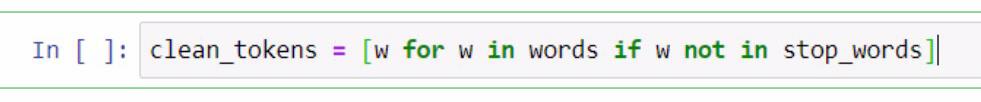

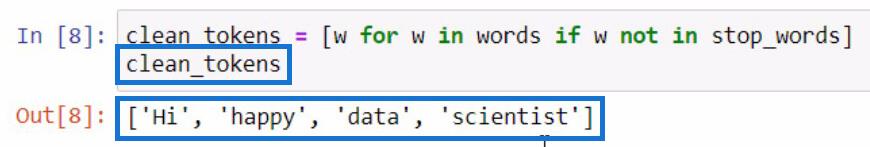

Отсюда мы собираемся выполнить распознавание списка , чтобы удалить слова, необходимые для проведения анализа текста в Python . Это включает в себя очистку предложений, токенизацию и сравнение различных списков. Теперь мы сравним эти два списка и создадим новый список clean_tokens .

В коде, представленном выше, мы использовали заполнитель w для представления элемента . Что мы пытаемся сделать в этой части, так это получить элемент в переменной words, если элемент не существует в переменной stop_words . Если мы собираемся инициализировать clean_tokens , это будет результат.

В этом процессе мы можем очистить наши токены , запустив процесс удаления ненужных токенов, таких как знаки препинания и артикли. Из-за этого в нашем списке остались только ключевые слова.

Объединение токенов для формирования предложения в Python

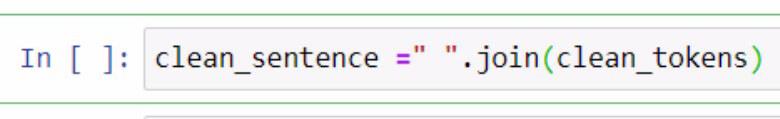

Теперь, когда мы разделили чистые токены , давайте попробуем объединить их в одно предложение. Для этого мы должны использовать функцию .join . Проверьте приведенный ниже пример для справки.

В приведенном выше примере мы создали переменную с именем clean_sentence для хранения токенов очистки, которые будут объединены в предложение. Вы также можете заметить, что мы добавили пробел, заключенный в двойные кавычки, и функцию .join . Внутри параметров мы включили переменную clean_tokens .

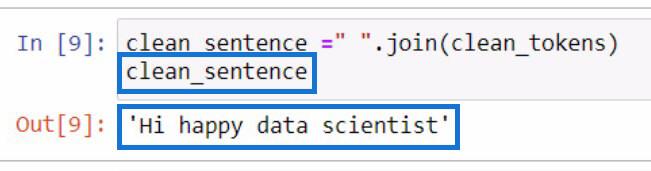

Это будет вывод, если мы инициализируем переменную clean_sentence .

Примечательно, что предложение выглядит неправильно, потому что ранее мы удалили артикли и знаки препинания.

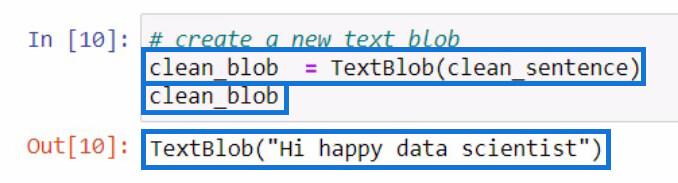

После создания clean_sentence давайте попробуем создать новый текстовый BLOB-объект , содержащий только что созданное clean_sentence . Затем мы сохраним его в новой переменной clean_blob .

Разделение текстового блоба на части речи с помощью функции .tags

Из этого большого двоичного объекта анализа мы можем использовать его части для проверки частей речи или внесения дополнительных изменений. Давайте попробуем проверить части речи каждого слова в нашем новом текстовом блобе .

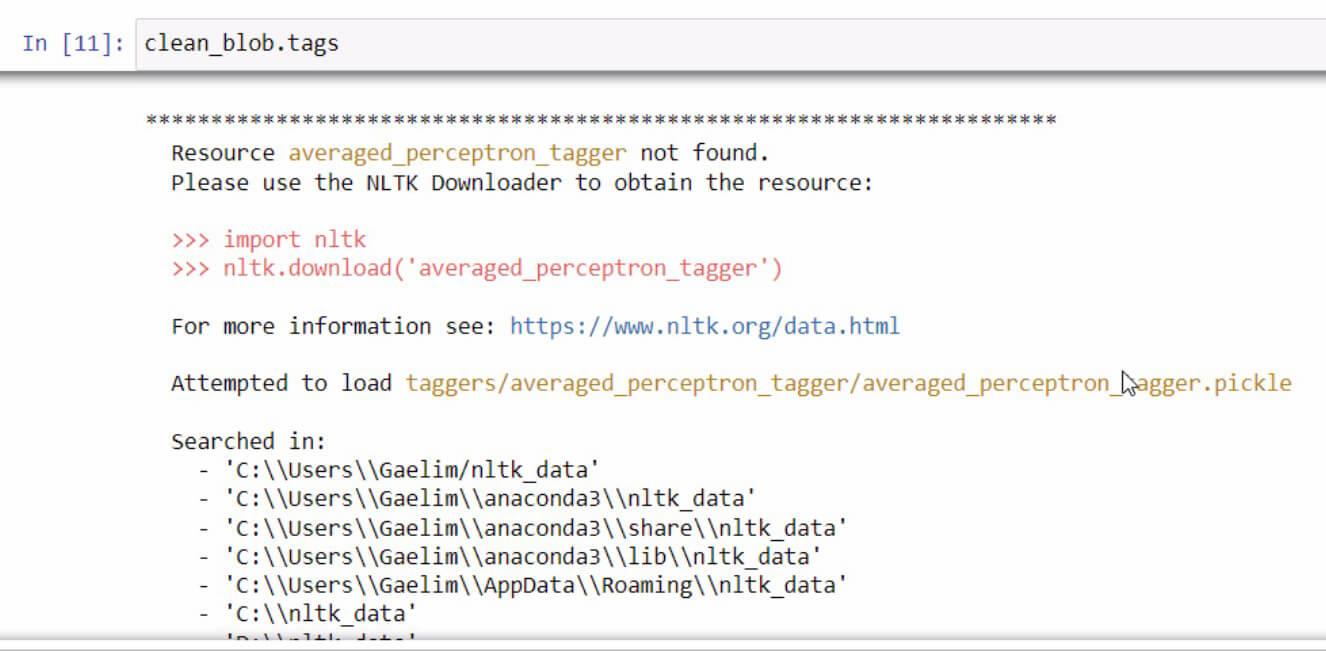

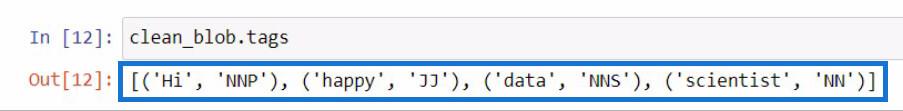

Чтобы проверить части речи в текстовом блобе, вы должны использовать функцию .tags . Я сделал это, используя нашу переменную clean_blob , а затем сразу же добавил функцию .tags .

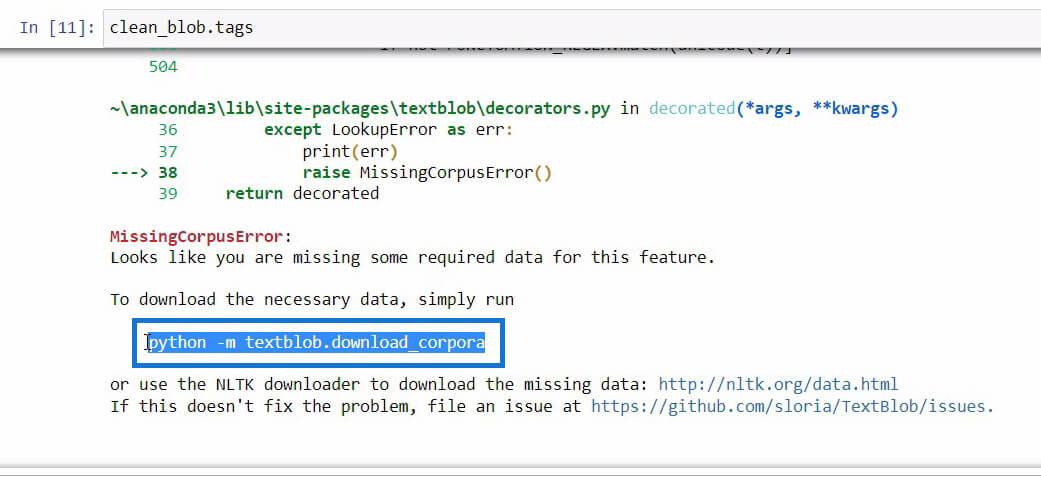

Если вы когда-нибудь получите сообщение об ошибке при инициализации функции .tags , просто прочитайте и выполните шаги, чтобы исправить ошибку. В данном случае это выглядит так.

Если вы прокрутите вниз в конце этого сообщения об ошибке, вы увидите необходимые данные, которые вам нужны для функции, которую вы пытаетесь использовать.

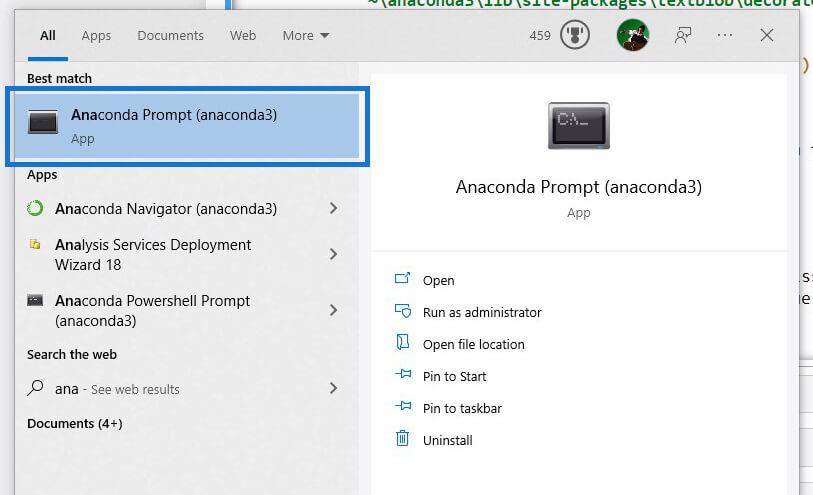

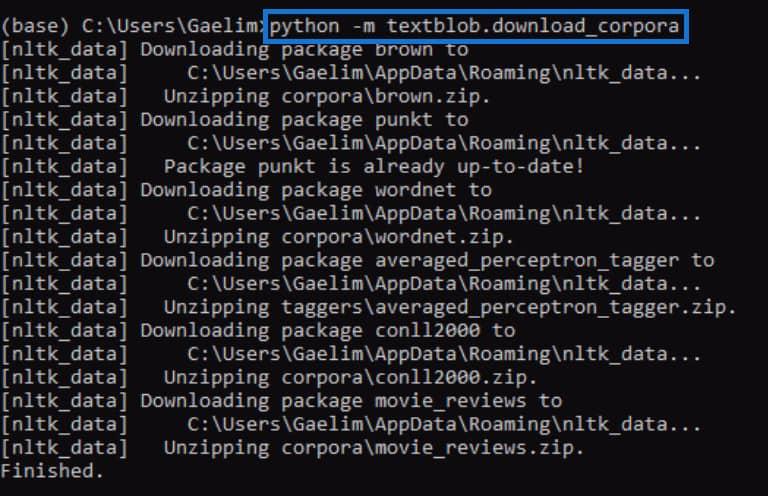

Как только мы найдем код, который нам нужно инициализировать, чтобы загрузить необходимые данные, просто скопируйте код, а затем откройте Anaconda Prompt с помощью поиска Windows .

С помощью Anaconda Prompt попробуем исправить ошибку, которую получили при инициализации функции .tags . Теперь мы вставим код, который мы скопировали из сообщения об ошибке ранее, и запустим его, нажав Enter .

После завершения попробуйте снова запустить функцию .tags и посмотрите, работает ли она.

После повторного запуска кода мы видим, что ошибка исправлена, и мы получили результат, который содержит каждое слово из нового текстового блоба вместе с тегами или частями речи.

Если вы понятия не имеете, что означают эти теги , вы можете просто зайти на веб-сайт textblob и проверить, что представляют собой эти теги.

Использование функции ngrams для анализа текста в Python

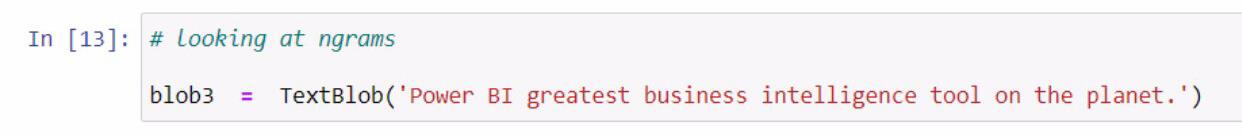

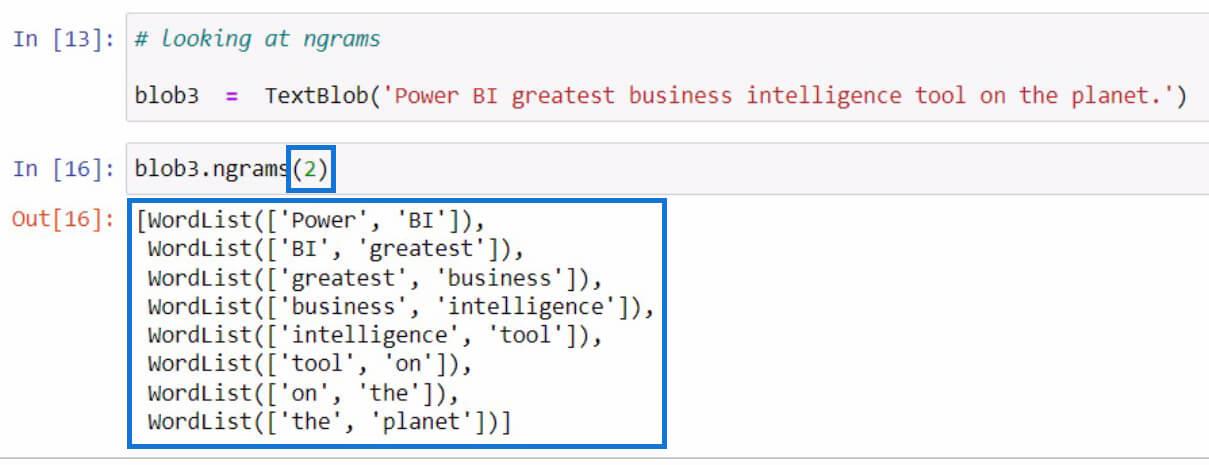

Давайте перейдем к другому примеру, связанному с получением ngrams . Функция ngrams используется для поиска слов, которые часто встречаются вместе в предложении или документе. В качестве примера начнем с создания нового текстового блоба и сохранения его в переменной blob3 .

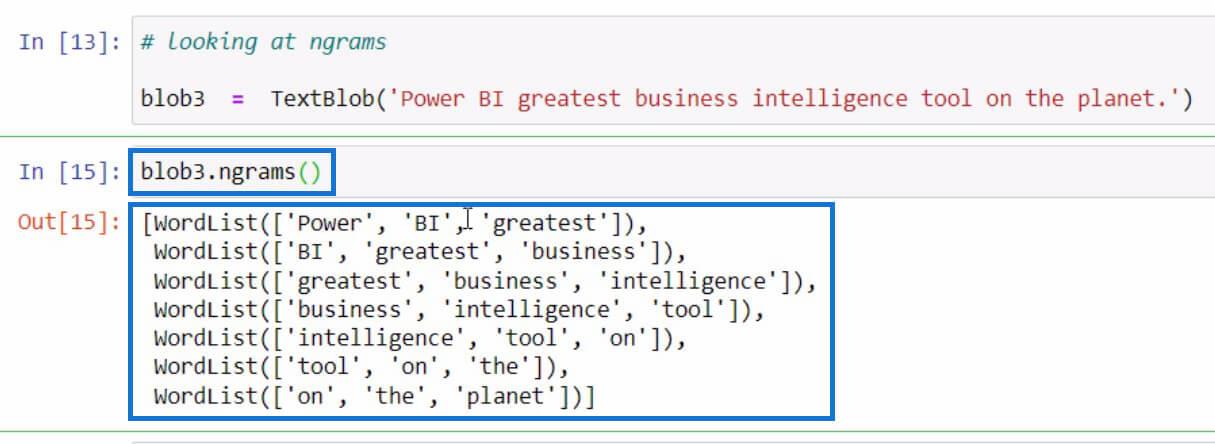

После этого воспользуемся функцией ngrams в переменной blob3 для проверки некоторых комбинаций слов.

По умолчанию, если вы не указали значение в параметрах, будут отображаться триграммы или комбинации из 3 слов. Но если мы хотим видеть комбинации из двух слов из предложения, мы можем установить 2 в параметрах, как в примере ниже.

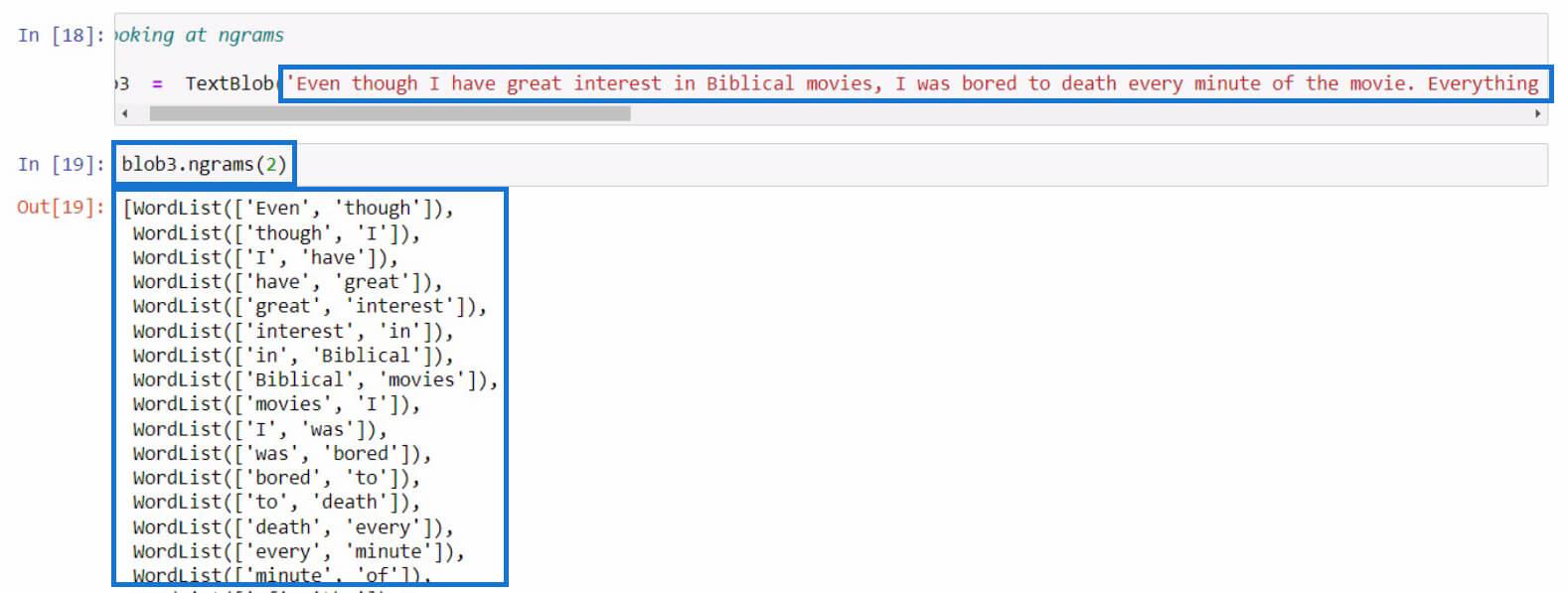

Давайте попробуем на этот раз более длинное предложение. В этом примере я просто скопировал более длинный текст из обзора фильма. Вы можете использовать любое предложение для этой части.

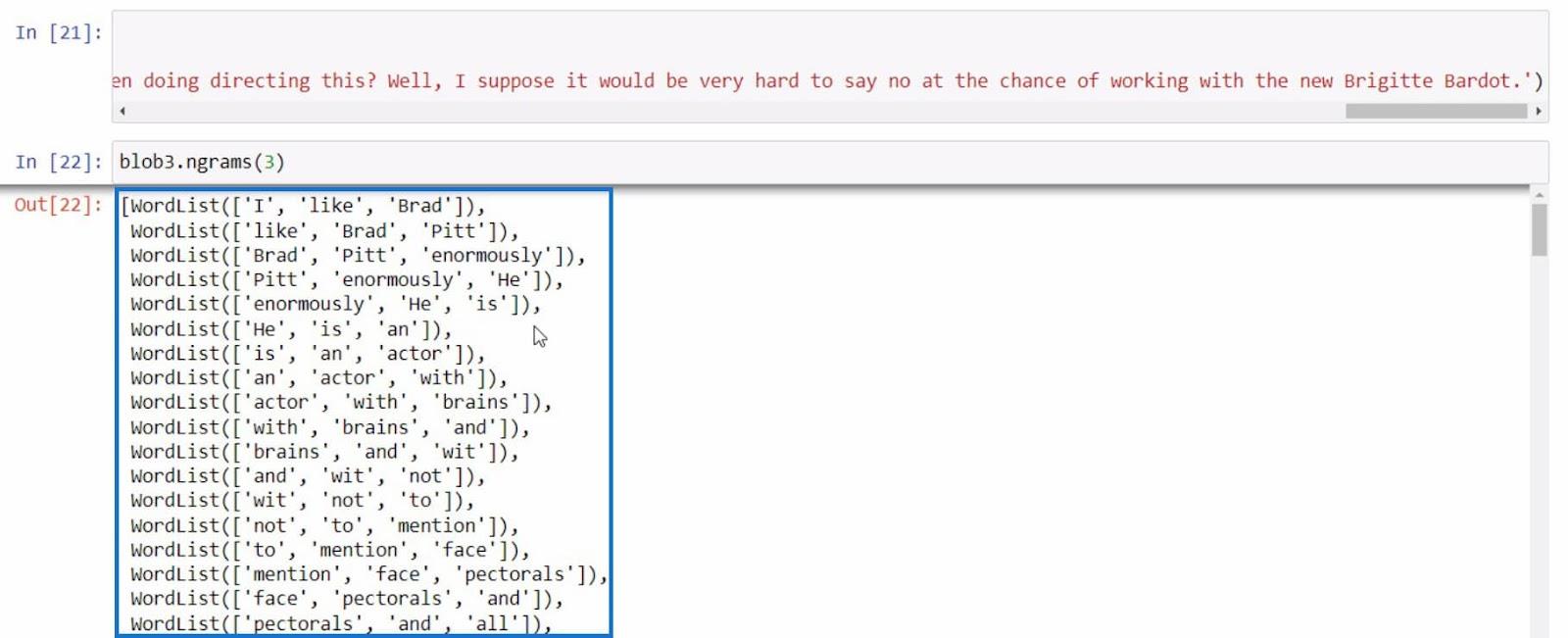

В качестве последнего примера попробуем еще раз использовать ngrams с более информативным предложением.

Со всеми этими примерами мы можем выполнять дополнительный анализ текста в Python на основе результатов, которые мы получаем с помощью функции ngrams .

Python II для пользователей LuckyTemplates — новый курс на платформе On-Demand

Как загрузить примеры наборов данных в Python

с помощью Python в LuckyTemplates | Набор данных и строковая функция

Заключение

Подводя итог, вы узнали о различных функциях, которые можно использовать для выполнения анализа текста в Python.

Это функция .tokenize для разделения слов в предложении, функция .join для объединения токенизированных слов, функция .tags для проверки частей речи слов и функция ngrams для просмотра сочетания слов.

Кроме того, вы узнали, как исправлять ошибки, подобные тому, что мы делали в функции .tags с помощью Anaconda Prompt . Вы также узнали, как импортировать, создавать текстовые BLOB-объекты и использовать эту библиотеку для выполнения анализа текста в Python .

Всего наилучшего,

Гаэллим

В этом руководстве показано, как в конечном итоге можно рассчитать разницу между еженедельными результатами продаж с помощью DAX в LuckyTemplates.

Что такое self в Python: примеры из реального мира

Вы узнаете, как сохранять и загружать объекты из файла .rds в R. В этом блоге также рассказывается, как импортировать объекты из R в LuckyTemplates.

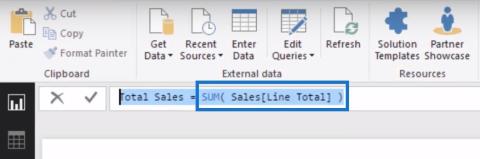

В этом руководстве по языку программирования DAX вы узнаете, как использовать функцию GENERATE и как динамически изменять название меры.

В этом учебном пособии рассказывается, как использовать технику многопоточных динамических визуализаций для создания аналитических сведений из динамических визуализаций данных в ваших отчетах.

В этой статье я пройдусь по контексту фильтра. Контекст фильтра — одна из основных тем, с которой должен ознакомиться любой пользователь LuckyTemplates.

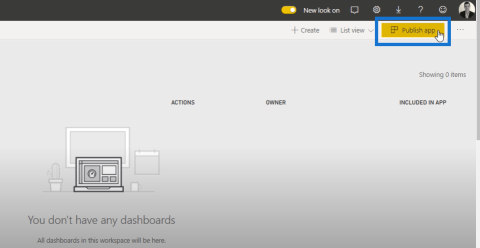

Я хочу показать, как онлайн-служба LuckyTemplates Apps может помочь в управлении различными отчетами и аналитическими данными, созданными из различных источников.

Узнайте, как рассчитать изменения вашей прибыли, используя такие методы, как разветвление показателей и объединение формул DAX в LuckyTemplates.

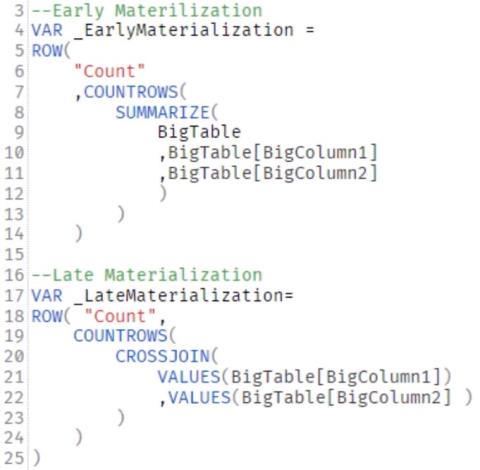

В этом руководстве будут обсуждаться идеи материализации кэшей данных и то, как они влияют на производительность DAX при предоставлении результатов.

Если вы все еще используете Excel до сих пор, то сейчас самое подходящее время, чтобы начать использовать LuckyTemplates для своих бизнес-отчетов.