Wat is zelf in Python: voorbeelden uit de echte wereld

Wat is zelf in Python: voorbeelden uit de echte wereld

In deze blog laten we u zien hoe u tekstanalyse kunt uitvoeren met behulp van Python om woordsoorten in tekstgegevens binnen LuckyTemplates te identificeren. We behandelen de stappen voor het gebruik van Python voor tekstanalyse en geven voorbeelden en tips om u op weg te helpen met uw eigen tekstanalyseprojecten. Je kunt de volledige video van deze tutorial onderaan deze blog bekijken.

Inhoudsopgave

Data bron

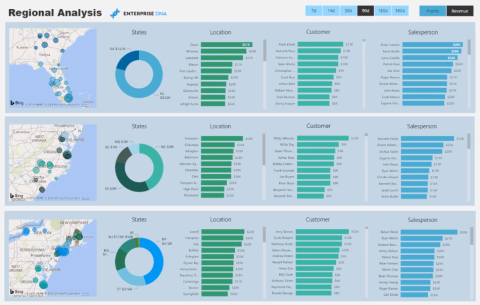

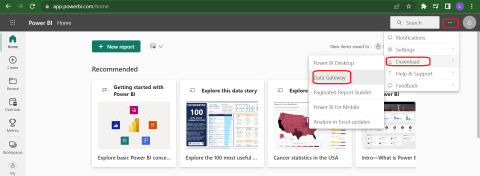

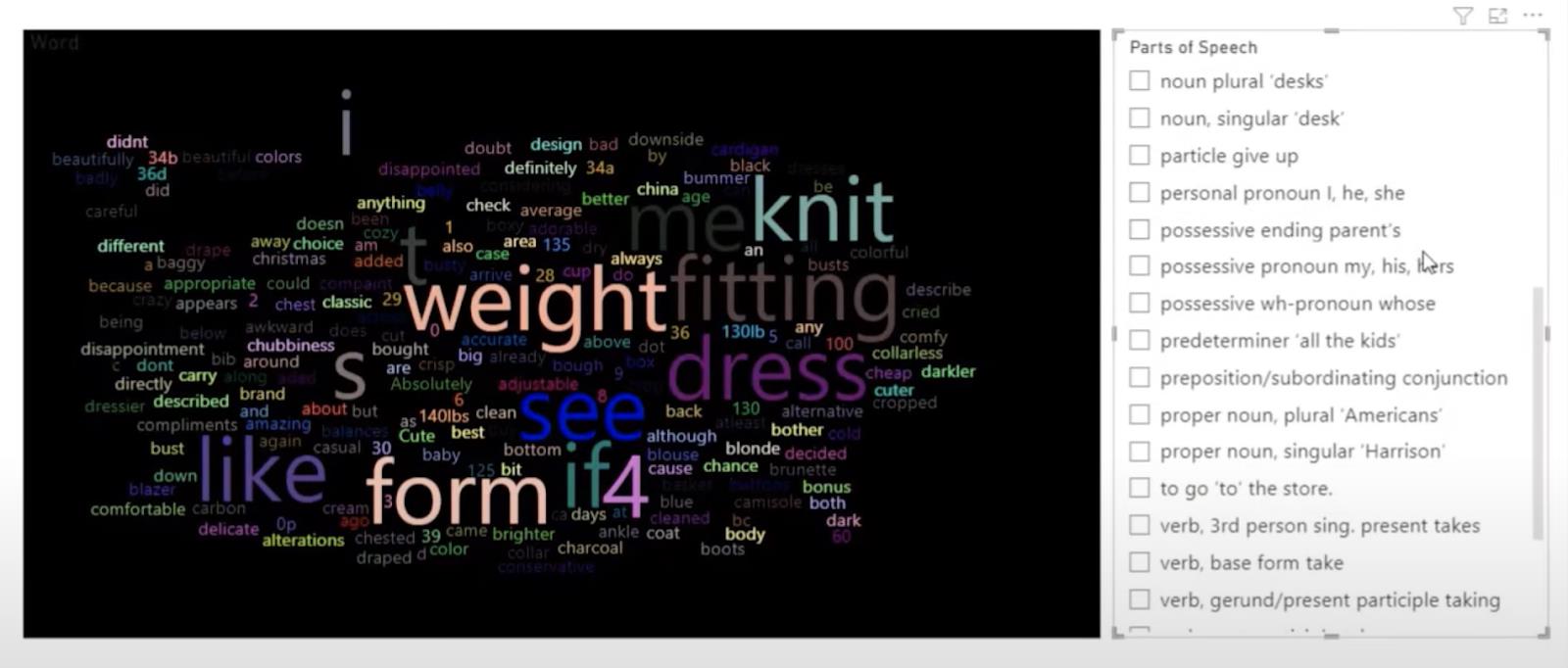

In deze zelfstudie gebruiken we een kant-en-klare woordwolk met de teksten die we gaan evalueren. Dit wordt weergegeven aan de linkerkant van de onderstaande afbeelding. Aan de rechterkant hebben we de filters om de verschillende woordsoorten te identificeren, bijvoorbeeld bijvoeglijke naamwoorden of werkwoorden.

We kunnen woorden eruit filteren die bijwoorden, zelfstandige naamwoorden, verschillende soorten zelfstandige naamwoorden of werkwoorden en werkwoordbases zijn. Dit is erg handig bij het maken van een marketingcampagne en het zoeken naar woorden in uw klantrecensies.

Laten we beginnen met het openen van onze Power Query- editor.

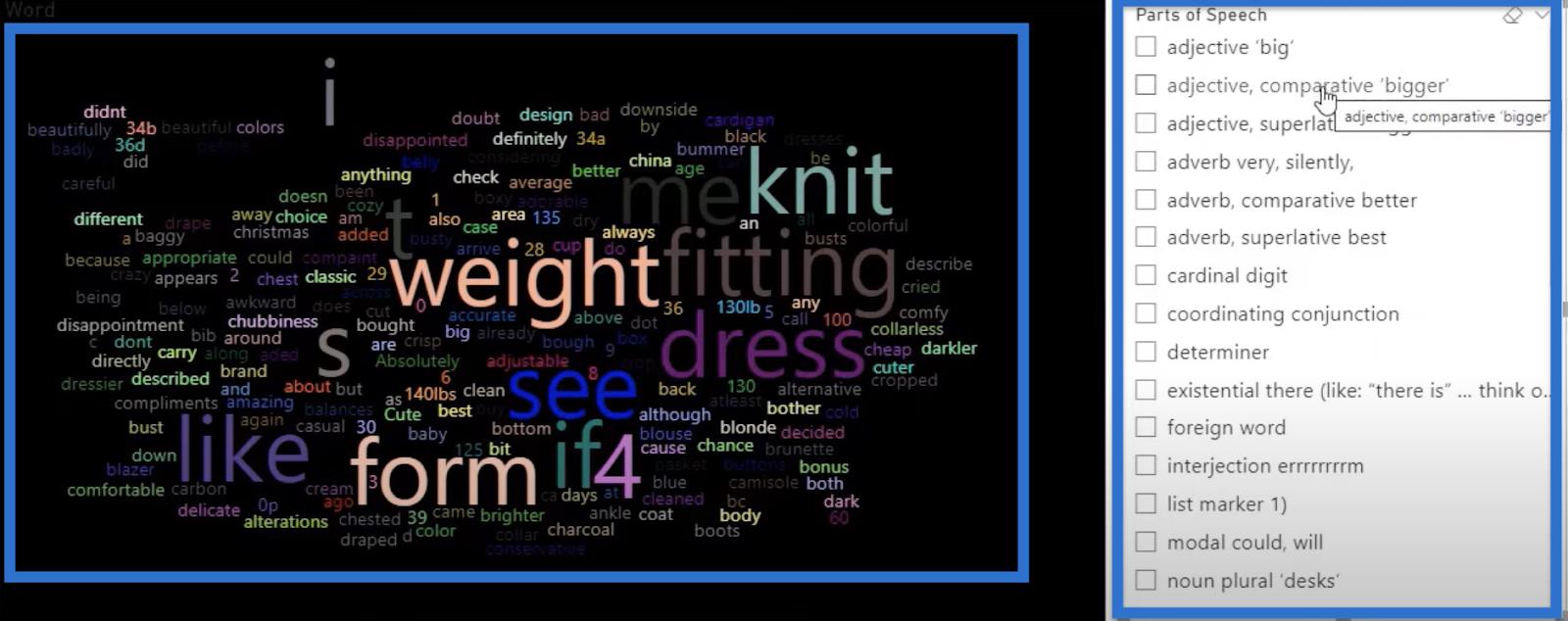

In onze brongegevens hebben we kolommen voor de ID's, leeftijd, titel en recensietekst. We zullen ons concentreren op de kolom Review Text en we zullen deze analyseren om onze tekstanalyse uit te voeren. Er zijn ook andere categorieën die nuttig kunnen zijn in onze analyse.

Tekstanalyse met behulp van Python

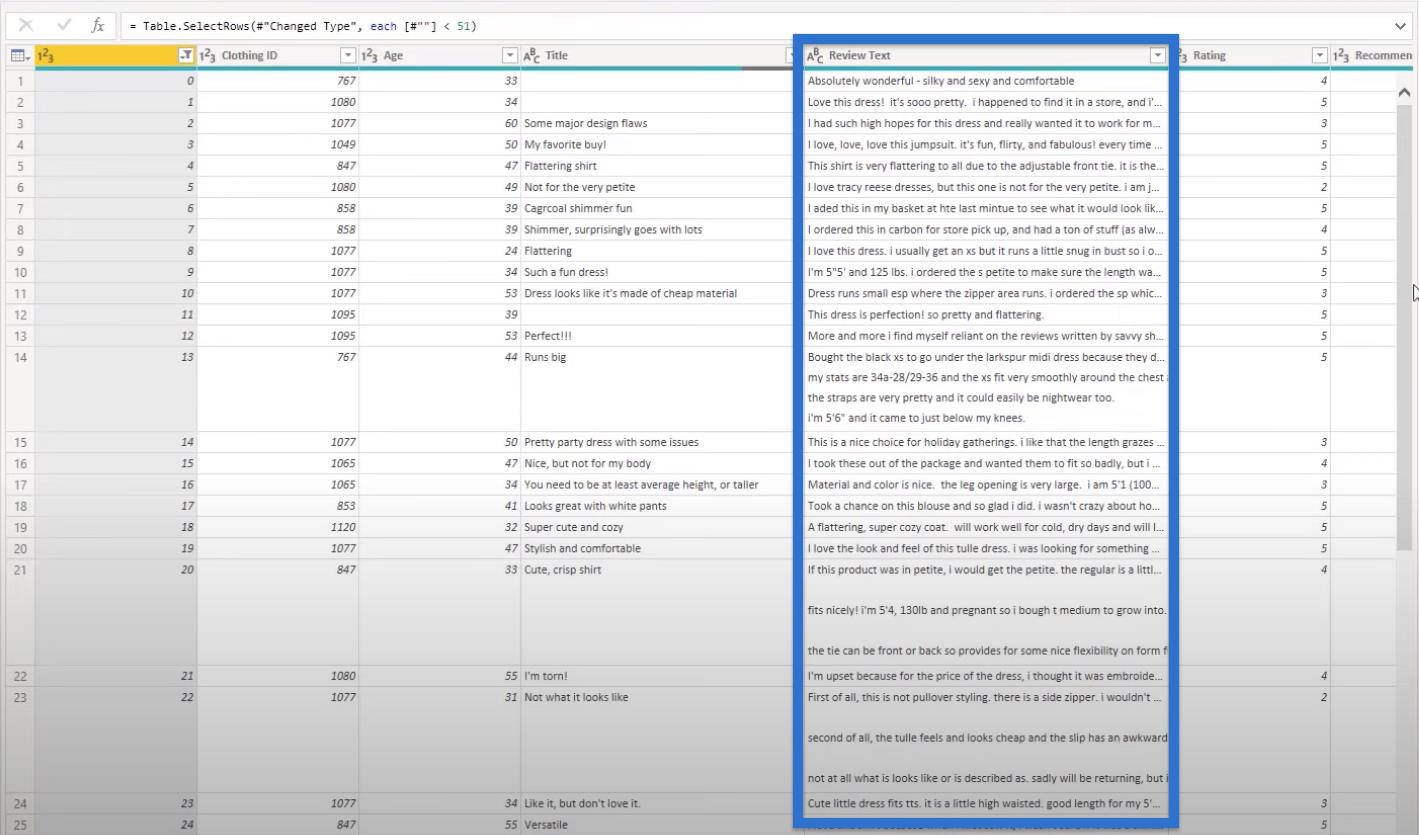

Laten we beginnen met de normale gegevens die we hebben binnengebracht. Het eerste wat we gaan doen is de rijen filteren, omdat we veel gegevens hebben, en als we tekstanalyse doen, kost dat tijd.

Om onze gegevens te filteren, neemt u de eerste 50 rijen om de tekstanalyse iets sneller te maken.

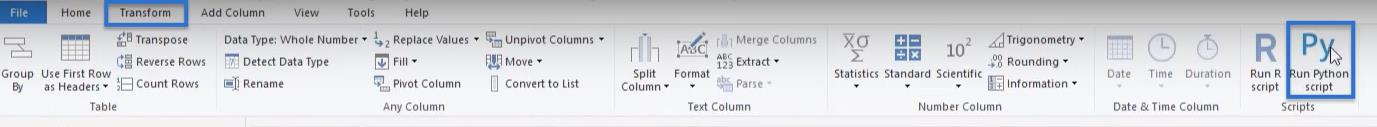

Eenmaal uitgefilterd, ga je naar Transformeren en Python- script uitvoeren . We zullen hier alles coderen omdat er niet veel code is.

De pakketten importeren

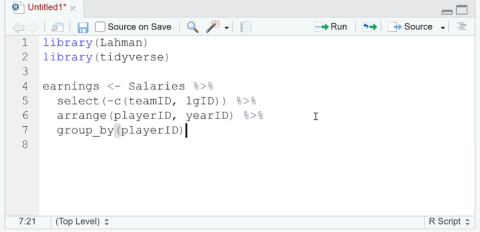

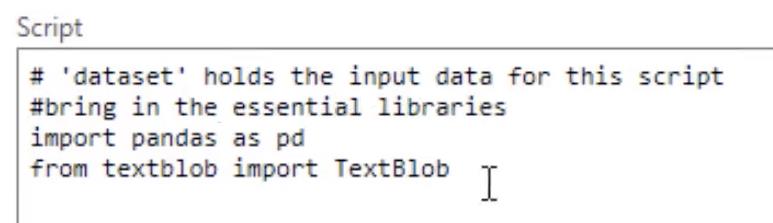

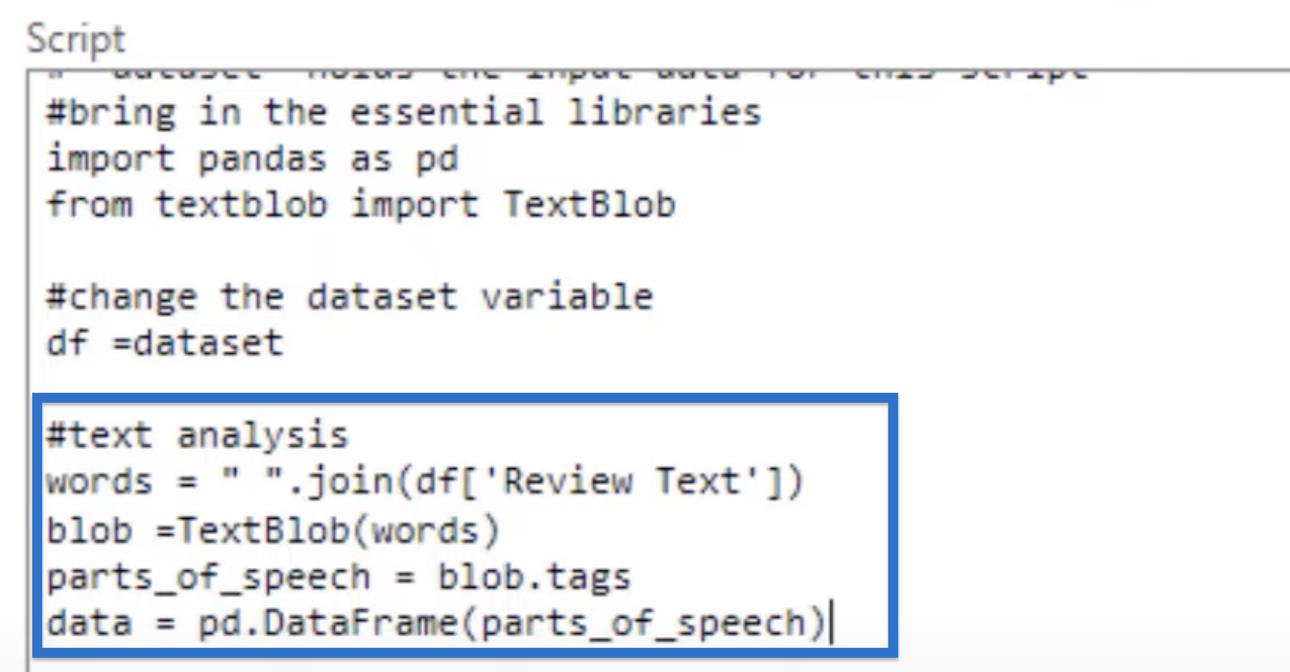

Laten we twee pakketten binnenhalen voor onze Python-tekstanalyse met behulp van onze Python- scripteditor. We zullen " panda's importeren als pd" , onze bibliotheek voor gegevensmanipulatie die moet worden opgeslagen als variabele pd. En dan " from text blob " , zullen we " TextBlob importeren " met een hoofdletter tussen de woorden.

We kunnen altijd documenteren wat we doen door een documentstring te plaatsen. Laten we #breng de essentiële bibliotheken bovenop onze pakketten schrijven.

De variabele hernoemen

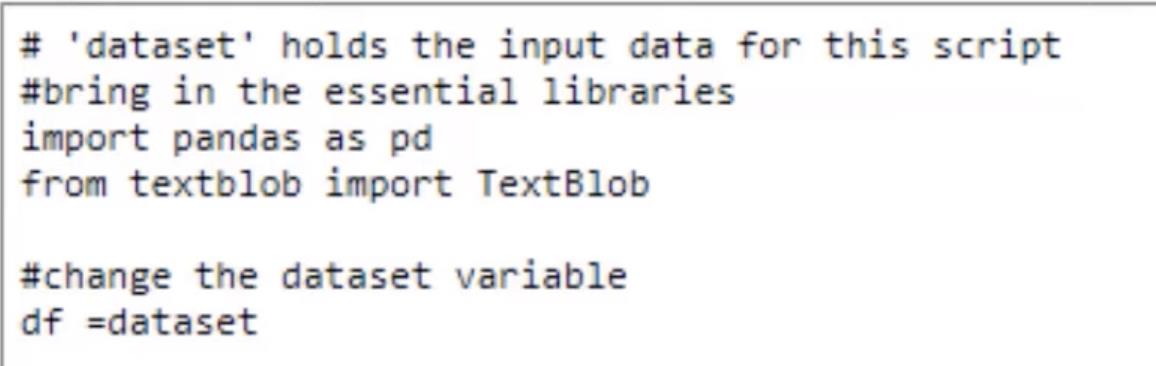

In de eerste regel van ons script staat deze regel van LuckyTemplates die zegt # 'dataset' bevat de invoergegevens voor dit script. Deze regel zegt dat onze data een dataset wordt genoemd.

Dus laten we dat veranderen, want het duurt te lang om "dataset" te schrijven. Typ #change the dataset variabele en df = dataset in de volgende regel.

Nu is het korter om onze variabele te schrijven.

De tekstanalyse uitvoeren

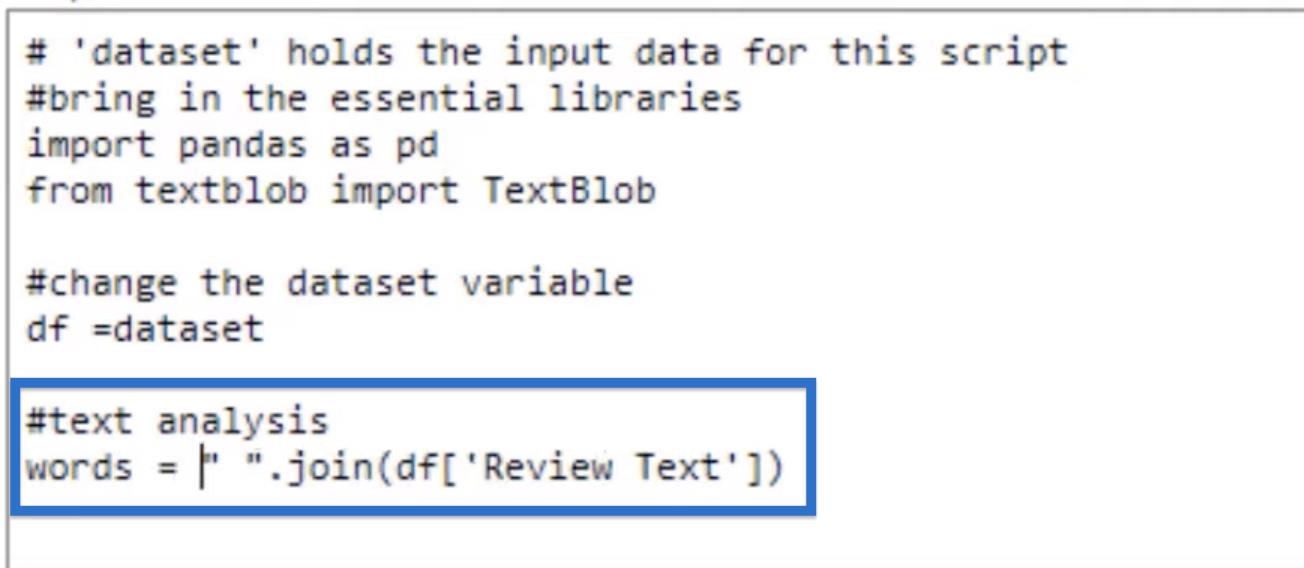

Laten we doorgaan met onze tekstanalyse. Bedenk dat onze recensieteksten in een kolom met individuele cellen staan. Deze opstelling is niet echt nuttig voor ons omdat we alle teksten bij elkaar willen hebben zodat we er een analyse op kunnen uitvoeren.

We willen echter niet dat ze worden samengevoegd zonder spatie, dus laten we onze code beginnen met een spatie tussen dubbele aanhalingstekens .

Laten we dan .join toevoegen en onze review-tekstkolom isoleren met behulp van onze df- variabele, die de dataset bevat. Typ 'Review Text' tussen haakjes die de kolom isoleert.

Deze code voegt alles toe, maar we moeten het opslaan, dus laten we een variabele maken met de naam woorden.

Zodra we alle woorden bij elkaar hebben, kunnen we onze tekstblob gebruiken om de woorden te analyseren.

Het eerste dat u moet doen, is onze woordsoorten maken met behulp van de blob- variabele die we nodig hebben om woorden door te geven aan een tekst-blob. We gaan die tekstblob gebruiken en de tekst doorgeven, wat onze woorden zijn . Dit wordt getypt als blob = TextBlob(words).

Nu we die blob hebben, nemen we die en maken we onze parts_of_speech- variabele met behulp van blob.tags . De tags zijn de afkortingen voor elk van de woordsoorten.

Wat we vervolgens gaan doen, is dit opslaan als een dataframe met behulp van Panda's die we hebben binnengebracht. Laten we het onze data noemen die gelijk is aan de pd.DataFrame en we brengen onze parts_of_speech binnen .

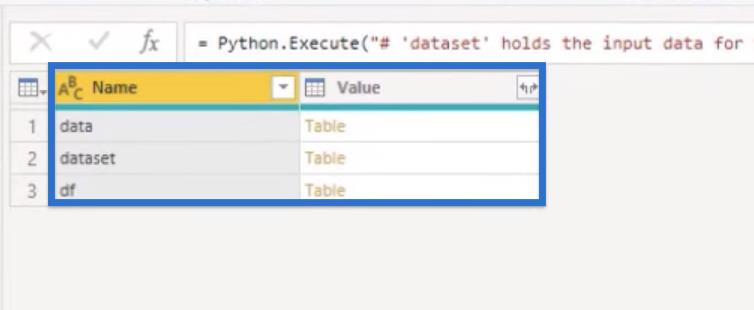

Laten we op OK klikken om onze code uit te voeren. Nadat we onze code hebben uitgevoerd, zouden we een tabel met onze variabelen moeten krijgen. We hebben de dataset of onze originele gegevens. We hebben ook onze gegevens en de df .

Als u niet de beoogde resultaten heeft verkregen, laten we u de verschillende manieren zien om fouten in de code te voorkomen.

De code voor tekstanalyse in Python repareren

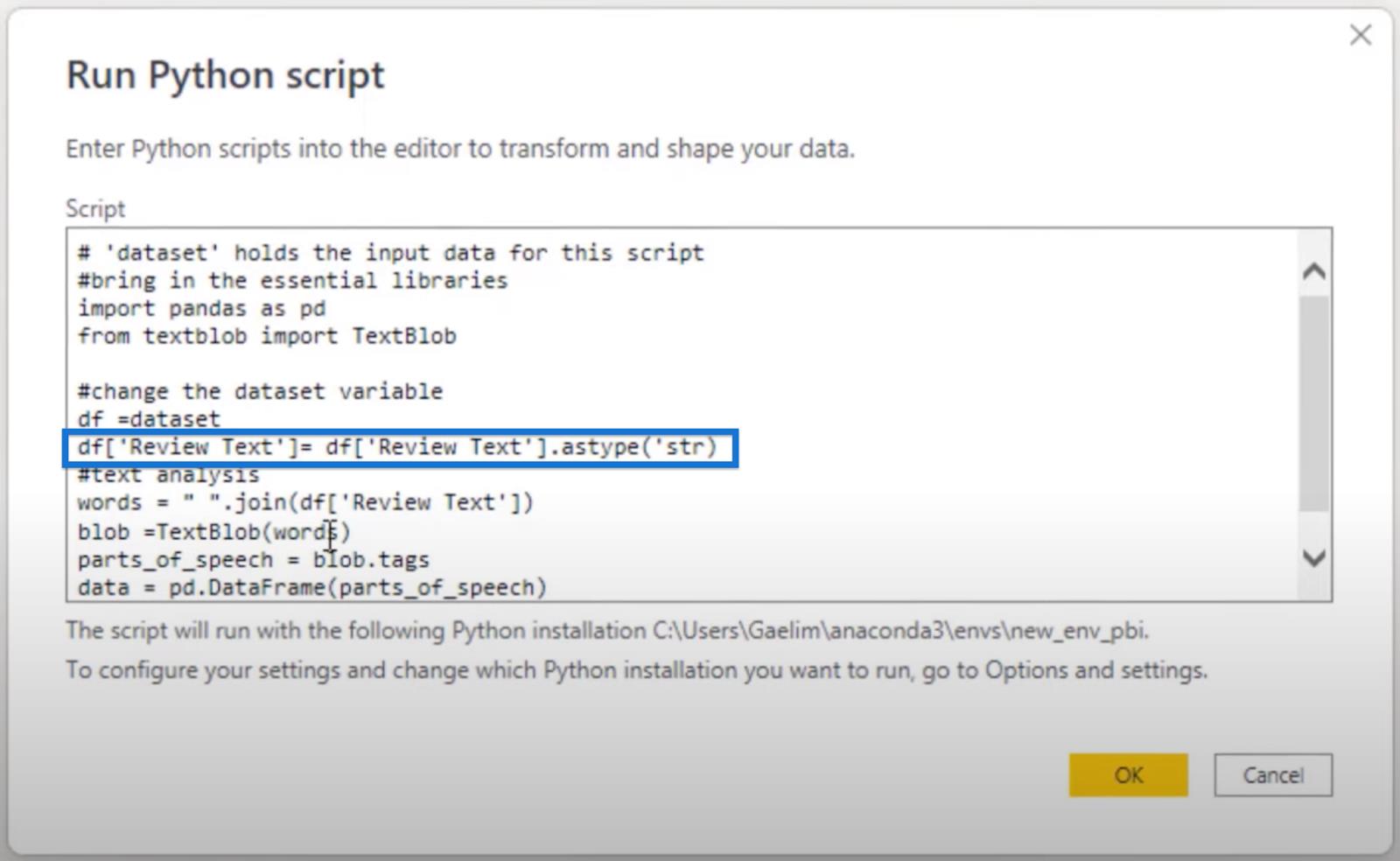

Soms moeten we heel expliciet zijn bij het wijzigen van de opmaak van de tekst waar we ons mee bezig houden.

We kunnen dat doen door onze df- variabele aan te roepen, 'Review Text ' tussen haakjes te isoleren en vervolgens het type te wijzigen in strings met behulp van .astype('str') . Sla dit dan gewoon opnieuw op in de df- variabele.

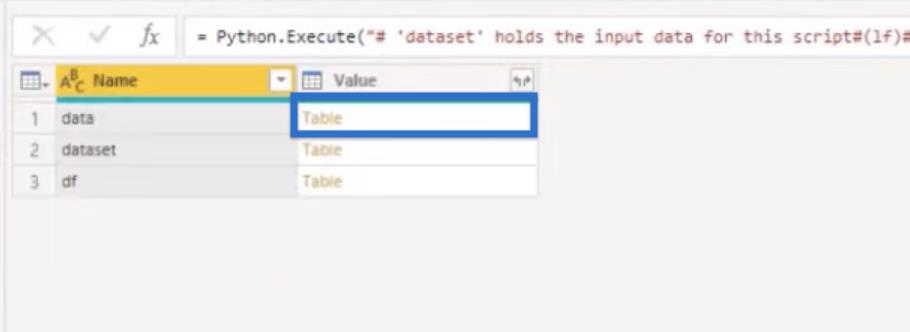

Klik op OK om de code opnieuw uit te voeren. We zouden dezelfde resultaten moeten krijgen als eerder.

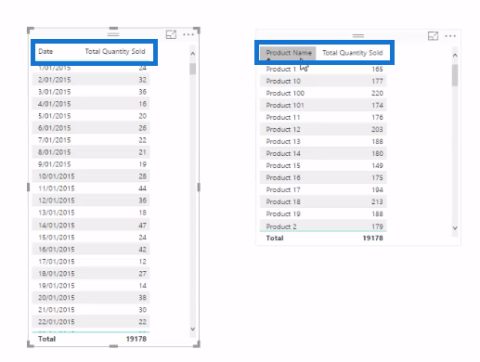

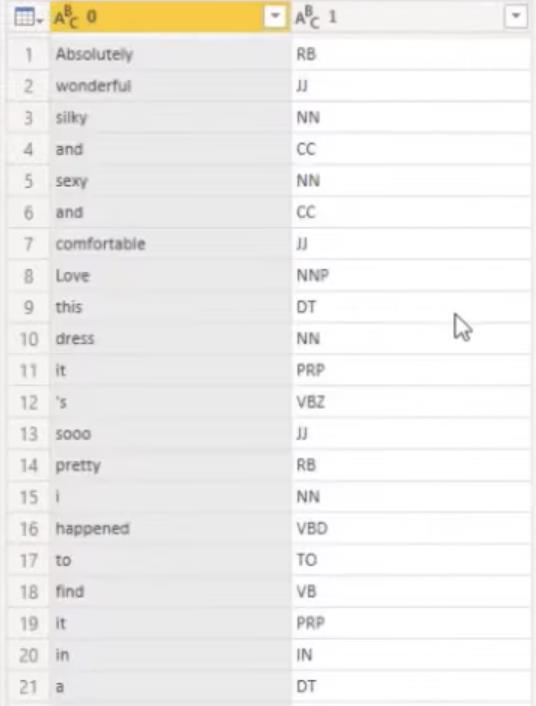

Nu willen we onze gegevens openen , de laatste variabele die we hebben ingevoerd om te zien hoe dat eruit ziet.

We zouden al onze woorden moeten laten opsplitsen in woordsoorten. We hebben onze kolommen nog geen naam gegeven, maar dat kunnen we gemakkelijk doen.

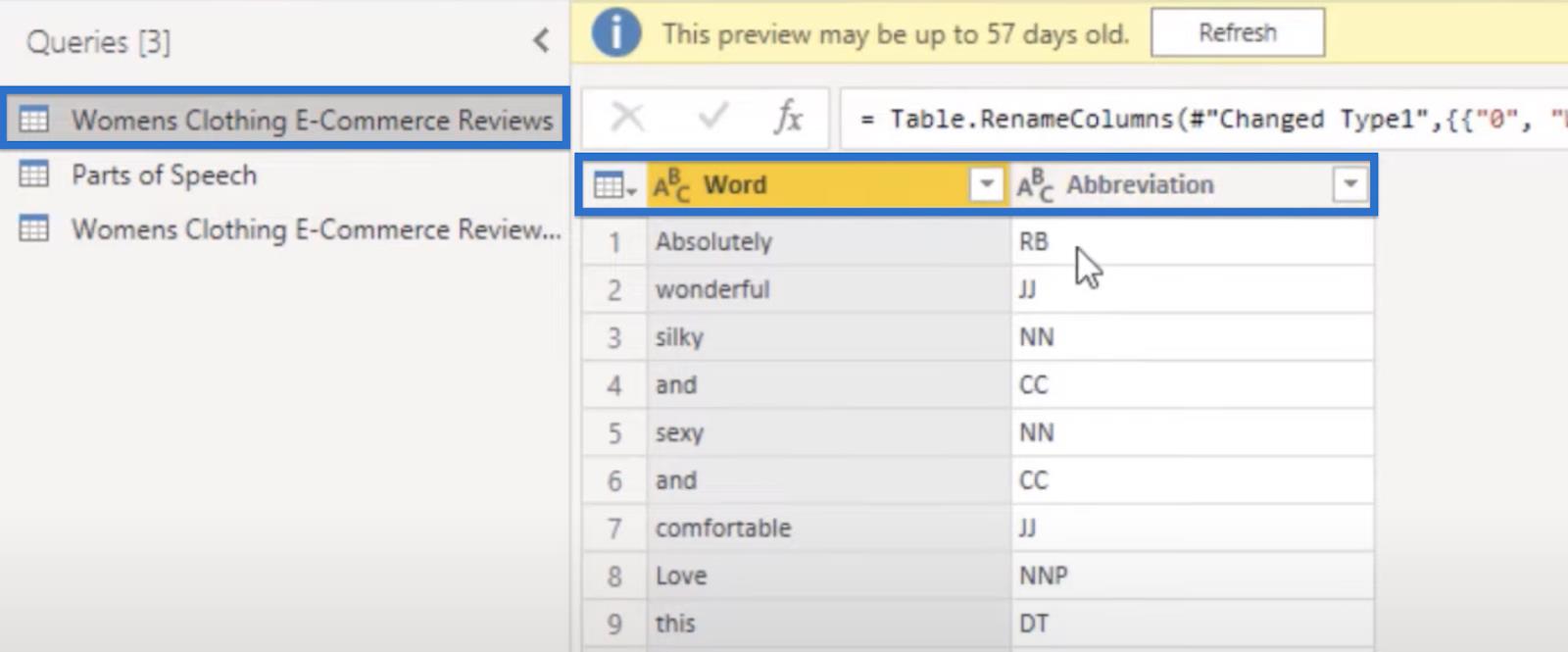

In de oude versie van dezelfde tekstanalyse noemde ik de eerste kolom Word en de tweede Afkorting .

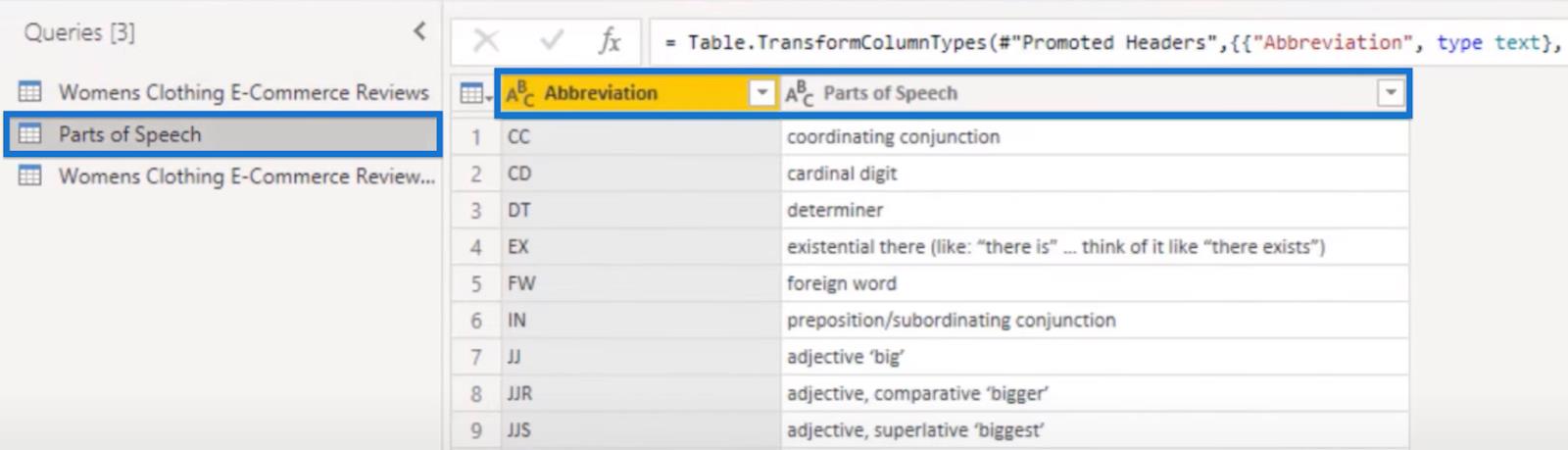

In de Parts of Speech- query brengen we de eigenlijke woorden voor deze afkortingen in en verbinden ze allemaal met elkaar.

Laten we nu sluiten en toepassen .

Met de stappen die we hebben uitgevoerd, konden we filteren door de verschillende woordsoorten die we identificeerden met behulp van een eenvoudige Python- code. Het geeft ons deze visual in LuckyTemplates, waar we onze tekst eenvoudig kunnen filteren op basis van de categorie van spraaksoorten waarin ze vallen.

Tekstanalyse in Python | Een introductie

Python door de gebruiker gedefinieerde functies | Een overzicht

van Python-lijst en for-lus in LuckyTemplates

Conclusie

Als data-analist kunt u de behoefte tegenkomen om inzichten en betekenis te halen uit grote hoeveelheden ongestructureerde tekstgegevens. Wat u hebt geleerd, is een nuttige benadering om tekstgegevens te begrijpen door middel van tekstanalyse.

U kunt tekst nu gemakkelijk opsplitsen in kleinere eenheden, zoals woorden en zinnen, en deze eenheden vervolgens analyseren op patronen en relaties. U kunt al deze doelen bereiken met behulp van tekstanalyse in Python en LuckyTemplates.

Al het beste,

Wat is zelf in Python: voorbeelden uit de echte wereld

Je leert hoe je objecten uit een .rds-bestand in R opslaat en laadt. In deze blog wordt ook besproken hoe je objecten uit R naar LuckyTemplates importeert.

In deze tutorial over DAX-coderingstaal leert u hoe u de functie GENERATE gebruikt en hoe u de titel van een maat dynamisch wijzigt.

Deze zelfstudie behandelt hoe u de Multi Threaded Dynamic Visuals-techniek kunt gebruiken om inzichten te creëren op basis van dynamische gegevensvisualisaties in uw rapporten.

In dit artikel zal ik de filtercontext doornemen. Filtercontext is een van de belangrijkste onderwerpen waarover elke LuckyTemplates-gebruiker in eerste instantie zou moeten leren.

Ik wil laten zien hoe de online service LuckyTemplates Apps kan helpen bij het beheren van verschillende rapporten en inzichten die uit verschillende bronnen zijn gegenereerd.

Leer hoe u wijzigingen in uw winstmarge kunt berekenen met behulp van technieken zoals vertakking van metingen en het combineren van DAX-formules in LuckyTemplates.

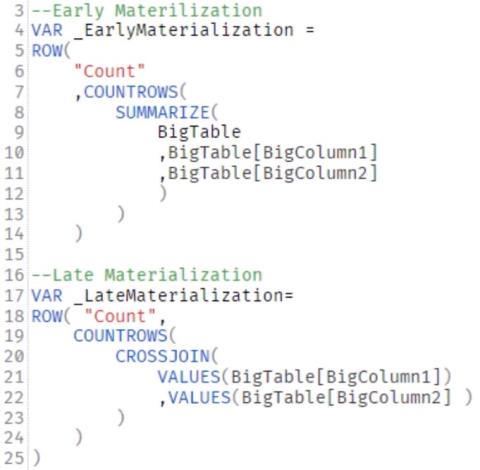

Deze tutorial bespreekt de ideeën van materialisatie van datacaches en hoe deze de prestaties van DAX beïnvloeden bij het leveren van resultaten.

Als u tot nu toe nog steeds Excel gebruikt, is dit het beste moment om LuckyTemplates te gaan gebruiken voor uw zakelijke rapportagebehoeften.

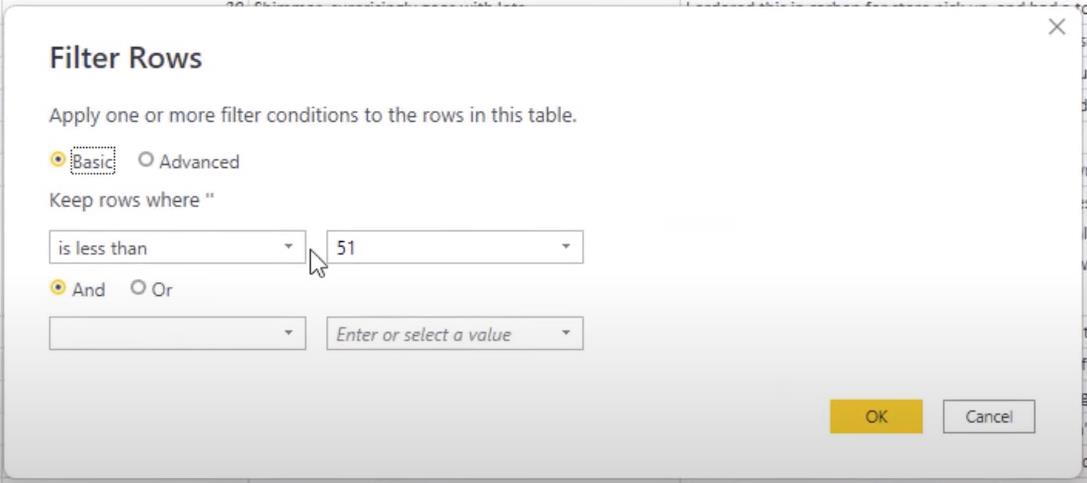

Wat is LuckyTemplates Gateway? Alles wat u moet weten