Europa utworzy grupę zadaniową ChatGPT

Organ zrzeszający krajowe organy nadzorujące prywatność w Europie poinformował w czwartek, że powołał grupę zadaniową zajmującą się ChatGPT

Uczenie się przez wzmacnianie – poddziedzina uczenia maszynowego – obejmuje techniki szkoleniowe AI, które wykorzystują „nagrody” do kierowania polityką oprogramowania w kierunku konkretnych celów. Innymi słowy, jest to proces, w którym sztuczna inteligencja będzie próbowała różnych działań, z każdej odpowiedzi wyciągała wnioski, czy dane działanie przynosi lepsze rezultaty, czy nie, a następnie wzmacniała działania, które zadziałały, tj. automatyczne przepracowywanie i modyfikowanie swoich algorytmów w wielu iteracjach daje najlepsze rezultaty. W ostatnim czasie uczenie się przez wzmacnianie zaczęto wykorzystywać do modelowania wpływu zasad społecznych, do tworzenia modeli sztucznej inteligencji o wyjątkowo dobrych możliwościach w grach lub programowalnych robotów, które potrafią samoleczyć się i regenerować po irytujących problemach z oprogramowaniem.

Chociaż technika uczenia się przez wzmacnianie charakteryzuje się dużą elastycznością i może być stosowana w wielu różnych modelach i celach, ma niefortunną wadę: jest nieskuteczna. Wytrenowanie modelu sztucznej inteligencji przy użyciu technik uczenia się przez wzmacnianie wymaga wielu różnych interakcji w środowisku symulowanym lub rzeczywistym, czyli znacznie więcej niż w przypadku, gdy człowiek musi nauczyć się określonego zadania. Aby częściowo przezwyciężyć ten problem, szczególnie w dziedzinie gier wideo, badacze sztucznej inteligencji w Google zaproponowali niedawno zastosowanie nowego algorytmu o nazwie Simulated Policy Learning (w skrócie SimPLe), który wykorzystuje proste modele gier wideo do uczenia się i ulepszania polityk jakości przy wyborze działań technik uczenia się przez wzmacnianie.

Naukowcy opisali algorytm w nowo opublikowanym artykule zatytułowanym „Model-Based Reinforcement Learning for Atari”, a także w dokumencie dołączonym do kodu open source.

„Na wysokim poziomie ideą badaczy przy opracowywaniu algorytmu SimPLe było naprzemienne ustalanie modelu charakterystyki gry i wykorzystywanie tego modelu do optymalizacji polityki (z technikami uczenia się przez wzmacnianie bez modelu) w środowisku symulacji gry. Podstawowe zasady leżące u podstaw tego algorytmu są dobrze ugruntowane i stosowane w wielu najnowszych metodach uczenia się przez wzmacnianie w oparciu o modele” – podzielili się naukowcy z zespołu Google AI Łukasz Kaiser i Dumitru Erhan.

Jak wyjaśnili obaj badacze, szkolenie systemu sztucznej inteligencji do grania w grę wymaga przewidywania tekstur kolejnych klatek gry docelowej, które są określone przez sekwencję klatek i kombinację poleceń (np. „w lewo”, „wewnątrz”, „w prawo”, „ do przodu”, „do tyłu”). Ponadto badacze wykazali również, że udany model może generować „trajektorie”, które można wykorzystać w szkoleniu zasad programu agenta gier, co zmniejszy potrzebę polegania na złożonych sekwencjach obliczeniowych w grze.

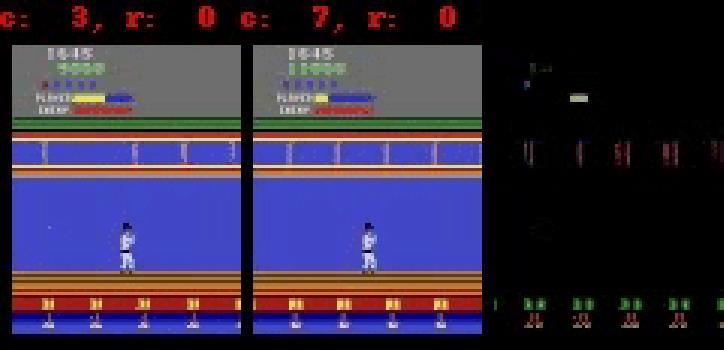

Algorytm SimPLe robi dokładnie to. Do przewidzenia następnej klatki z nagrodą potrzebne są 4 klatki jako dane wejściowe, a po pełnym przeszkoleniu algorytm generuje „wdrożenia” – przykładowe sekwencje sekwencji działań, obserwacji i wyników – wykorzystywane do ulepszania polityki (Kaiser i Erhan zauważają, że algorytm SimPLe wykorzystuje tylko wdrożenia o średniej długości, aby zminimalizować błąd przewidywania).

W testach trwających równowartość 2 godzin rozgrywki (100 000 interakcji) agenci stosujący dostosowane zasady SimPLe osiągnęli maksymalne wyniki w dwóch grach testowych (Pong i Freeway), generując jednocześnie niemal doskonałe prognozy aż do 50 kroków w przyszłość.

Czasami obaj badacze próbowali także zebrać drobne, ale bardzo istotne szczegóły z gier, co kończyło się niepowodzeniem. Kaiser i Erhan przyznają, że algorytm ten nadal nie do końca dorównuje wydajnością standardowych metod uczenia się przez wzmacnianie. Jednak SimPLe może być ponad dwukrotnie skuteczniejszy pod względem uczenia, a zespół ma nadzieję, że przyszłe badania pomogą znacząco poprawić wydajność algorytmu.

„Głównym celem metod uczenia się przez wzmacnianie opartych na modelach są środowiska, w których interakcje okazują się złożone, powolne lub wymagają etykietowania przez człowieka, na przykład w wielu zadaniach robotycznych. W takim środowisku symulator pozwoliłby nam lepiej zrozumieć środowisko programów agentowych, co z kolei mogłoby prowadzić do nowych, lepszych i szybszych sposobów robienia rzeczy. Wielozadaniowe uczenie się przez wzmacnianie”.

Organ zrzeszający krajowe organy nadzorujące prywatność w Europie poinformował w czwartek, że powołał grupę zadaniową zajmującą się ChatGPT

Duńscy i amerykańscy naukowcy współpracowali nad opracowaniem systemu sztucznej inteligencji o nazwie life2vec, zdolnego do przewidywania czasu śmierci człowieka z dużą dokładnością.

Algorytm sztucznej inteligencji o nazwie Audioflow może nasłuchiwać dźwięku oddawania moczu, aby skutecznie i skutecznie identyfikować nieprawidłowe wypływy moczu i powiązane z nimi problemy zdrowotne pacjenta.

Starzenie się i spadek liczby ludności Japonii spowodował, że w kraju brakuje znacznej liczby młodych pracowników, szczególnie w sektorze usług.

Użytkownik Reddita o imieniu u/LegalBeagle1966 jest jednym z wielu użytkowników zakochanych w Claudii, dziewczynie przypominającej gwiazdę filmową, która często udostępnia na tej platformie uwodzicielskie selfie, nawet nagie.

Microsoft właśnie ogłosił, że w jego programie AI for Good weźmie udział 12 kolejnych firm technologicznych.

Użytkownik @mortecouille92 wykorzystał moc narzędzia do projektowania graficznego Midjourney i stworzył wyjątkowo realistyczne wersje słynnych postaci Dragon Ball, takich jak Goku, Vegeta, Bulma i starszy Kame. .

Po prostu dodając pewne warunki lub konfigurując pewne scenariusze, ChatGPT może udzielić bardziej trafnych odpowiedzi na Twoje zapytania. Przyjrzyjmy się sposobom poprawy jakości odpowiedzi ChatGPT.

Midjourney to system sztucznej inteligencji, który wywołał ostatnio „gorączkę” w społeczności internetowej i świecie artystów ze względu na niezwykle piękne obrazy, które nie ustępują tym, które tworzą prawdziwi artyści.

Kilka dni po ogłoszeniu przez Chiny wybuchu epidemii, mając dostęp do danych dotyczących globalnej sprzedaży biletów lotniczych, system sztucznej inteligencji BlueDot w dalszym ciągu dokładnie przewidywał rozprzestrzenianie się wirusa korona z Wuhan do Bangkoku, Seulu, Tajpej i Tokio.