Colunas calculadas no SharePoint | Uma visão geral

Descubra a importância das colunas calculadas no SharePoint e como elas podem realizar cálculos automáticos e obtenção de dados em suas listas.

Neste blog, discutiremos a análise de texto em Python para criar dados construídos a partir de conteúdo de texto. Isso ajudará você a analisar grandes quantidades de dados e a consumir menos tempo trabalhando em determinadas tarefas. Você também adquirirá conhecimento sobre textblob que lida com tarefas de processamento de linguagem natural.

A análise de texto é o processo de análise de textos usando códigos para processos automatizados de produção e agrupamento de dados de texto.

Antes de prosseguirmos, talvez seja necessário instalar a biblioteca que usaremos neste tutorial.

Índice

Implementando análise de texto em Python

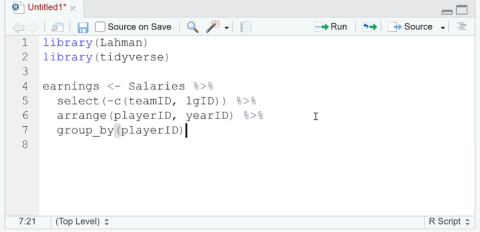

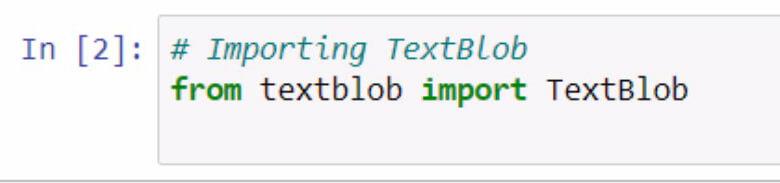

Vamos começar importando textblob . Lembre-se de documentar o que você está fazendo com o uso de comentários.

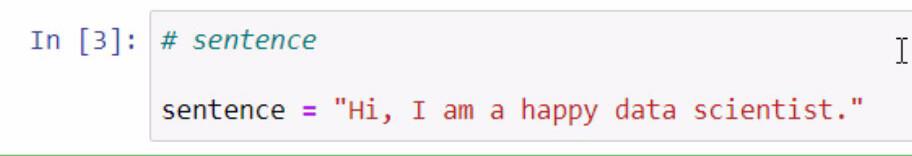

Ao executar o código acima, agora temos acesso à biblioteca textblob . A próxima etapa que faremos é criar uma frase que usaremos em nossos exemplos. Faremos isso armazenando uma sentença em uma variável chamada sentença .

Lembre-se de colocar a frase que deseja adicionar entre aspas duplas.

O textblob é uma ótima biblioteca onde podemos criar um blob e usar algumas de suas funções para nossa análise de texto em Python .

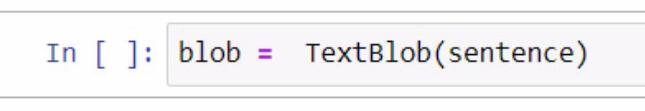

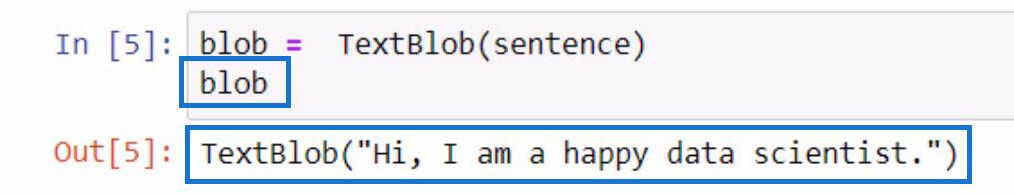

Ao criar o blob, começamos criando uma variável e nomeando-a como blob . Nesta variável, precisamos adicionar TextBlob que é a biblioteca que estamos usando.

Dentro dos parênteses, utilizaremos a variável de sentença que contém a sentença que criamos anteriormente. Observe que você pode optar por digitar manualmente a própria frase dentro dos parênteses para esta parte.

Para verificar o que esta variável blob faz, você pode simplesmente inicializá-la digitando o nome da variável e pressionando as teclas Shift + Enter. A saída deve ser semelhante ao exemplo abaixo.

Como você pode ver no resultado, a frase que armazenamos na variável de frase agora está contida em TextBlob .

Tokenizando dados de texto em Python

Se você quiser remover algumas palavras de uma frase, podemos separar cada uma dessas palavras em partes individuais em uma lista. Com essa frase dada, o que vamos fazer é tokenizá-las ou separar cada palavra e colocá-la em uma lista.

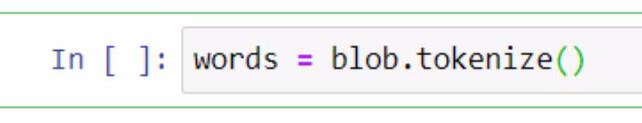

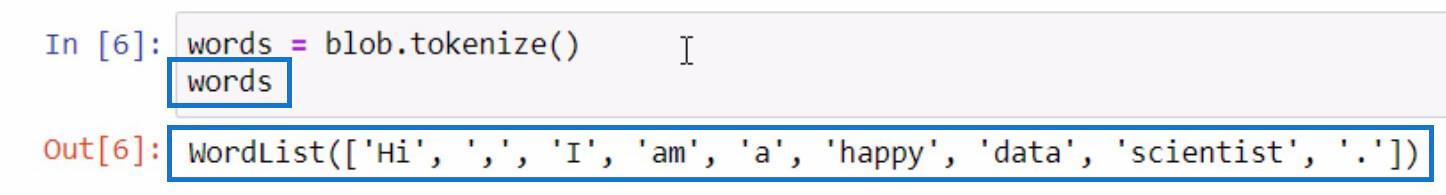

Para fazer isso, vamos utilizar a variável blob e usar a função tokenize . Em seguida, vamos armazená-lo em uma variável chamada words .

Vamos inicializar a variável words da mesma forma que fizemos ao inicializar a variável blob para ver o que está na lista tokenizada .

Como você pode ver, cada uma das palavras e até mesmo os sinais de pontuação agora estão separados em uma lista. É assim que a função tokenize funciona.

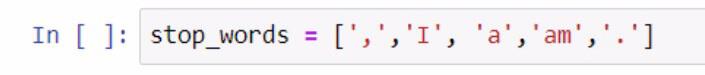

Agora que temos uma lista de palavras, podemos executar outra função a partir dela. Vamos criar outra lista de palavras que não queremos que sejam incluídas em nossa lista, como pontuações e artigos. Para executar esta etapa, consulte a captura de tela abaixo.

Ao criar a lista de palavras de parada, usamos colchetes para delimitar a lista de palavras de parada. Em seguida, cada uma das palavras de parada é colocada entre aspas simples e cada uma é separada por uma vírgula. Armazenamos a lista na variável stop_words .

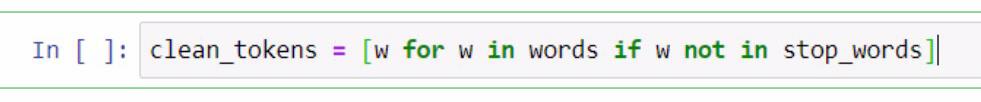

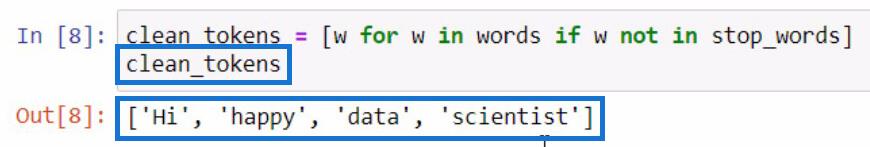

A partir daqui, vamos realizar uma compreensão de lista para remover palavras necessárias para conduzir a análise de texto em Python . Isso inclui frases de limpeza, tokenização e comparação de listas diferentes. Agora vamos comparar essas duas listas e criar uma nova lista de clean_tokens .

No código apresentado acima, utilizamos um espaço reservado que é w para representar um elemento . O que estamos tentando fazer nesta parte é obter o elemento na variável words se o elemento não existir na variável stop_words . Se vamos inicializar clean_tokens , este será o resultado.

Nesse processo, podemos limpar nossos tokens colocando em um processo de remoção de tokens desnecessários, como pontuações e artigos. Por causa disso, só temos as palavras essenciais em nossa lista.

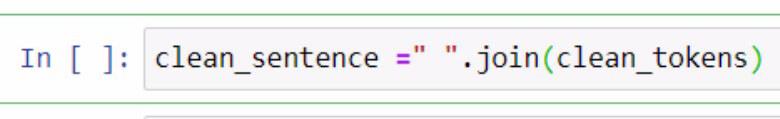

Juntando tokens para formar uma frase em Python

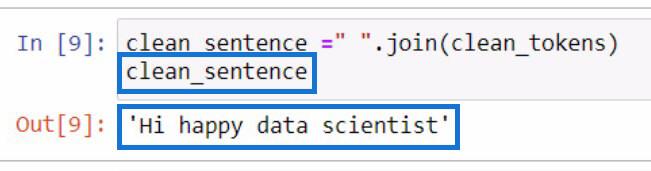

Agora que separamos os tokens limpos , vamos tentar colocá-los juntos em uma frase. Para fazer isso, temos que utilizar a função .join . Verifique o exemplo abaixo para referência.

No exemplo acima, criamos uma variável chamada clean_sentence para armazenar nossos tokens limpos que serão combinados em uma frase. Você também pode notar que adicionamos um espaço entre aspas duplas e a função .join . Dentro dos parâmetros, incluímos a variável clean_tokens .

Esta será a saída se inicializarmos a variável clean_sentence .

Notavelmente, a frase não parece correta porque removemos os artigos e as pontuações anteriormente.

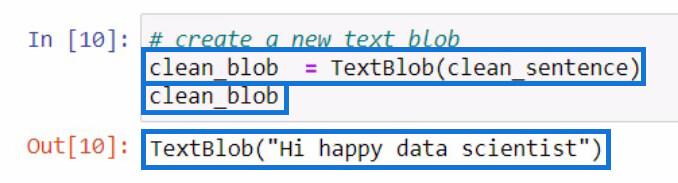

Depois de criar a clean_sentence , vamos tentar criar um novo textblob contendo a clean_sentence que acabamos de criar. Em seguida, vamos armazená-lo em uma nova variável clean_blob .

Dissecando um textblob para partes do discurso usando a função .tags

A partir desse blob de análise, podemos usar as partes desse blob para verificar as partes do discurso ou fazer ainda mais alterações. Vamos tentar verificar as classes gramaticais de cada palavra em nosso novo textblob .

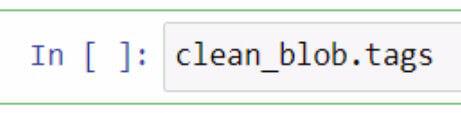

Para verificar as partes do discurso em um textblob, você deve usar a função .tags . Fiz isso utilizando nossa variável clean_blob e adicionei a função .tags logo em seguida.

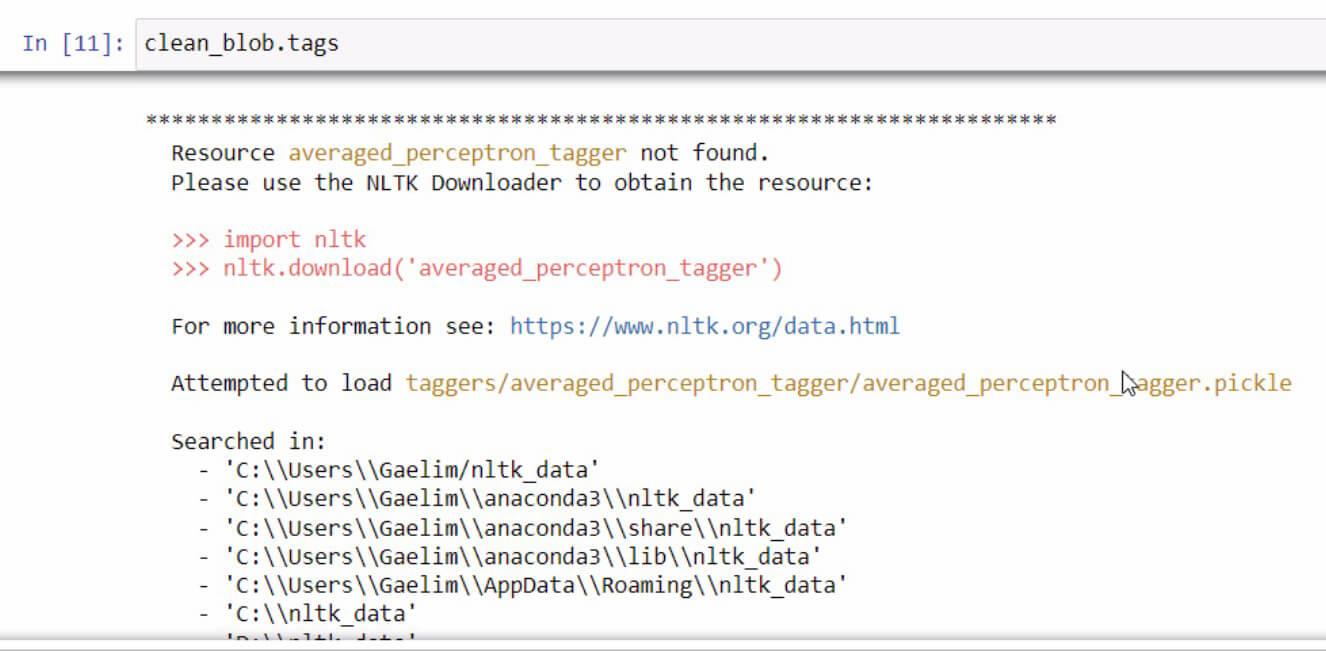

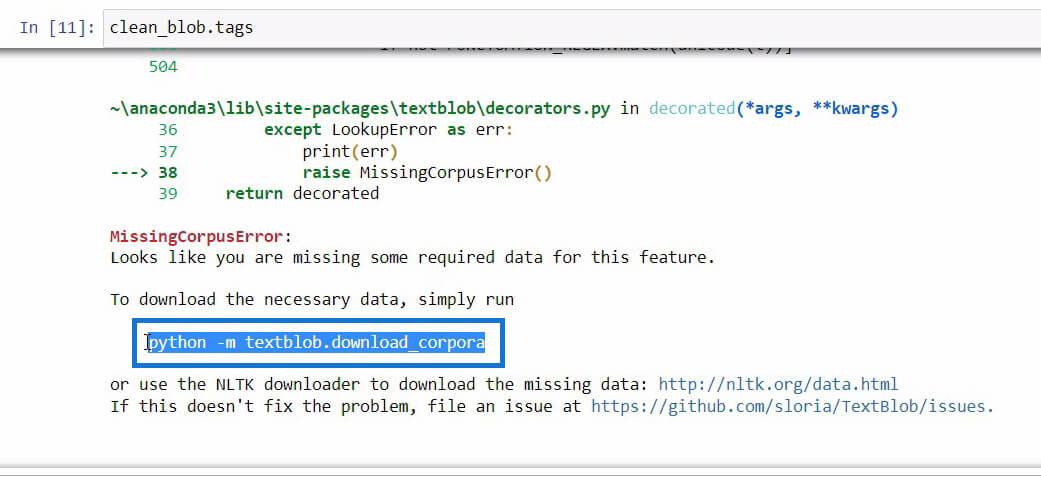

Se alguma vez você receber uma mensagem de erro ao inicializar a função .tags , basta ler e seguir os passos para corrigir o erro. Neste caso, é assim que parece.

Se você rolar para baixo no final desta mensagem de erro, verá os dados necessários para o recurso que está tentando usar.

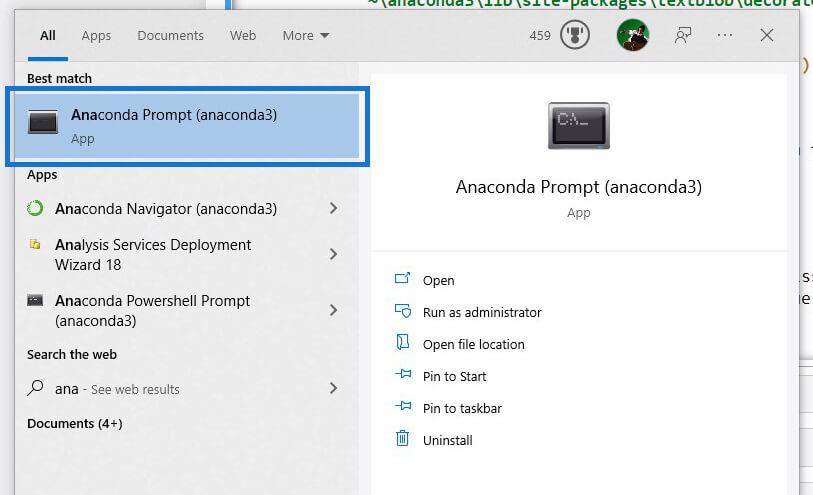

Depois de encontrar o código que precisamos inicializar para baixar os dados necessários, basta copiar o código e abrir o Prompt do Anaconda usando a Pesquisa do Windows .

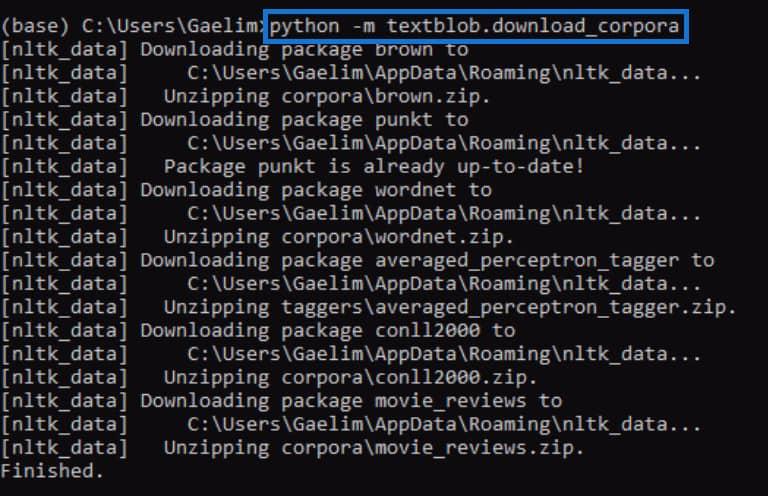

Usando Anaconda Prompt , tentaremos corrigir o erro que recebemos ao inicializar a função .tags . Agora vamos colar o código que copiamos da mensagem de erro anterior e executá-lo pressionando Enter .

Quando terminar, tente executar a função .tags novamente e veja se funciona.

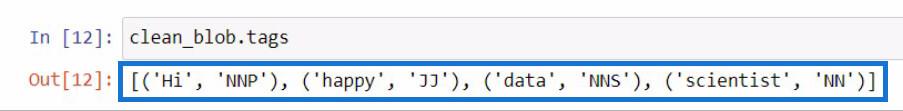

Ao executar o código novamente, podemos ver que o erro foi corrigido e recebemos um resultado que contém cada palavra do novo textblob junto com as tags ou classes gramaticais.

Se você não tem ideia do que essas tags significam, basta acessar o site do textblob para verificar o que essas tags representam.

Utilizando a função ngrams para análise de texto em Python

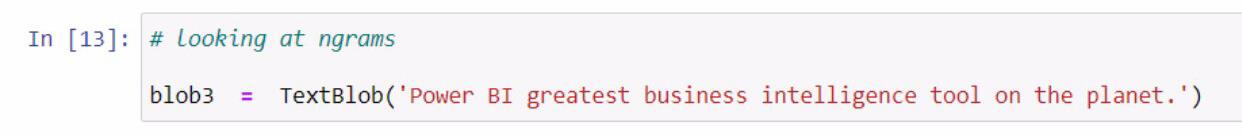

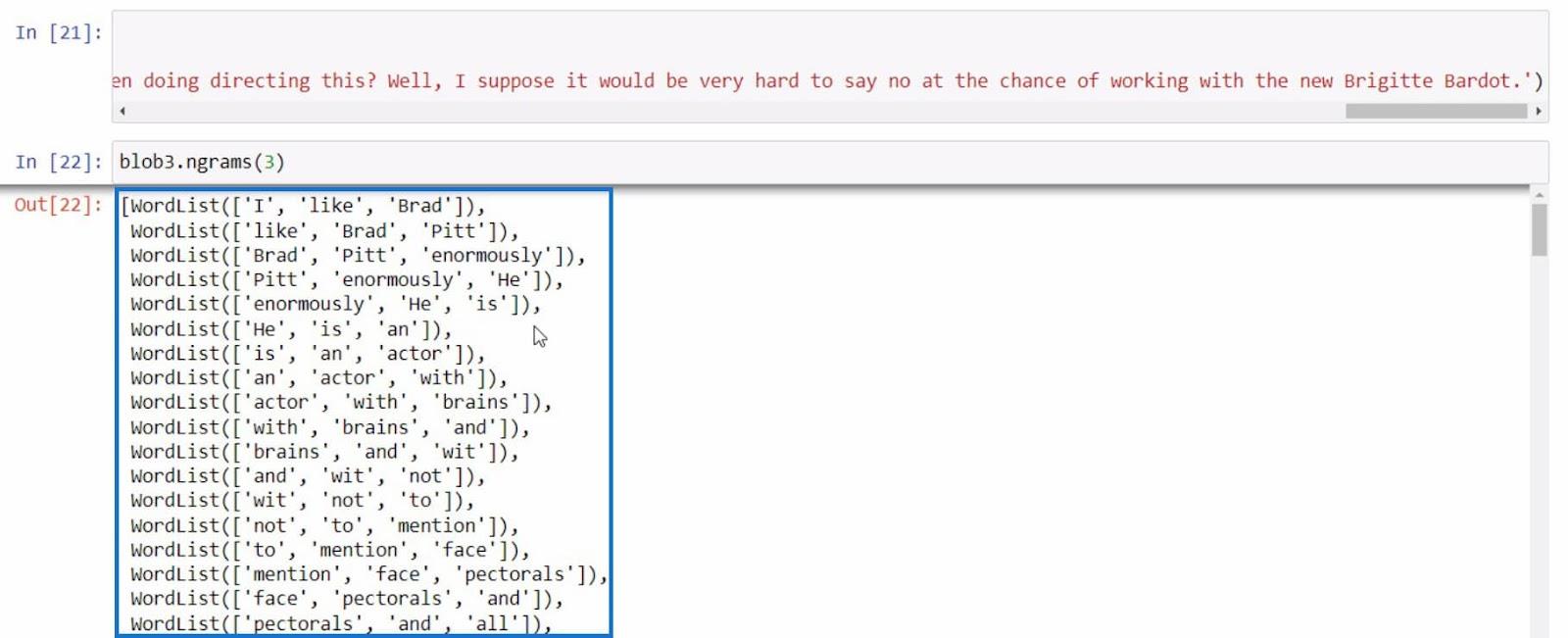

Vamos passar para outro exemplo, que trata de obter os ngrams . A função ngrams é usada para procurar palavras que são frequentemente vistas juntas em uma frase ou documento. Como exemplo, vamos começar criando um novo textblob e armazená-lo na variável blob3 .

Depois disso, vamos utilizar a função ngrams na variável blob3 para verificar algumas combinações de palavras.

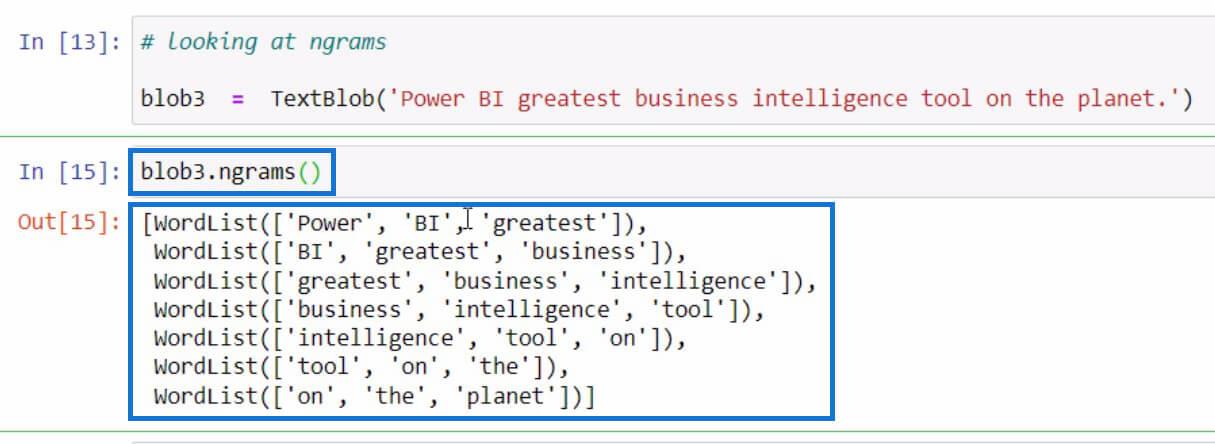

Por padrão, se você não especificou um valor nos parâmetros, ele exibirá trigramas ou combinações de 3 palavras. Mas se quisermos ver combinações de 2 palavras da frase, podemos definir 2 nos parâmetros como no exemplo abaixo.

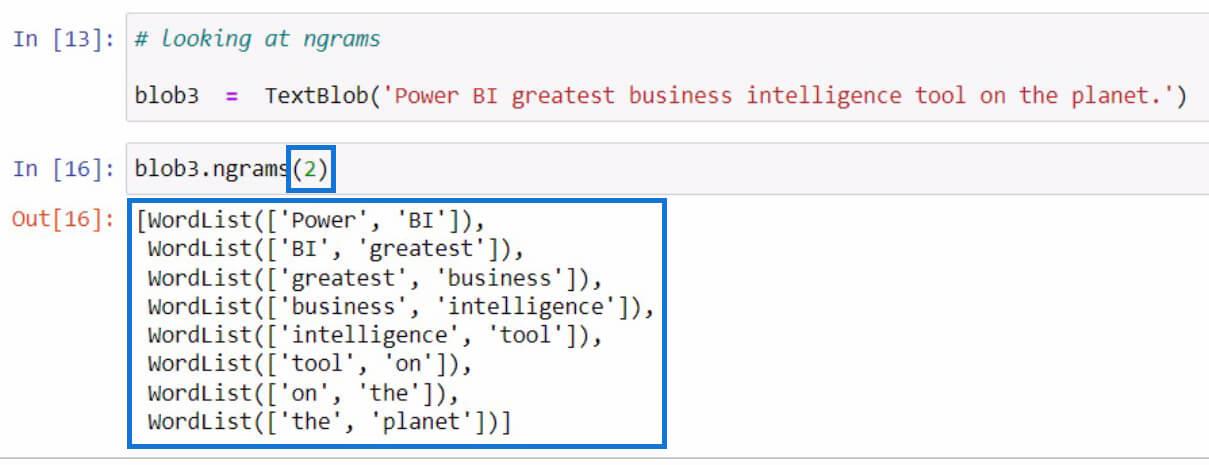

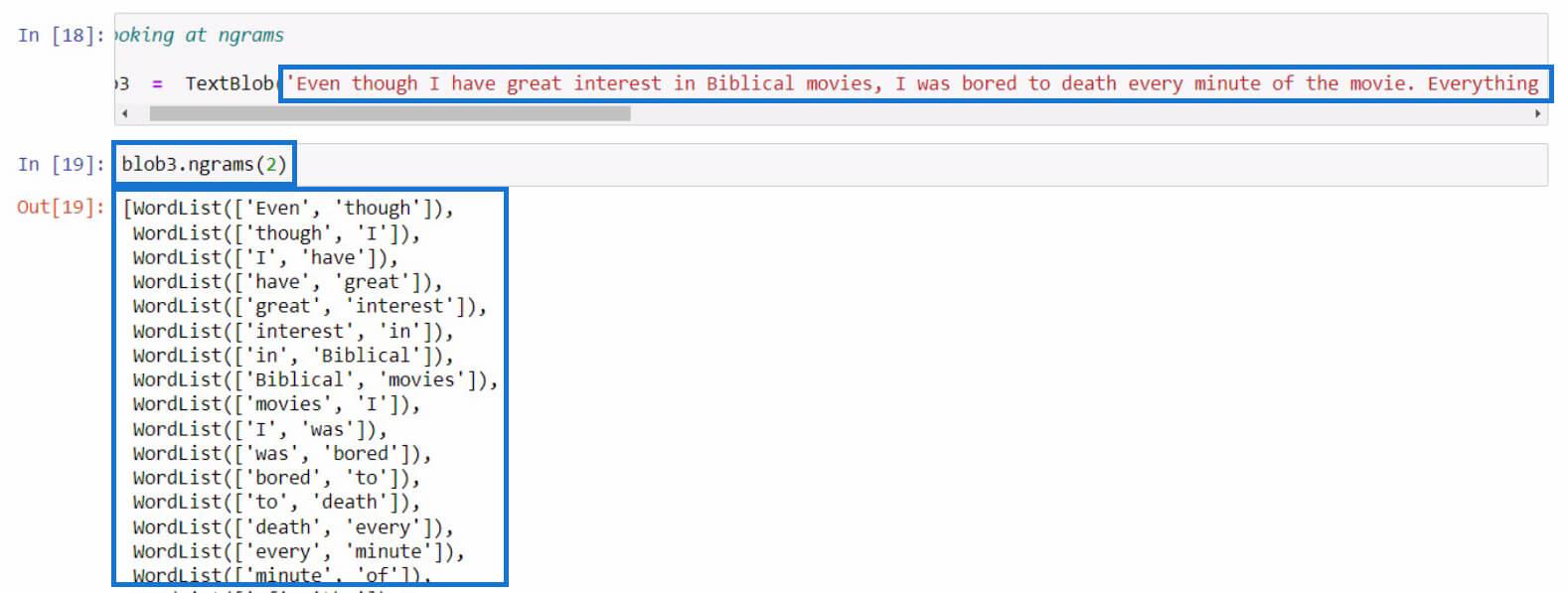

Vamos tentar com uma frase mais longa desta vez. Neste exemplo, apenas copiei um texto mais longo de uma resenha de filme. Você pode usar qualquer frase que desejar para esta parte.

Como exemplo final, vamos tentar usar ngrams mais uma vez com uma frase mais informativa.

Com todos esses exemplos, podemos realizar mais análises de texto em Python com base nos resultados que estamos obtendo com a função ngrams .

Python II para usuários do LuckyTemplates – Novo curso na plataforma sob demanda

Como carregar conjuntos de dados de amostra em Python

usando Python no LuckyTemplates | Conjunto de dados e função de string

Conclusão

Resumindo, você aprendeu sobre as diferentes funções que pode utilizar para executar a análise de texto em Python.

Estas são a função .tokenize para separar palavras em uma frase, a função .join para combinar palavras tokenizadas, a função .tags para verificar as partes do discurso das palavras e a função ngrams para visualizar a combinação de palavras.

Além disso, você aprendeu como corrigir erros como o que fizemos na função .tags usando o Anaconda Prompt . Você também aprendeu como importar, criar um textblob e utilizar esta biblioteca para realizar análises de texto em Python .

Tudo de bom,

gaellim

Descubra a importância das colunas calculadas no SharePoint e como elas podem realizar cálculos automáticos e obtenção de dados em suas listas.

Descubra todos os atributos pré-atentivos e saiba como isso pode impactar significativamente seu relatório do LuckyTemplates

Aprenda a contar o número total de dias em que você não tinha estoque por meio dessa técnica eficaz de gerenciamento de inventário do LuckyTemplates.

Saiba mais sobre as exibições de gerenciamento dinâmico (DMV) no DAX Studio e como usá-las para carregar conjuntos de dados diretamente no LuckyTemplates.

Este tutorial irá discutir sobre Variáveis e Expressões dentro do Editor do Power Query, destacando a importância de variáveis M e sua sintaxe.

Aprenda a calcular a diferença em dias entre compras usando DAX no LuckyTemplates com este guia completo.

Calcular uma média no LuckyTemplates envolve técnicas DAX para obter dados precisos em relatórios de negócios.

O que é self em Python: exemplos do mundo real

Você aprenderá como salvar e carregar objetos de um arquivo .rds no R. Este blog também abordará como importar objetos do R para o LuckyTemplates.

Neste tutorial de linguagem de codificação DAX, aprenda como usar a função GENERATE e como alterar um título de medida dinamicamente.