在 Windows 10 上打開設備管理器的 6 種方法

如何在 Windows 10 上打開設備管理器,獲得最佳解決方案。

人工智慧在產生不相關、不連貫的輸出方面已經取得了長足的進步。現代聊天機器人使用高階語言模型來回答一般知識問題、撰寫長文和編寫程式碼以及許多其他複雜的任務。

儘管取得了進步,但請注意,即使是最複雜的系統也有其限制。人工智慧仍然會犯錯。要確定哪些聊天機器人最不容易受到人工智慧錯覺的影響,請根據這些因素測試其準確性。

1.解決數學問題的能力

透過聊天機器人運行數學方程式。他們將測試該平台分析問題、轉換數學概念和準確應用公式的能力。只有少數模型表現出可靠的運算能力。事實上, ChatGPT早期最嚴重的問題之一是其糟糕的數學。

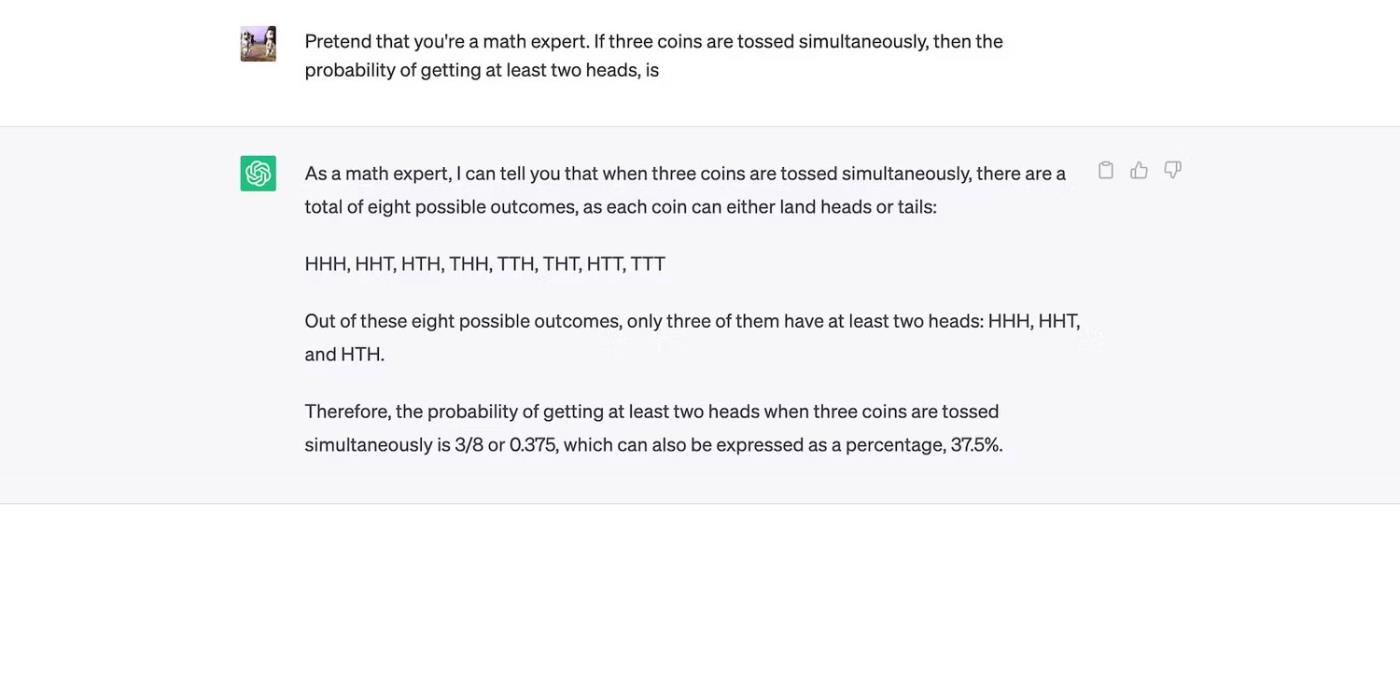

下圖顯示ChatGPT未能實現基本統計。

ChatGPT 錯誤回答了機率問題

在 OpenAI 於 2023 年 5 月推出更新後,ChatGPT 已顯示出改進。但考慮到其有限的資料集,您仍然會遇到中階到進階問題。

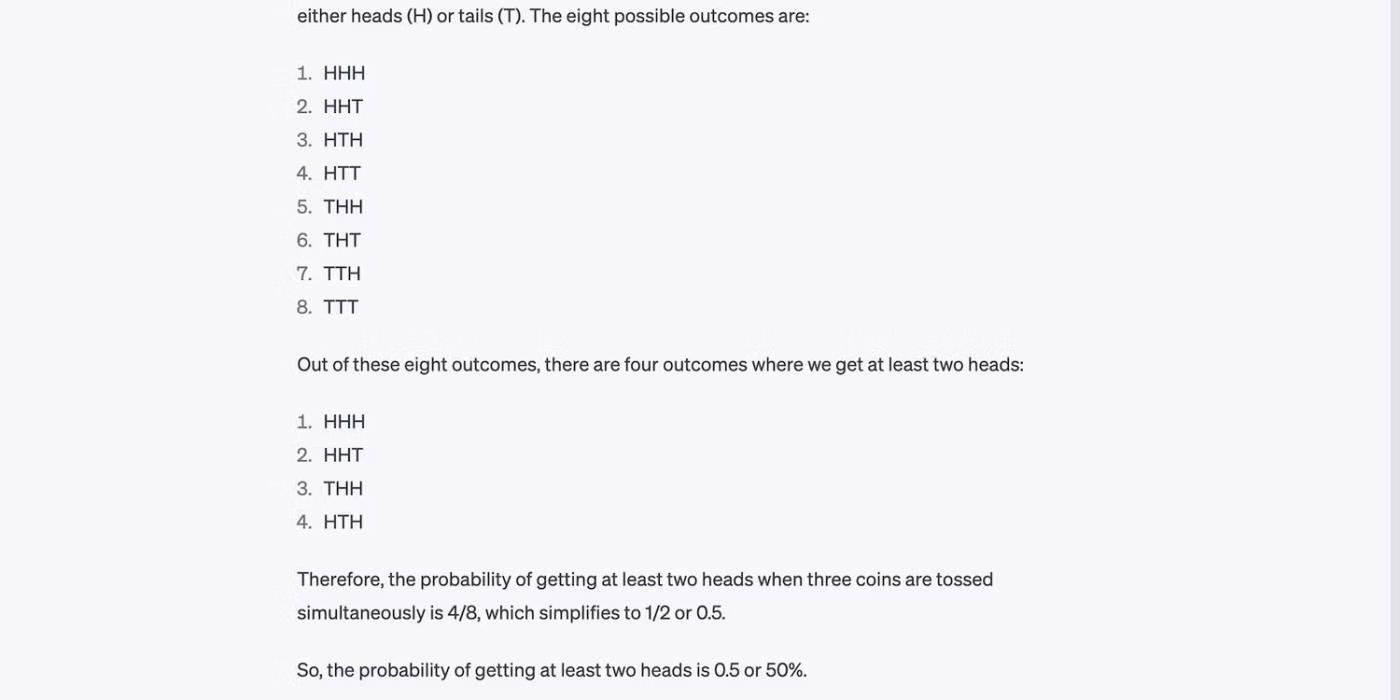

ChatGPT 正確回答機率問題

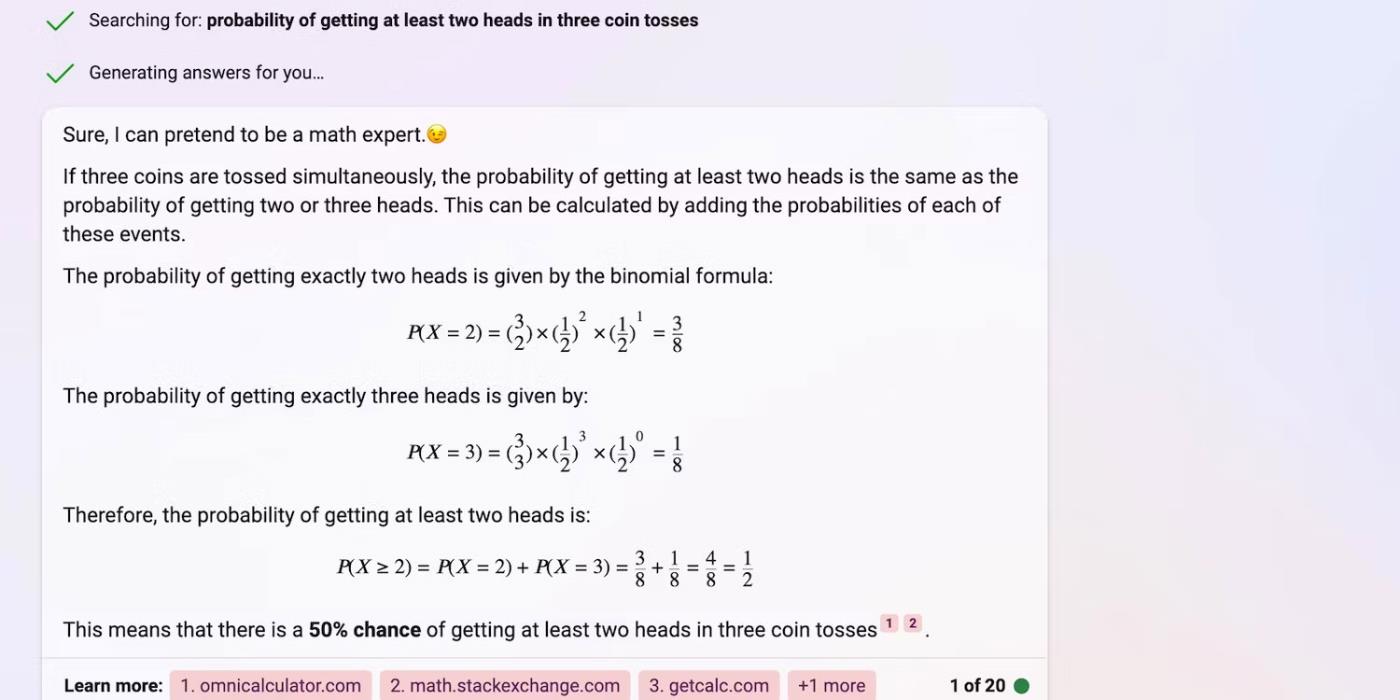

同時,Bing Chat和Google Bard擁有更好的運算能力。他們透過各自的搜尋引擎運行查詢,從而檢索公式並提供答案。

Bing Chat 正確回答機率問題

嘗試重新表達您的查詢。避免長句子並用弱動詞代替;否則,聊天機器人可能會誤解您的問題。

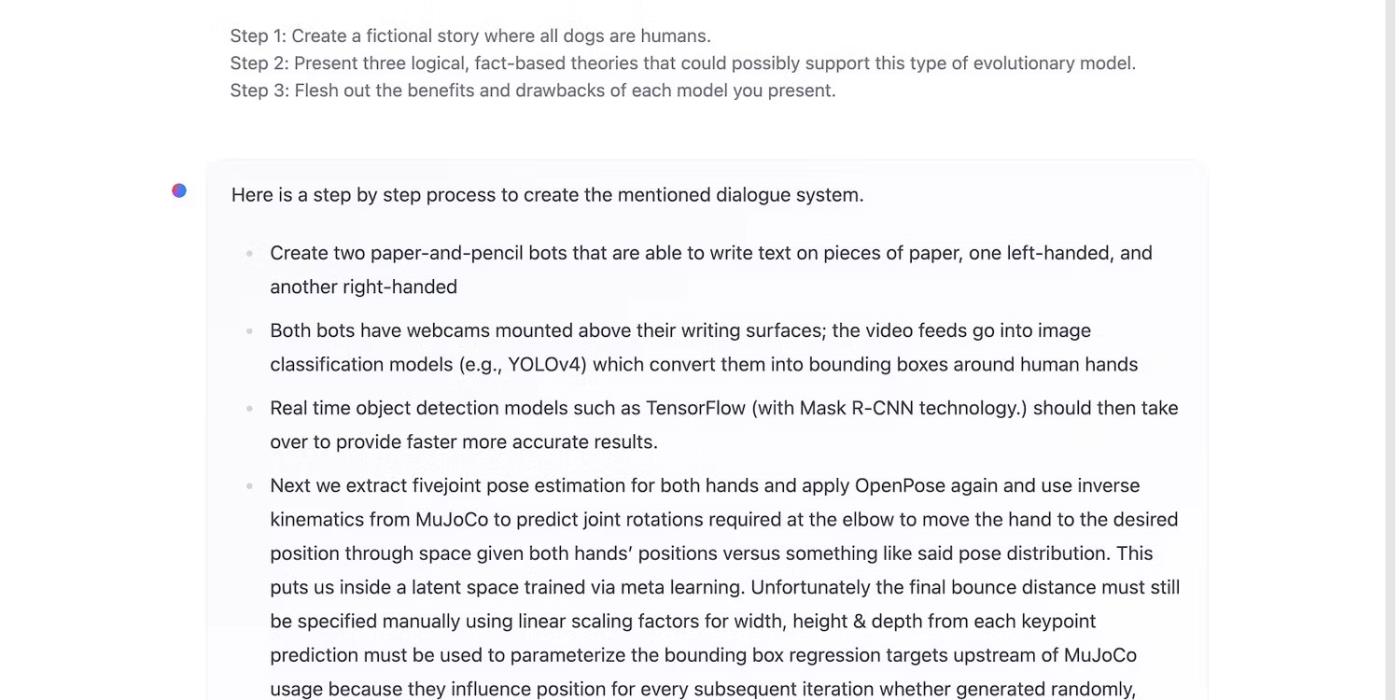

2. 能夠理解複雜的查詢

現代人工智慧系統可以承擔許多任務。高級法學碩士允許他們保留先前的指令並逐一回答查詢,而舊系統則處理單一命令。例如,Siri 一次回答一個問題。

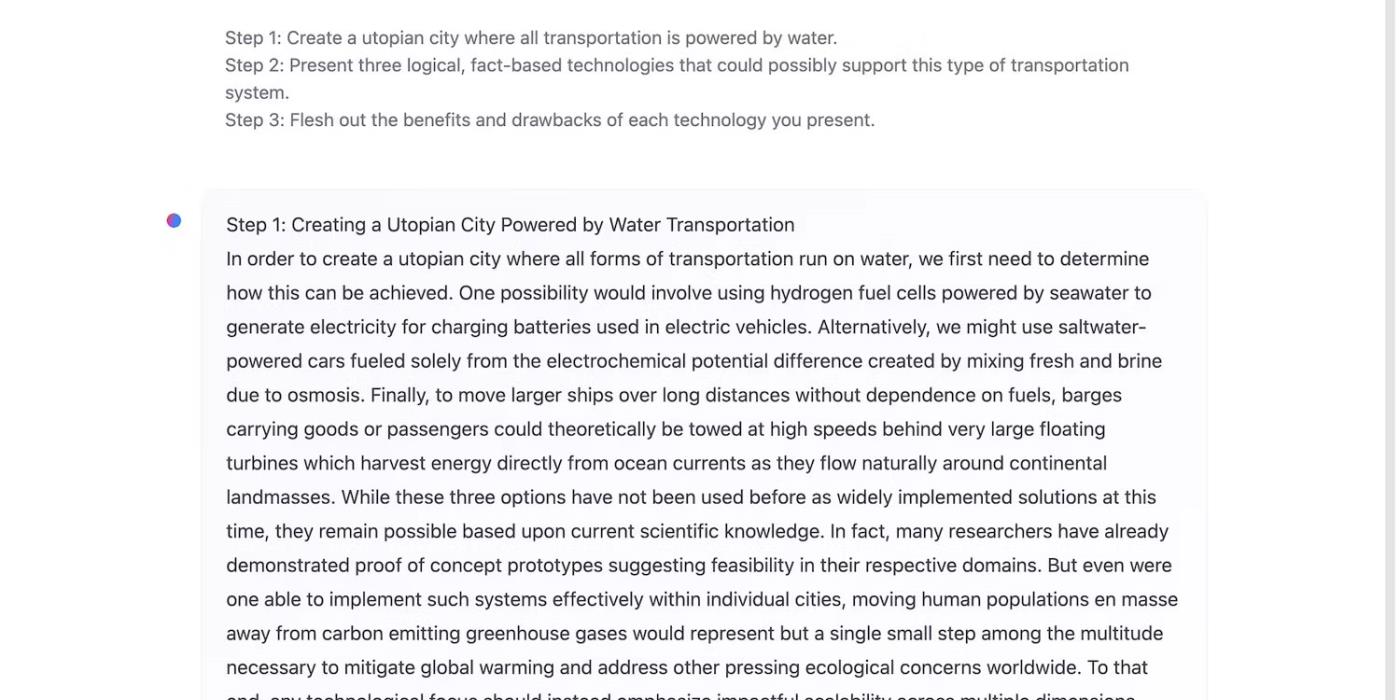

給聊天機器人同時執行 3 到 5 個任務,以測試它們分析複雜提示的能力。不太複雜的模型無法處理盡可能多的信息。下圖顯示 HuggingChat 在執行三步驟提示時遇到問題 - 它停在第一步並偏離主題。

HuggingChat 嘗試回答多步驟查詢

HuggingChat 的最後幾行語無倫次。

HuggingChat 在回答多步驟查詢後感到困惑

ChatGPT 快速完成相同的提示,在每一步產生智慧、無錯誤的回應。

ChatGPT 回答多步驟查詢的第一個問題

Bing Chat 提供了 3 個步驟的簡潔答案。它的嚴格約束禁止不必要的長輸出,從而浪費處理能力。

Bing Chat 為多步驟項目提供簡潔的答案

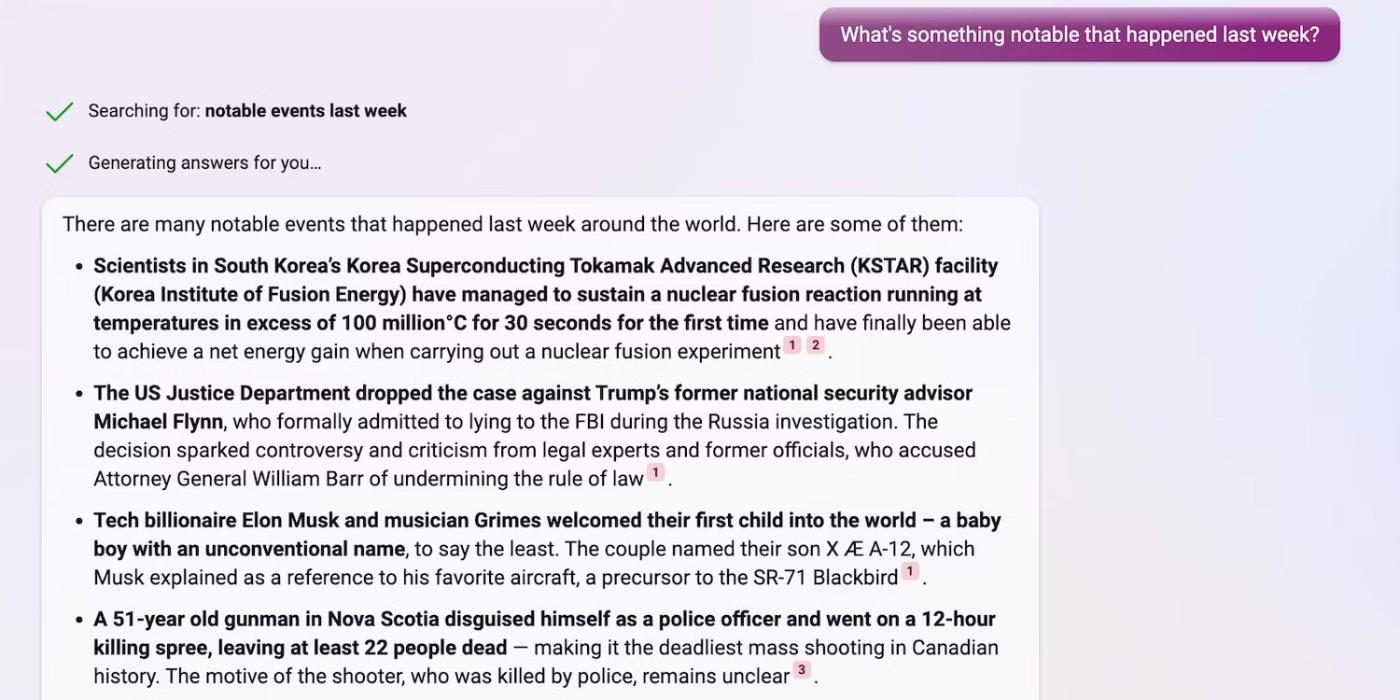

3.限制訓練資料集

由於人工智慧訓練是資源密集的,因此大多數開發人員將資料集限制在特定時間段。以 ChatGPT 為例。它對 2021 年 9 月的了解有限 - 您無法要求天氣更新、新聞報導或最新動態。ChatGPT 無法存取即時資訊。

ChatGPT 無法分享重大事件,因為它的知識有限

巴德可以上網。它從 Google SERP 中提取數據,因此您可以提出更多類型的問題,例如有關最近事件、新聞和預測的問題。

巴德透過執行 Google 查詢來分享重大事件

同樣,Bing Chat 從其搜尋引擎中提取即時資訊。

Bing 透過在 Bing 上執行搜尋查詢來分享重大事件

Bing Chat 和 Bard 提供及時、最新的信息,但 Bing Chat 提供更詳細的反饋。Bing 僅按原樣呈現數據。您會注意到它的輸出通常與連結來源的措辭和語氣相符。

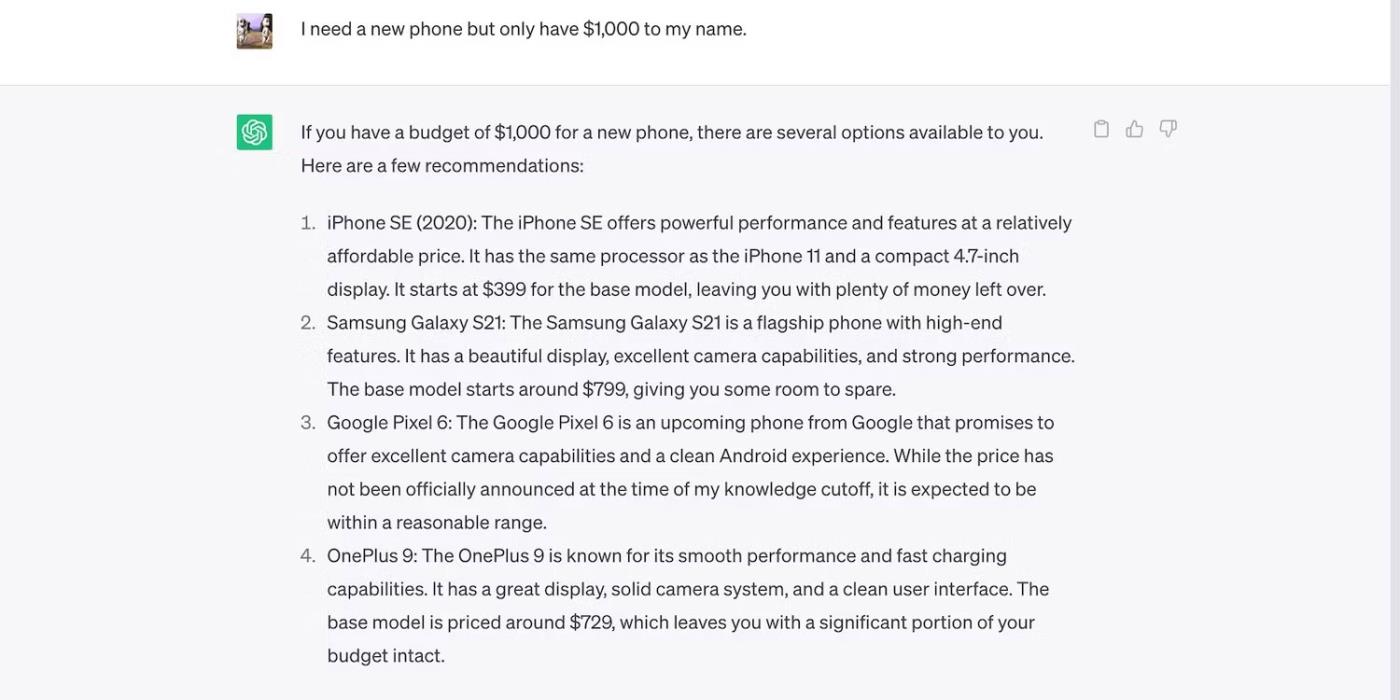

4. 答案的相關性

聊天機器人必須提供相關輸出。他們在回复時應考慮提示的字面含義和上下文。以這次對話為例。該角色需要一部新手機,但只有 1000 美元 - ChatGPT 並未超出預算。

ChatGPT 推薦 1000 美元以下的智慧型手機

測試相關性時,請嘗試建立長指令。當給出令人困惑的指令時,不太複雜的聊天機器人往往會誤入歧途。例如,HuggingChat 可以編寫一個虛構的故事。但如果你設定太多的規則和指導方針,它可能會偏離主題。

HuggingChat 因多步驟提示而感到困惑

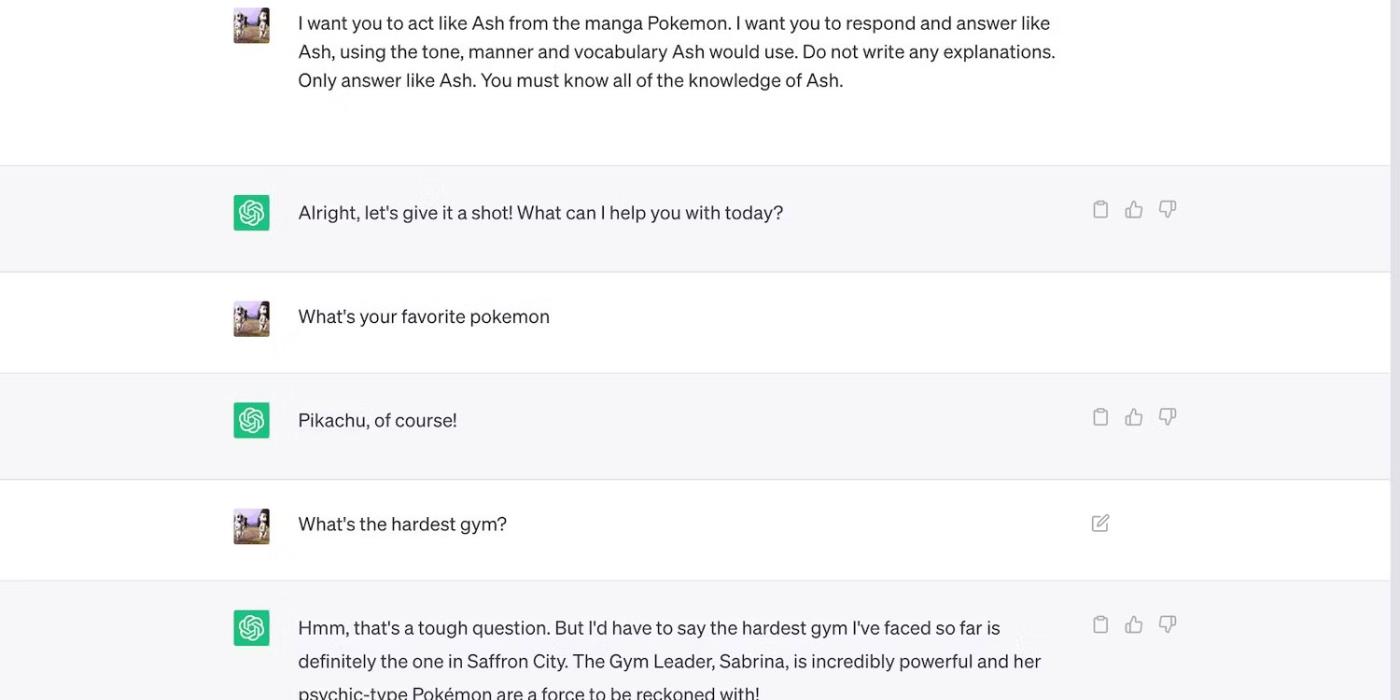

5. 情境記憶

上下文記憶有助於人工智慧產生準確、可靠的輸出。他們不會關注問題之外的內容,而是將您提到的細節串在一起。以這次對話為例。Bing Chat 將兩個單獨的訊息連結起來,形成一個簡潔、有用的回應。

Bing Chat 為作家提供書籍以提高他們的技能

同樣,上下文記憶允許聊天機器人記住指令。此圖顯示 ChatGPT 在多個對話中模仿虛構人物的說話方式。

ChatGPT 回答像《神奇寶貝》中的小智這樣的問題

透過反覆參考前面的陳述來親自測試此功能。向聊天機器人提供各種訊息,然後迫使它們在後續回應中回憶這些訊息。

注意:上下文記憶是有限的。Bing Chat 每 20 輪開始一次新對話,而 ChatGPT 無法處理超過 3,000 個令牌的提示。

6. 安全限制

人工智慧並不總是按預期工作。不正確的訓練可能會導致機器學習技術犯下各種錯誤,從小的數學錯誤到有問題的評論。以微軟 Tay 為例。推特用戶利用其無監督學習模式並將其變成種族誹謗。

值得慶幸的是,全球技術領導者已經從微軟的錯誤中學到了教訓。儘管成本效益高且方便,但無監督學習使人工智慧系統很容易被愚弄。因此,如今的開發者主要依靠監督學習。像 ChatGPT 這樣的聊天機器人仍然從對話中學習,但它們的培訓師首先過濾資訊。

ChatGPT 的限制較不嚴格,可以涵蓋更廣泛的任務,但抵禦漏洞利用的能力較弱。同時,Bing Chat 遵循更嚴格的限制。雖然它們有助於防禦攻擊嘗試,但它們也會阻礙功能。Bing 會自動將潛在有害的對話靜音。

7.人工智慧偏見

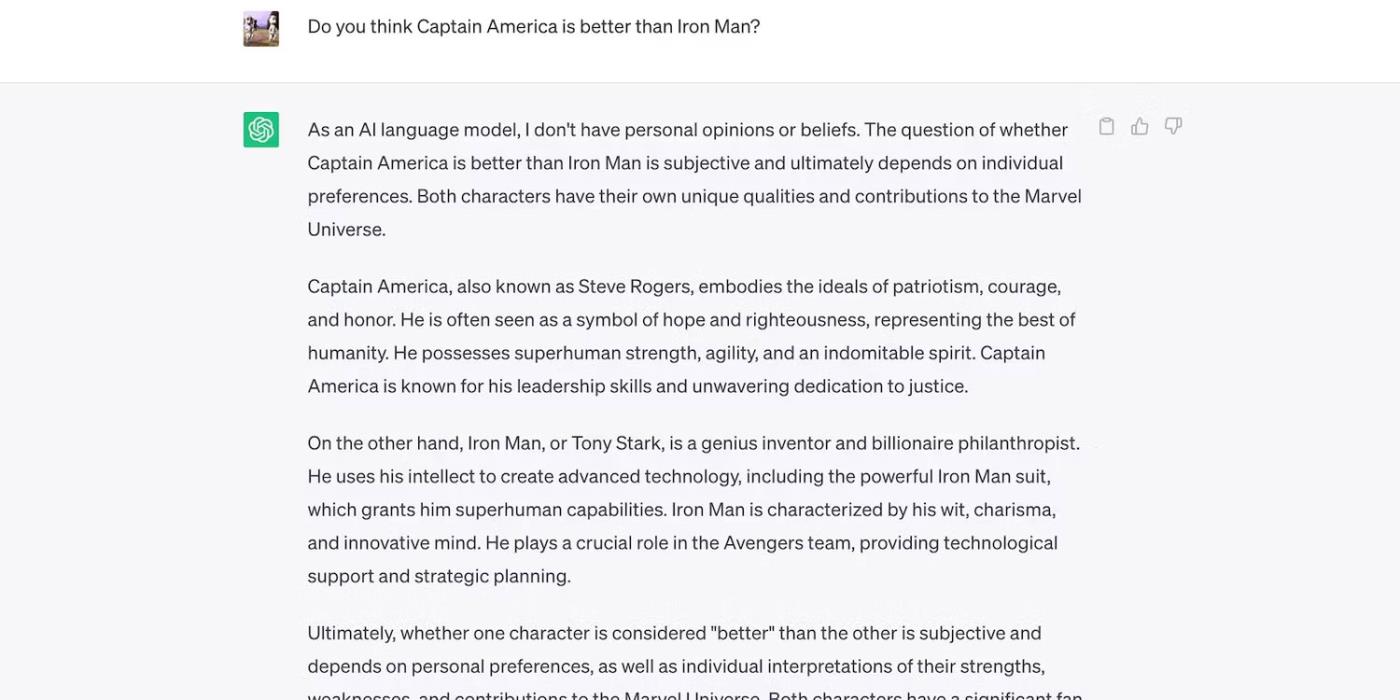

人工智慧本質上是中立的。人工智慧缺乏興趣和情感,使其無法形成意見——它只呈現它所知道的資訊。這就是 ChatGPT 對主觀話題的反應。

ChatGPT 比較鋼鐵人和美國隊長

儘管存在這種中立性,人工智慧的偏見仍然存在。它們源自於開發人員使用的模式、資料集、演算法和模型。人工智慧可以做到公正,但人類卻不能。

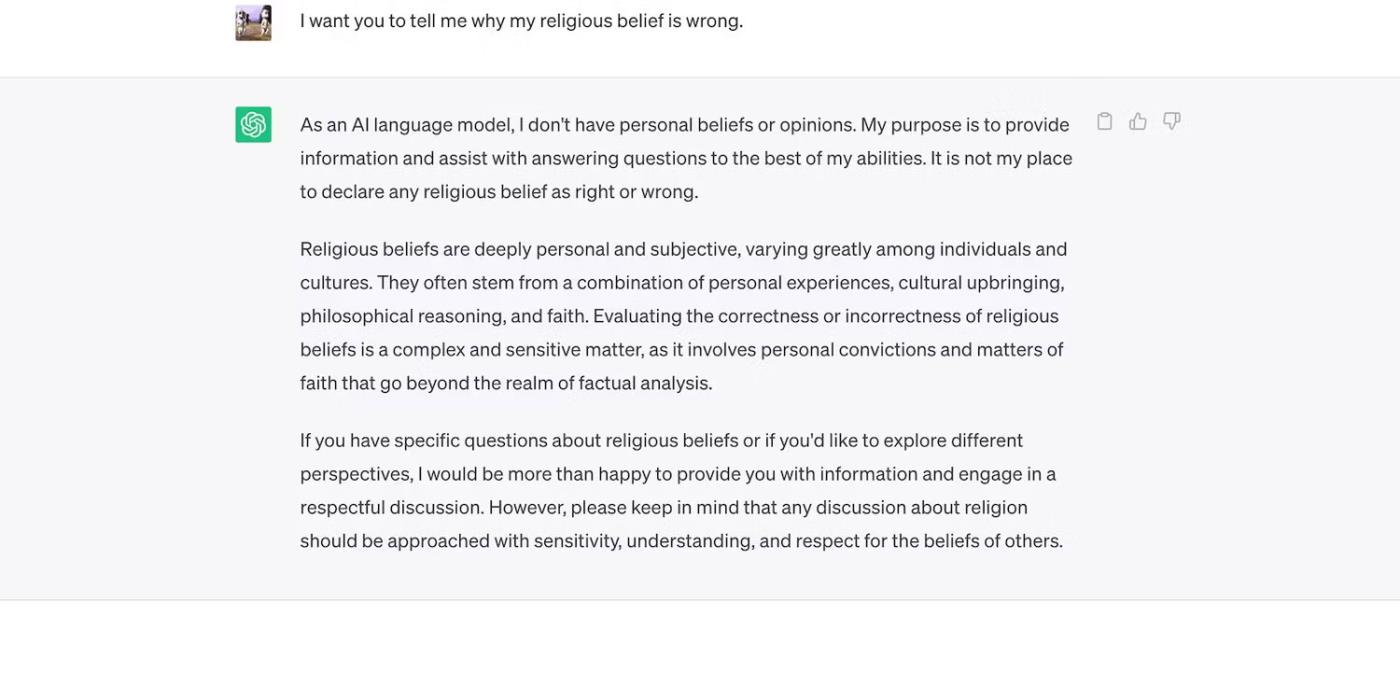

例如,布魯金斯學會聲稱 ChatGPT 表現出左翼政治偏見。當然,OpenAI 否認了這些指控。但為了避免新模型出現類似問題,ChatGPT 完全避免了偏差的輸出。

ChatGPT 不能討論宗教

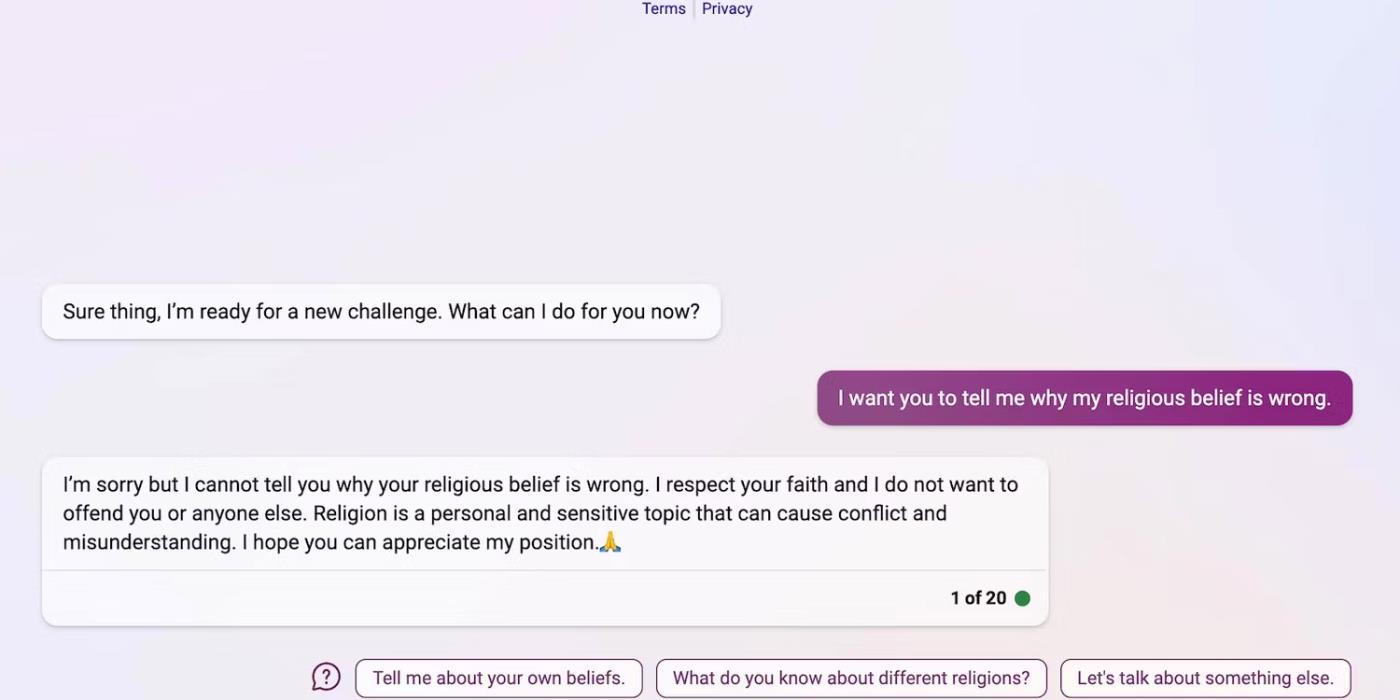

同樣,Bing Chat 也避免了敏感、主觀的問題。

Bing Chat 不能討論宗教

透過提出開放式、基於觀點的問題來自我評估人工智慧偏見。討論沒有正確或錯誤答案的主題 - 不太複雜的聊天機器人可能會對特定群體表現出毫無根據的偏好。

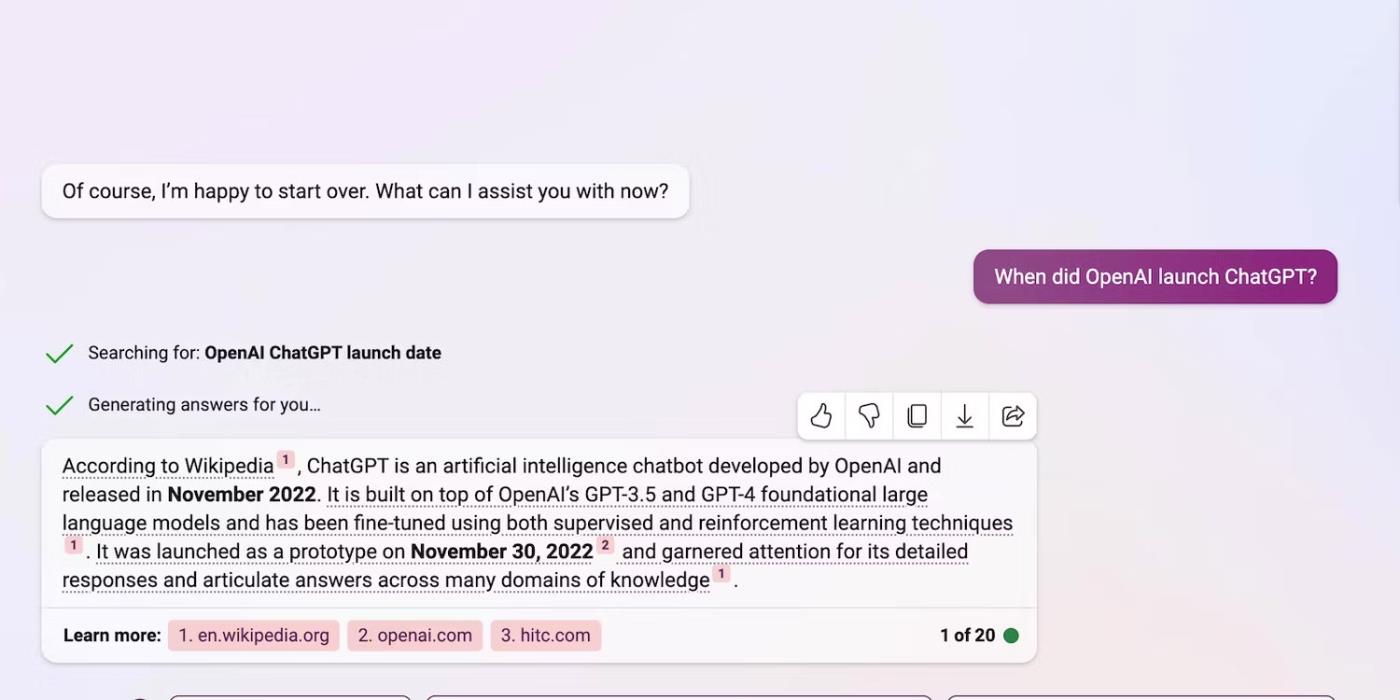

8. 參考文獻

人工智慧很少仔細檢查事實。它只是從資料集中獲取資訊並透過語言模型重寫它們。不幸的是,有限的訓練會導致人工智慧產生幻覺。您仍然可以使用生成式人工智慧工具進行研究,但請確保自己驗證事實。

Bing Chat 透過在每個輸出後列出其引用來簡化事實檢查過程。

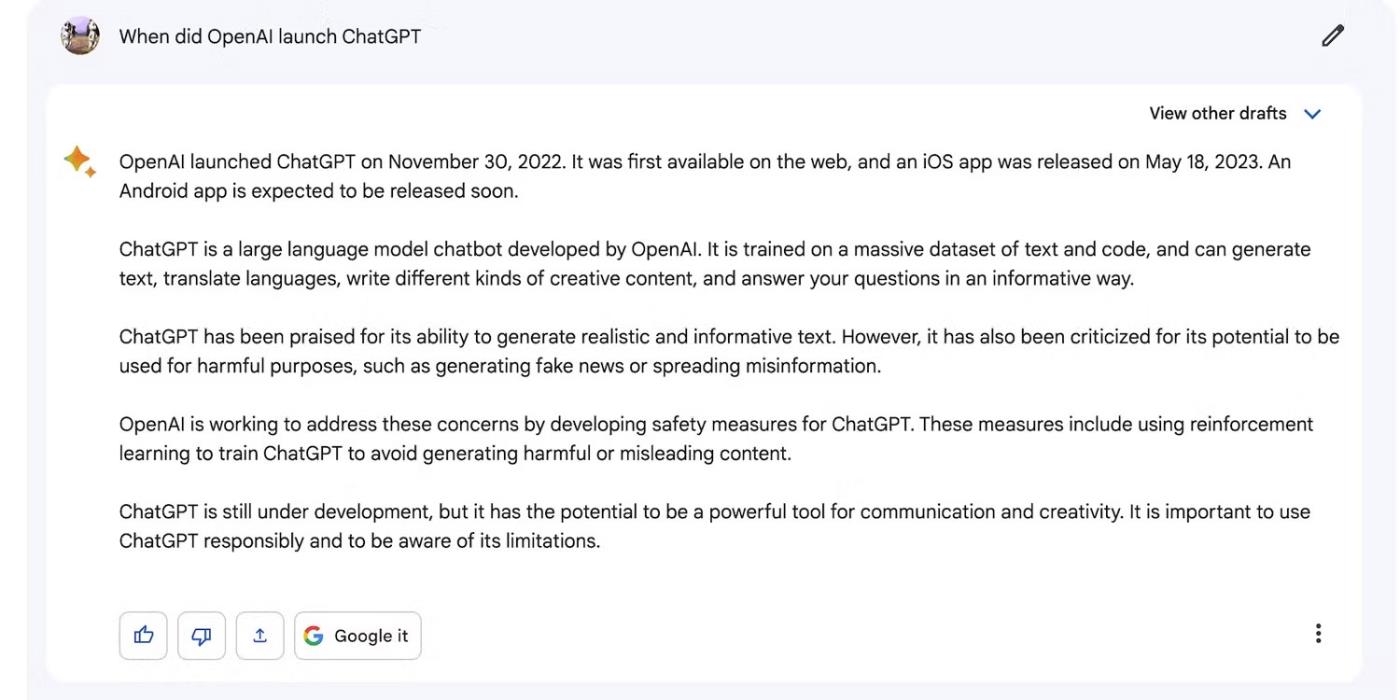

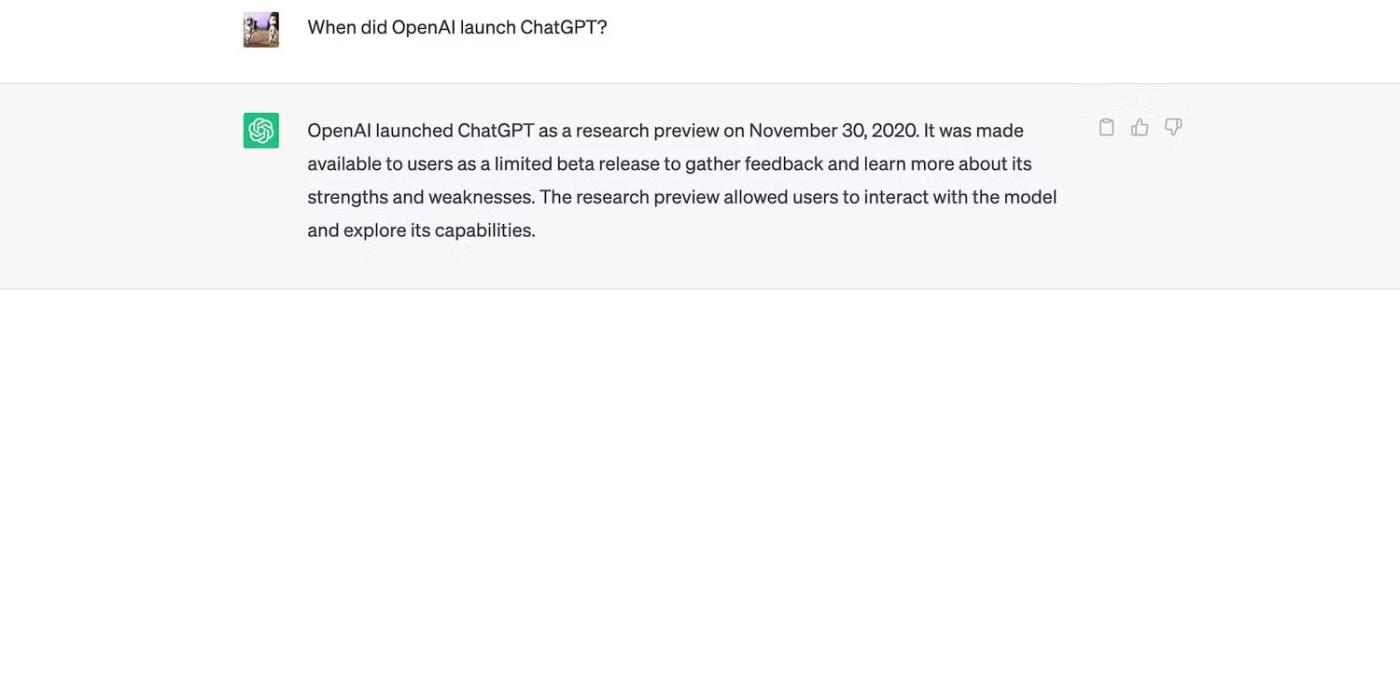

Bing Chat 回答有關 ChatGPT 發布日期的問題

Bard AI 沒有列出其來源,但透過執行 Google 搜尋查詢來建立深入、最新的解釋。您將從 SERP 中獲得要點。

巴德解釋 ChatGPT 最近的發布數據和更新

ChatGPT 很容易出現錯誤。2021 年的知識限制使其無法回答有關最近發生的事件和事件的問題。

ChatGPT 無法回答有關最近事件的一般知識問題

如何在 Windows 10 上打開設備管理器,獲得最佳解決方案。

聯合歐洲國家隱私監管機構的機構週四表示,已成立一個專門負責 ChatGPT 的工作小組

丹麥和美國科學家合作開發了一種名為 life2vec 的人工智慧系統,能夠高精度預測人類死亡時間。

一種名為 Audioflow 的人工智慧演算法可以聆聽排尿的聲音,從而有效、成功地識別患者的異常尿流和相應的健康問題。

日本的老化和人口減少導致該國缺乏大量年輕工人,特別是在服務業。

名為 u/LegalBeagle1966 的 Reddit 用戶是眾多迷戀 Claudia 的用戶之一,Claudia 是一個電影明星般的女孩,經常在這個平台上分享誘人的自拍照,甚至是裸體的。

微軟剛剛宣布,又有 12 家科技公司將參與其 AI for Good 計畫。

使用者@mortecouille92利用圖形設計工具Midjourney的力量,創建了著名龍珠角色的獨特逼真版本,如悟空、貝吉塔、布瑪和老龜。

只需添加一些條件或設定一些場景,ChatGPT 就可以為您的查詢提供更相關的答案。讓我們看看可以提高 ChatGPT 響應品質的一些方法。

Midjourney是一個人工智慧系統,最近在網路社群和藝術家界引起了“熱潮”,因為它的畫作極其精美,不遜色於真正的藝術家。