Microsoft Research a récemment fait sensation dans le monde de la recherche en intelligence artificielle (IA) en annonçant le développement réussi de DeepSpeed, une bibliothèque d'optimisation d'apprentissage en profondeur qui peut être utilisée pour former des modèles d'IA géants avec une échelle allant jusqu'à 100 milliards de paramètres.

Dans la formation en IA, plus les modèles de langage naturel dont vous disposez sont grands, plus la précision sera élevée. Cependant, la formation de grands modèles de langage naturel prend beaucoup de temps et les coûts impliqués ne sont pas minimes. DeepSpeed est né pour surmonter toutes les difficultés ci-dessus : améliorer la vitesse, le coût, l'échelle de formation et la convivialité.

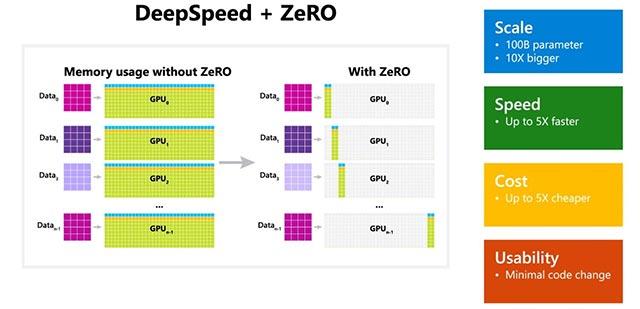

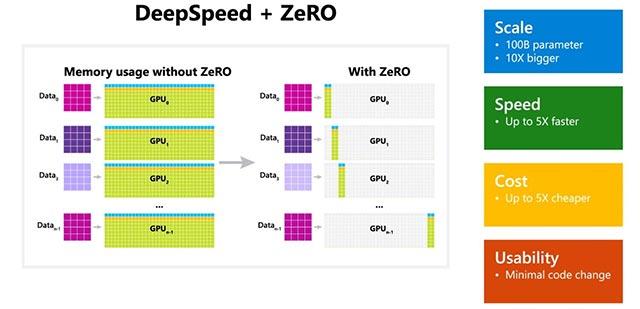

De plus, Microsoft a également mentionné que DeepSpeed inclut également ZeRO (Zero Redundancy Optimizer), une technique d'optimisation parallèle qui permet de minimiser la quantité de ressources nécessaires aux modèles, tout en contribuant à augmenter le nombre de paramètres pouvant être entraînés. En utilisant une combinaison de DeepSpeed et ZeRO, les chercheurs de Microsoft ont pu développer avec succès un nouveau modèle Turing Natural Language Generation (Turing-NLG) - le plus grand modèle de langage aujourd'hui avec 17 milliards de paramètres.

Quelques points forts de DeepSpeed :

- Échelle : les grands modèles d'IA avancés actuels tels que OpenAI GPT-2, NVIDIA Megatron-LM et Google T5 ont une échelle de 1,5 milliard, 8,3 milliards et 11 milliards de paramètres, respectivement. ZeRO stage 1 dans DeepSpeed peut fournir une prise en charge système pour exécuter des modèles comportant jusqu'à 100 milliards de paramètres, soit 10 fois plus grand que le plus grand modèle de Google.

- Vitesse : les augmentations de débit enregistrées varient en fonction de la configuration matérielle. Sur les clusters GPU NVIDIA avec des connexions à faible bande passante (sans NVIDIA NVLink ou Infiniband), DeepSpeed obtient une amélioration du débit de 3,75 fois par rapport à l'utilisation de Megatron-LM seul pour le modèle GPT-2 standard avec 1,5 milliard de paramètres. Sur les clusters NVIDIA DGX-2 dotés de connexions haut débit, pour les modèles comportant 20 à 80 milliards de paramètres, DeepSpeed est 3 à 5 fois plus rapide.

- Coût : Grâce à l'amélioration de la vitesse, les coûts de formation sont également considérablement optimisés. Par exemple, pour entraîner un modèle avec 20 milliards de paramètres, DeepSpeed exige 3 fois moins de ressources que d'habitude.

- Convivialité : seules quelques modifications mineures du code sont nécessaires pour que les modèles actuels puissent passer à l'utilisation de DeepSpeed et ZeRO. DeepSpeed ne nécessite pas de refonte du code ni de refactorisation du modèle.

Microsoft open source DeepSpeed et ZeRO sur GitHub , veuillez vous y référer.