Microsoft Research recientemente causó revuelo en el mundo de la investigación de inteligencia artificial (IA) cuando anunció el desarrollo exitoso de DeepSpeed, una biblioteca de optimización de aprendizaje profundo que se puede utilizar para entrenar modelos de IA gigantes con una escala de hasta 100 mil millones de parámetros.

En el entrenamiento de IA, cuanto más grandes sean los modelos de lenguaje natural que tenga, mayor será la precisión. Sin embargo, entrenar grandes modelos de lenguaje natural consume mucho tiempo y los costos involucrados no son pequeños. DeepSpeed nació para superar todas las dificultades anteriores: mejorar la velocidad, el costo, la escala de entrenamiento y la usabilidad.

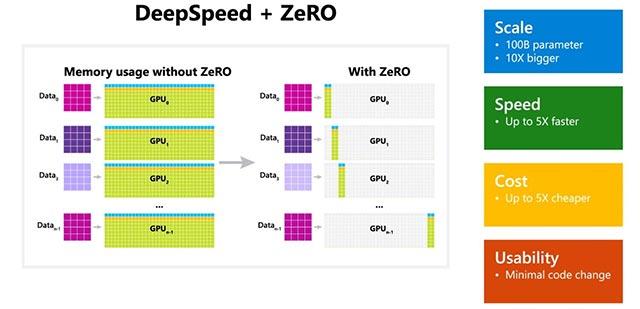

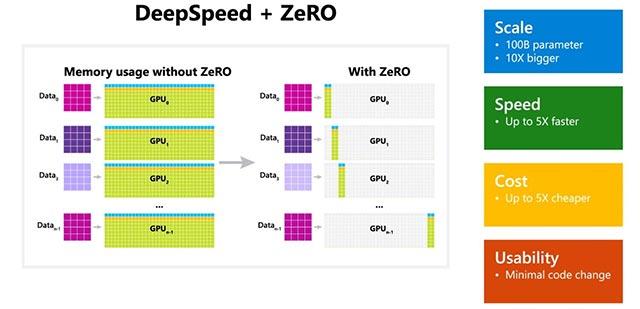

Además, Microsoft también mencionó que DeepSpeed también incluye ZeRO (Zero Redundancy Optimizer), una técnica de optimización paralela que ayuda a minimizar la cantidad de recursos necesarios para los modelos, al mismo tiempo que ayuda a aumentar la cantidad de parámetros que se pueden entrenar. Utilizando una combinación de DeepSpeed y ZeRO, los investigadores de Microsoft pudieron desarrollar con éxito un nuevo modelo de Generación de Lenguaje Natural de Turing (Turing-NLG), el modelo de lenguaje más grande en la actualidad con 17 mil millones de parámetros.

Algunos aspectos destacados de DeepSpeed:

- Escala: Los modelos actuales de IA grandes y avanzados, como OpenAI GPT-2, NVIDIA Megatron-LM y Google T5, tienen una escala de 1.500 millones, 8.300 millones y 11.000 millones de parámetros, respectivamente. La etapa 1 de ZeRO en DeepSpeed puede proporcionar soporte del sistema para ejecutar modelos con hasta 100 mil millones de parámetros, que es 10 veces mayor que el modelo más grande de Google.

- Velocidad: los aumentos de rendimiento registrados variarán según la configuración del hardware. En clústeres de GPU NVIDIA con conexiones de ancho de banda bajo (sin NVIDIA NVLink o Infiniband), DeepSpeed logra una mejora de rendimiento de 3,75 veces en comparación con el uso de Megatron-LM solo para el modelo GPT-2 estándar con 1,5 mil millones de parámetros. En clústeres NVIDIA DGX-2 con conexiones de gran ancho de banda, para modelos con entre 20 y 80 mil millones de parámetros, DeepSpeed es de 3 a 5 veces más rápido.

- Coste: gracias a las mejoras en la velocidad, los costes de formación también se optimizan significativamente. Por ejemplo, para entrenar un modelo con 20 mil millones de parámetros, DeepSpeed requiere 3 veces menos recursos de lo habitual.

- Usabilidad: Solo se necesitan unos pocos cambios menores en el código para que los modelos actuales puedan pasar a utilizar DeepSpeed y ZeRO. DeepSpeed no requiere rediseño de código ni refactorización de modelos.

Microsoft tiene código abierto para DeepSpeed y ZeRO en GitHub , consulte.