Power Automate の文字列関数: Substring と IndexOf

Microsoft フローで使用できる 2 つの複雑な Power Automate String 関数、substring 関数とindexOf 関数を簡単に学習します。

このブログでは、テキスト コンテンツから構築データを作成するための Python でのテキスト分析について説明します 。これは、大量のデータを分析するのに役立ち、特定のタスクにかかる時間を短縮できます。自然言語処理タスクを扱うテキストブロブに関する知識も習得します。

テキスト分析は、テキスト データの生成とグループ化の自動化プロセス用のコードを使用してテキストを分析するプロセスです。

続行する前に、このチュートリアルで使用するライブラリをインストールする必要がある場合があります。

目次

Python でのテキスト分析の実装

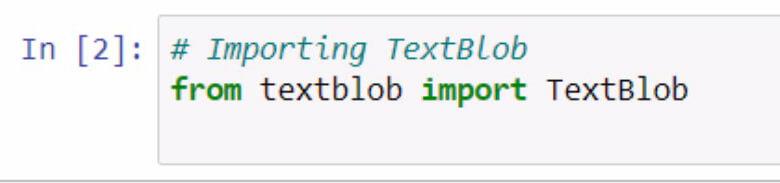

textblobをインポートすることから始めましょう。コメントを使用して何を行っているかを必ず文書化してください。

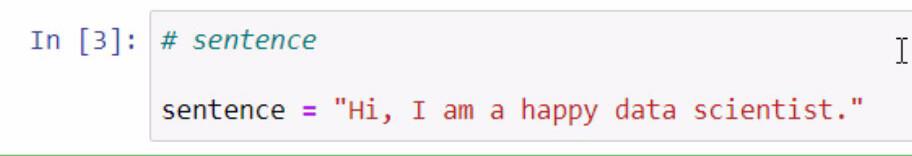

上記のコードを実行すると、textblobライブラリにアクセスできるようになります。次のステップでは、例に使用する文を作成します。これを行うには、文章をSentenceという名前の変数に保存します。

追加する文は必ず二重引用符で囲んでください。

textblobは、 Pythonでのテキスト分析に blob を作成し、その関数の一部を使用できる優れたライブラリです。

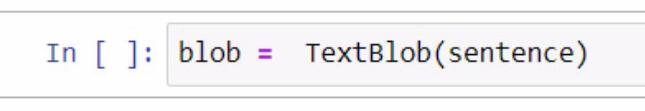

BLOB を作成するには、まず変数を作成し、blobという名前を付けます。この変数には、使用しているライブラリであるTextBlobを追加する必要があります。

括弧内では、前に作成した文を保持する文変数を利用します。この部分の括弧内に文章そのものを手動で入力することもできることに注意してください。

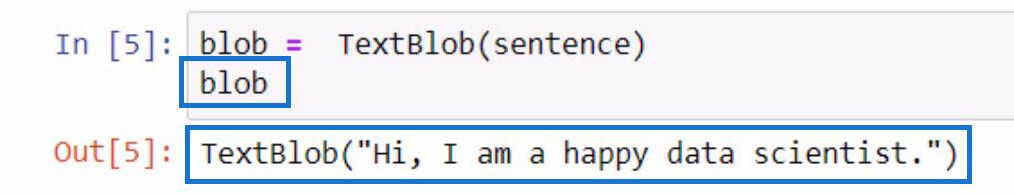

このBLOB変数の動作を確認するには、変数名を入力して Shift + Enter キーを押すだけで初期化できます。出力は次の例のようになります。

結果からわかるように、文章変数に格納した文はTextBlobに含まれるようになりました。

Python でのテキスト データのトークン化

文からいくつかの単語を削除したい場合は、これらの単語をリスト内の個別の部分に分割できます。この与えられた文で、これから行うことは、それらをトークン化するか、各単語を分離してリストに入れることです。

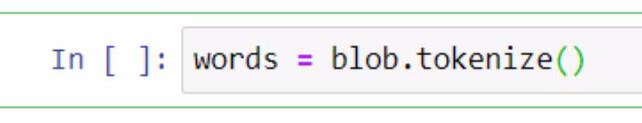

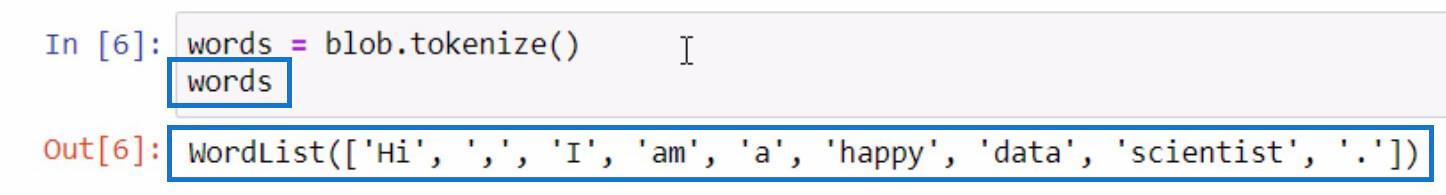

これを行うには、 blob変数を利用し、tokenize関数を使用します。次に、それをWordsという名前の変数に保存します。

BLOB変数を初期化したのと同じ方法でWord変数を初期化して、トークン化されたリストに何が含まれているかを確認しましょう。

ご覧のとおり、各単語、さらには句読点もリスト内で分離されています。これがトークン化機能の仕組みです。

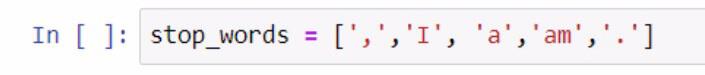

単語のリストができたので、そこから別の機能を実行できます。句読点や冠詞など、リストに含めたくない単語の別のリストを作成しましょう。この手順を実行するには、以下のスクリーンショットを参照してください。

ストップ ワードのリストを作成する際、括弧を使用してストップ ワードのリストを囲みました。次に、各ストップ ワードを一重引用符で囲み、それぞれをカンマで区切ります。リストをstop_words変数に保存しました。

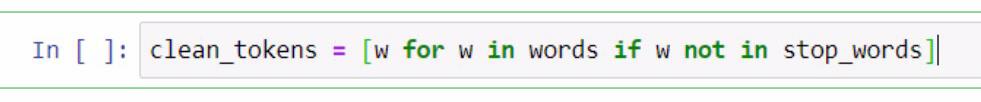

ここからは、リスト内包表記を実行して、Pythonでテキスト分析を行うために必要な単語を削除します。これには、文のクリーニング、トークン化、さまざまなリストの比較が含まれます。次に、これら 2 つのリストを比較し、clean_tokensの新しいリストを作成します。

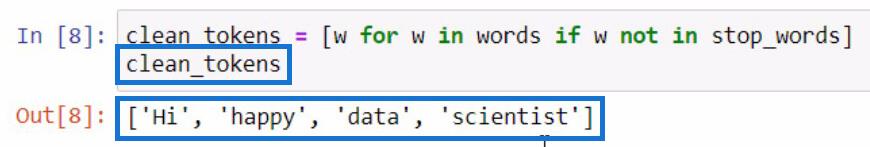

上記のコードでは、要素を表すためにwというプレースホルダーを利用しました。この部分でやろうとしていることは、要素が stop_words 変数に存在しない場合に、words 変数内の要素を取得することです。clean_tokens を初期化する場合、結果は次のようになります。

このプロセスでは、句読点や冠詞などの不要なトークンを削除するプロセスを入れることで、トークンをクリーンアップすることができます。そのため、リストにはエッセンスの単語だけが残っています。

Python でトークンを結合して文を形成する

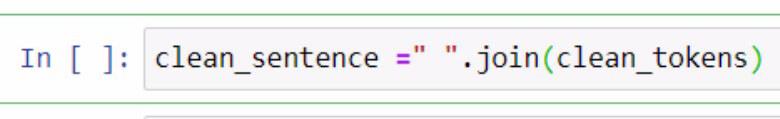

クリーントークンを分離したので、それらを 1 つの文にまとめてみましょう。そのためには、.join関数を利用する必要があります。以下の例を参考にしてください。

上の例では、文章に結合されるクリーン トークンを保持するclean_sentenceという名前の変数を作成しました。二重引用符で囲まれたスペースと.join関数が追加されていることにも注目してください。パラメーター内に、clean_tokens変数を含めました。

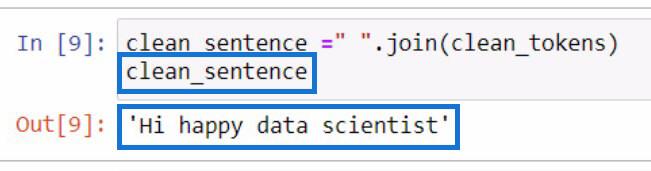

これは、 clean_sentence変数を初期化した場合の出力になります。

先ほど冠詞と句読点を削除したため、文が正しく見えなくなっていることがわかります。

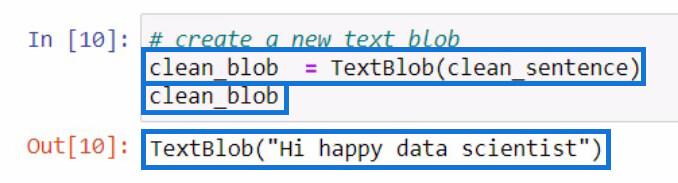

clean_sentenceを作成した後、作成したばかりのclean_sentenceを含む新しいtextblobを作成してみましょう。次に、それを新しい変数clean_blobに保存します。

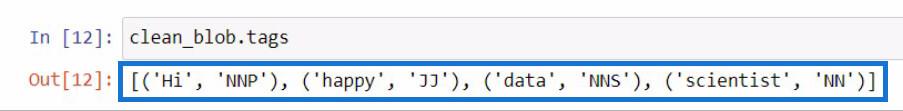

.tags 関数を使用して品詞の Textblob を分析する

この分析 BLOB から、この BLOB の一部を使用して品詞を確認したり、さらに変更を加えることができます。新しいtextblob内の各単語の品詞をチェックしてみましょう。

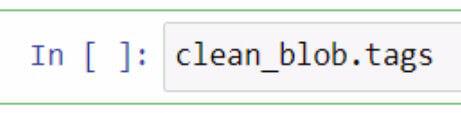

textblob 内の品詞を確認するには、.tags関数を使用する必要があります。clean_blob変数を利用してこれを実行し、その直後に.tags関数を追加しました。

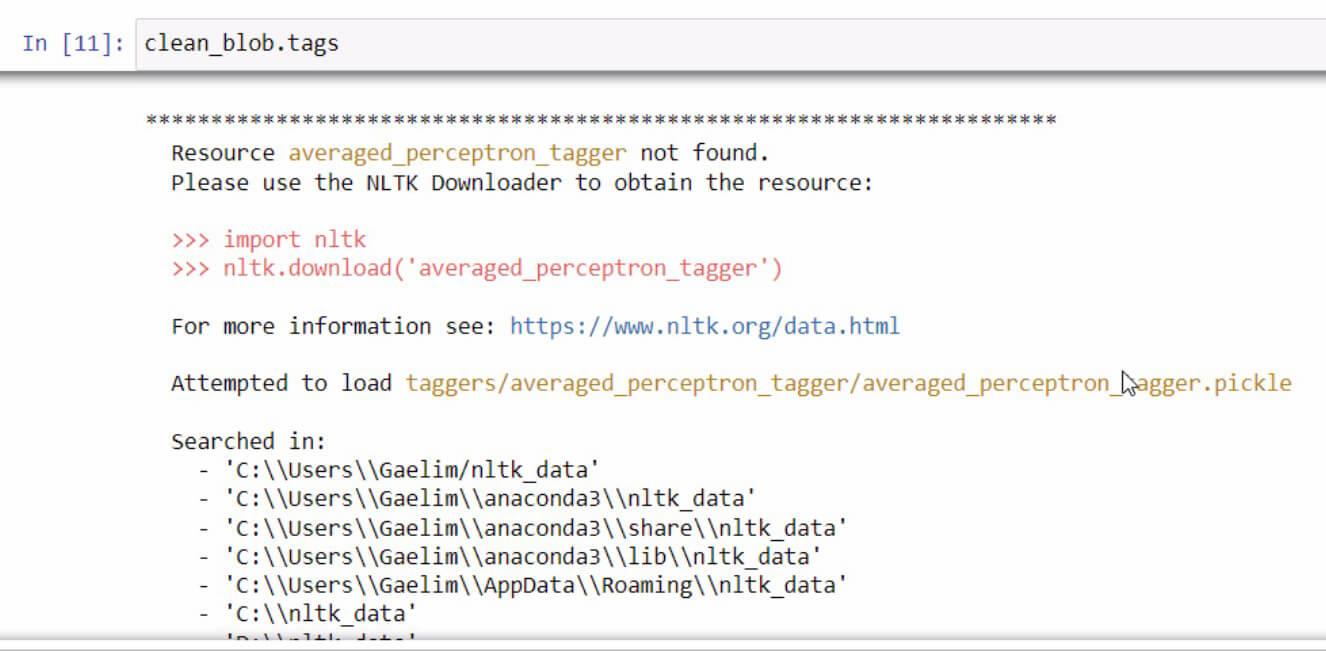

.tags関数の初期化時にエラー メッセージが表示された場合は、エラーを修正するための手順を読んで実行してください。この場合はこんな感じになります。

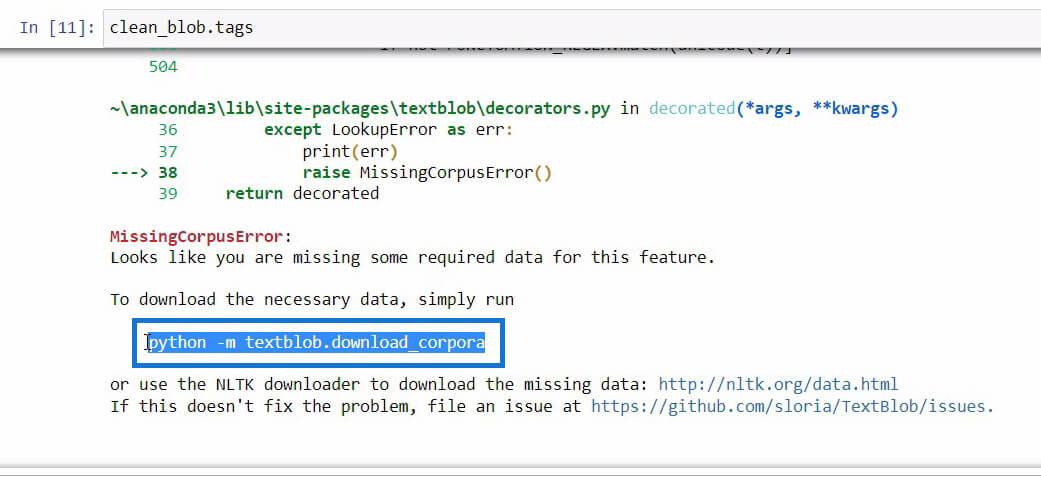

このエラー メッセージの最後を下にスクロールすると、使用しようとしている機能に必要なデータが表示されます。

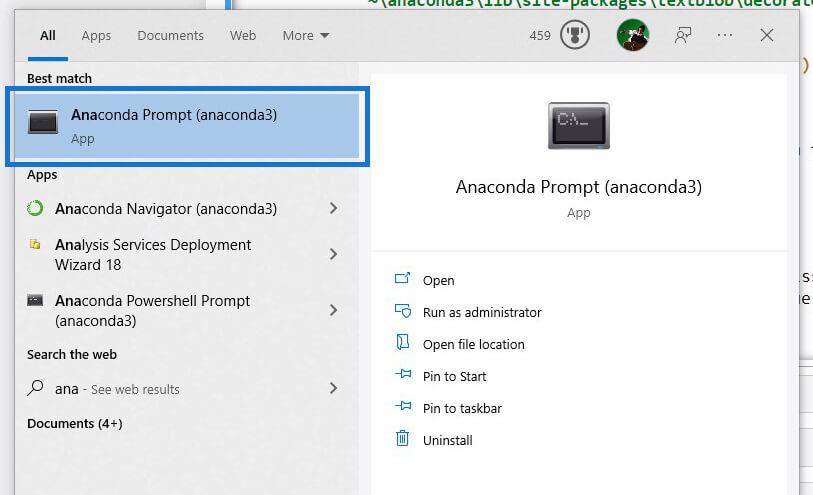

必要なデータをダウンロードするために初期化する必要があるコードが見つかったら、そのコードをコピーし、Windows Searchを使用してAnaconda プロンプトを開きます。

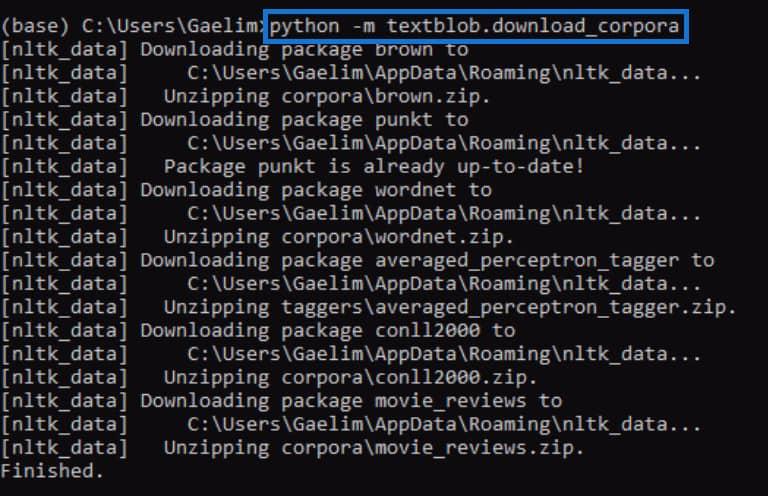

Anaconda Promptを使用して、 .tags関数の初期化時に受け取ったエラーを修正してみます。ここで、前にエラー メッセージからコピーしたコードを貼り付け、Enter を押して実行します。

完了したら、.tags関数を再度実行して、機能するかどうかを確認します。

コードを再度実行すると、エラーが修正され、新しいテキストブロブの各単語とタグまたは品詞を含む結果を受け取ったことがわかります。

これらのタグの意味がわからない場合は、 textblob Web サイトにアクセスして、これらのタグが何を表しているのかを確認してください。

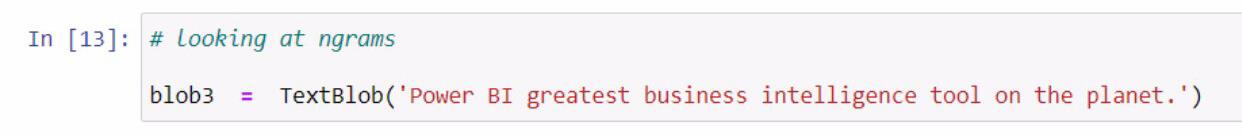

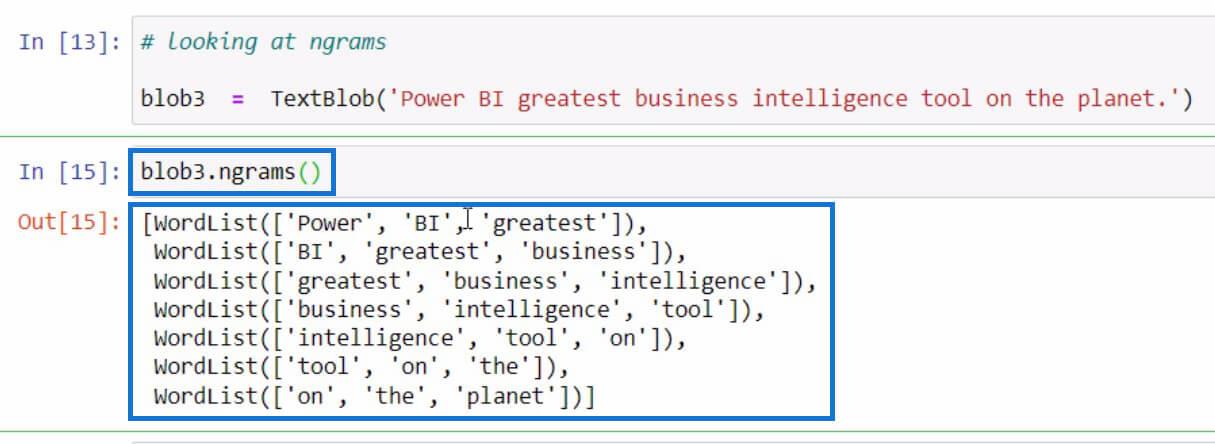

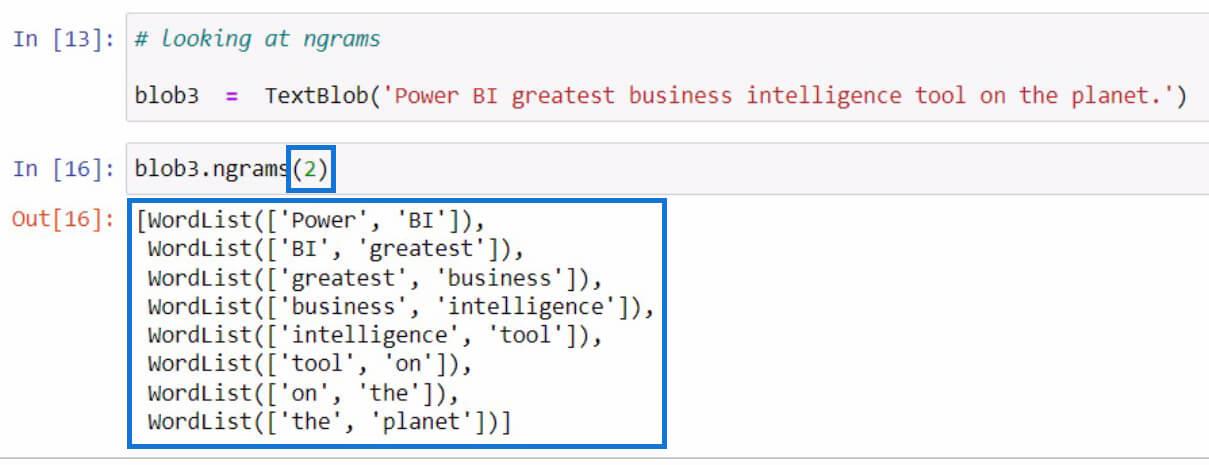

Python でのテキスト分析に ngrams 関数を利用する

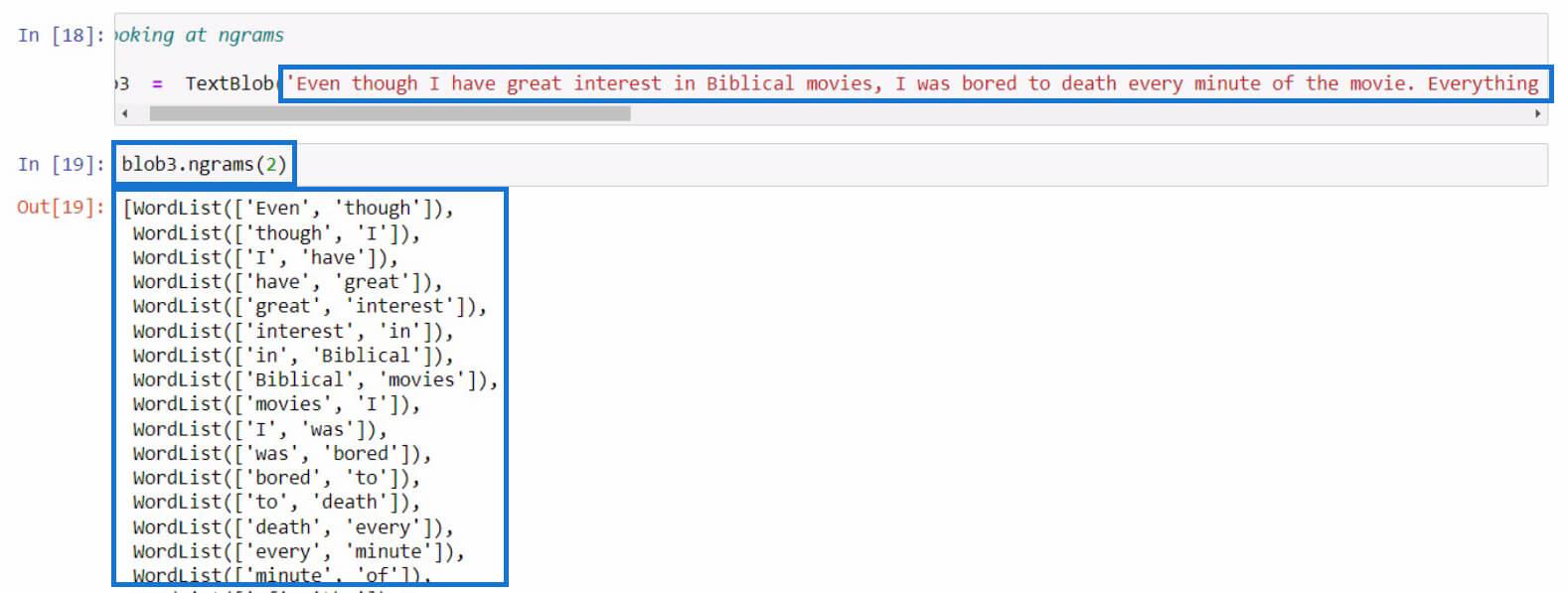

別の例に移りましょう。これはngram の取得に関するものです。ngrams関数は、文または文書内で頻繁に一緒に出現する単語を検索するために使用されます。例として、新しいテキストブロブを作成し、それをblob3変数に保存することから始めましょう。

その後、blob3変数のngrams関数を利用して、いくつかの単語の組み合わせを確認してみましょう。

デフォルトでは、パラメータに値を指定しなかった場合は、トライグラムまたは 3 つの単語の組み合わせが表示されます。ただし、文中の 2 つの単語の組み合わせを確認したい場合は、以下の例のようにパラメーターに2を設定します。

今度は長めの文で試してみましょう。この例では、映画レビューから長いテキストをコピーしただけです。この部分には任意の文を使用できます。

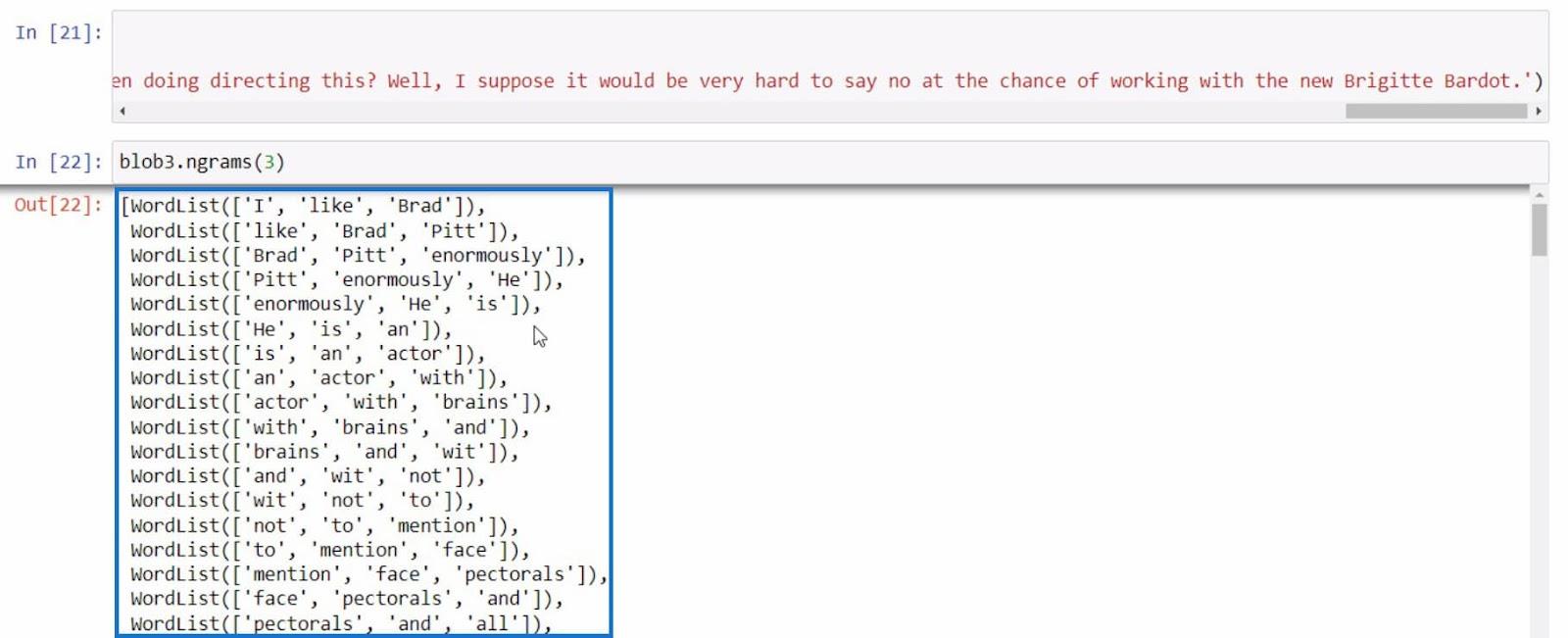

最後の例として、より有益な文でもう一度ngram を使用してみましょう。

これらすべての例を使用すると、 ngrams関数で得られた結果に基づいて、Python でさらに多くのテキスト分析を実行できます。

LuckyTemplates ユーザー向けの Python II – オンデマンド プラットフォームの新しいコースLuckyTemplates

で Python を使用して Python でサンプル データセットを読み込む方法|

データセットと文字列関数

結論

要約すると、Python でテキスト分析を実行するために利用できるさまざまな関数について学習しました。

文中の単語を区切る.tokenize 関数、トークン化された単語を結合する.join 関数、単語の品詞を確認する.tags 関数、単語の組み合わせを表示するngrams 関数です。

さらに、 Anaconda Promptを使用して.tags関数で行ったようなエラーを修正する方法も学びました。また、インポート、テキストブロブの作成、およびPythonでテキスト分析を実行するためにこのライブラリを利用する方法についても学習しました。

ではごきげんよう、

ガリム

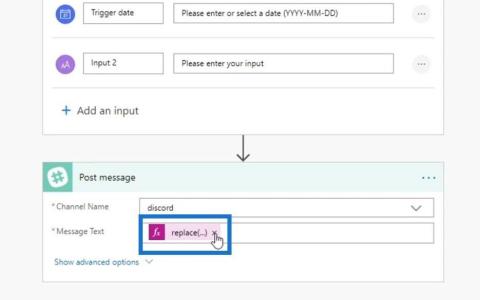

Microsoft フローで使用できる 2 つの複雑な Power Automate String 関数、substring 関数とindexOf 関数を簡単に学習します。

LuckyTemplates ツールチップを使用すると、より多くの情報を 1 つのレポート ページに圧縮できます。効果的な視覚化の手法を学ぶことができます。

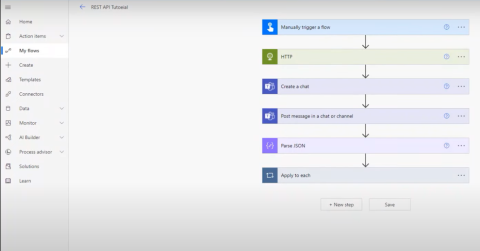

Power Automate で HTTP 要求を作成し、データを受信する方法を学んでいます。

LuckyTemplates で簡単に日付テーブルを作成する方法について学びましょう。データの分析と視覚化のための効果的なツールとして活用できます。

SharePoint 列の検証の数式を使用して、ユーザーからの入力を制限および検証する方法を学びます。

SharePoint リストを Excel ファイルおよび CSV ファイルにエクスポートする方法を学び、さまざまな状況に最適なエクスポート方法を決定できるようにします。

ユーザーがコンピューターから離れているときに、オンプレミス データ ゲートウェイを使用して Power Automate がデスクトップ アプリケーションにアクセスできるようにする方法を説明します。

DAX 数式で LASTNONBLANK 関数を使用して、データ分析の深い洞察を得る方法を学びます。

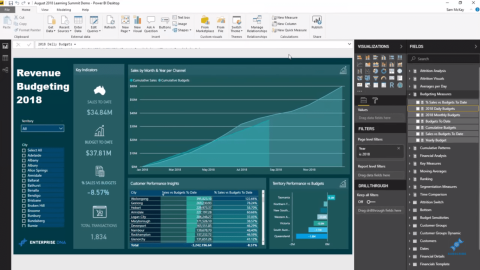

LuckyTemplates で予算分析とレポートを実行しながら、CROSSJOIN 関数を使用して 2 つのデータ テーブルをバインドする方法を学びます。

このチュートリアルでは、LuckyTemplates TREATAS を使用して数式内に仮想リレーションシップを作成する方法を説明します。