En este blog, discutiremos el análisis de texto en Python para crear datos construidos a partir de contenido de texto. Esto lo ayudará a analizar grandes cantidades de datos y consumirá menos tiempo trabajando en ciertas tareas. También adquirirá conocimientos sobre textblob que se ocupan de las tareas de procesamiento del lenguaje natural.

El análisis de texto es el proceso de análisis de textos mediante el uso de códigos para procesos automatizados de producción y agrupación de datos de texto.

Antes de continuar, es posible que deba instalar la biblioteca que usaremos en este tutorial.

Tabla de contenido

Implementando análisis de texto en Python

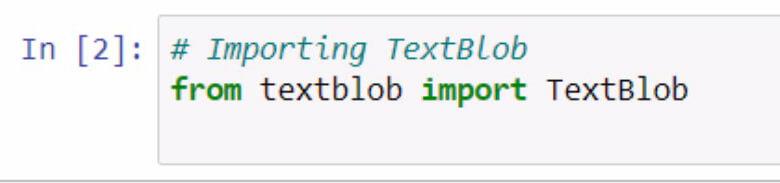

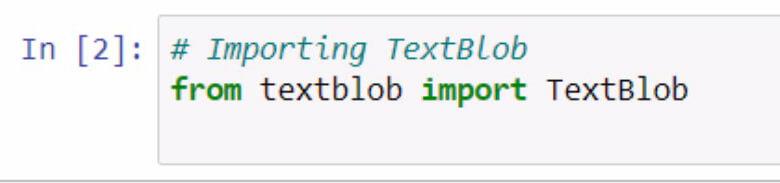

Comencemos por importar textblob . Recuerde documentar lo que está haciendo con el uso de comentarios.

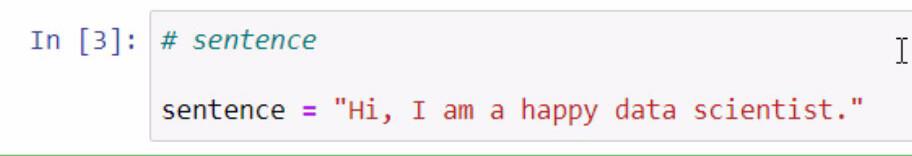

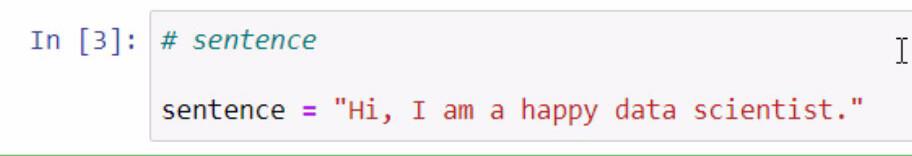

Al ejecutar el código anterior, ahora tenemos acceso a la biblioteca textblob . El siguiente paso que vamos a hacer es crear una oración que usaremos para nuestros ejemplos. Vamos a hacer esto almacenando una oración en una variable llamada oración .

Recuerde encerrar la oración que desea agregar con comillas dobles.

Textblob es una gran biblioteca donde podemos crear un blob y usar algunas de sus funciones para nuestro análisis de texto en Python .

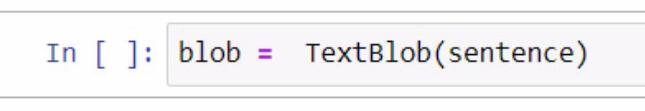

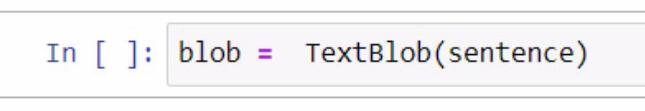

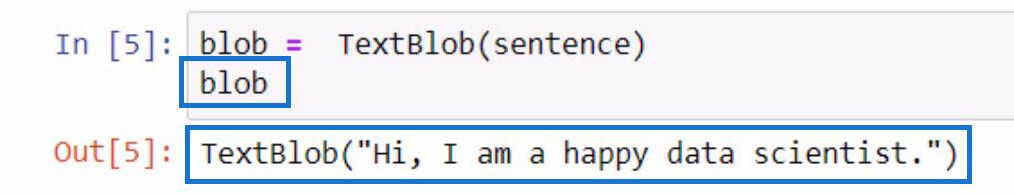

Al crear el blob, comenzamos creando una variable y nombrándola blob . En esta variable, debemos agregar TextBlob , que es la biblioteca que estamos usando.

Dentro de los paréntesis, utilizaremos la variable de oración que contiene la oración que creamos anteriormente. Tenga en cuenta que puede optar por escribir manualmente la oración dentro de los paréntesis para esta parte.

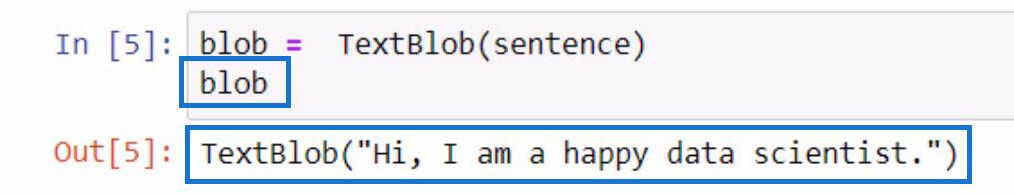

Para verificar lo que hace esta variable de blob , simplemente puede inicializarla escribiendo el nombre de la variable y presionando las teclas Shift + Enter. El resultado debe ser similar al ejemplo siguiente.

Como puede ver en el resultado, la oración que almacenamos en la variable de oración ahora está contenida en TextBlob .

Tokenización de datos de texto en Python

Si desea eliminar algunas palabras en una oración, podemos separar cada una de estas palabras en partes individuales en una lista. Con esta oración dada, lo que vamos a hacer es tokenizarlas o separar cada palabra y ponerla en una lista.

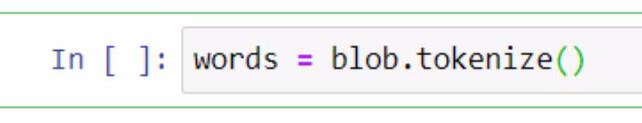

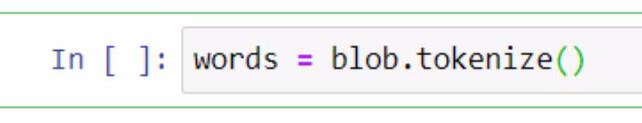

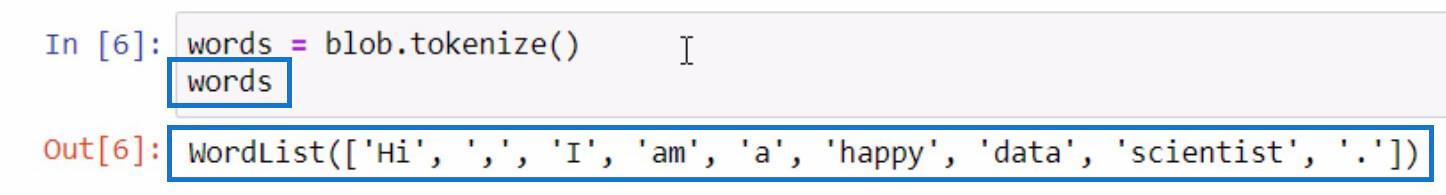

Para hacer esto, utilizaremos la variable blob y usaremos la función tokenizar . Luego lo almacenaremos en una variable llamada palabras .

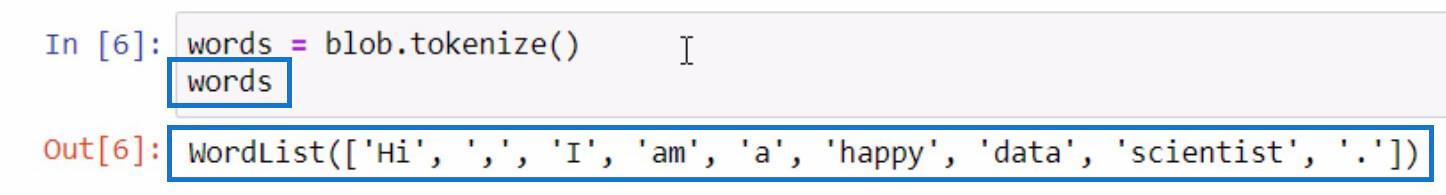

Inicialicemos la variable de palabras de la misma manera que lo hicimos al inicializar la variable de blob para ver qué hay en la lista tokenizada .

Como puede ver, cada una de las palabras, e incluso los signos de puntuación ahora están separados en una lista. Así es como funciona la función tokenizar .

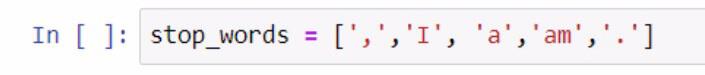

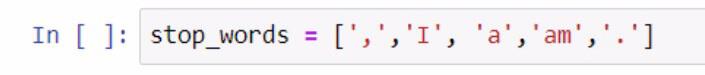

Ahora que tenemos una lista de palabras, podemos realizar otra función a partir de ella. Vamos a crear otra lista de palabras que no queremos que se incluyan en nuestra lista, como puntuaciones y artículos. Para realizar este paso, consulte la captura de pantalla a continuación.

Al crear la lista de palabras vacías, usamos corchetes para encerrar la lista de palabras vacías. Luego, cada una de las palabras vacías se encierra entre comillas simples y cada una está separada por una coma. Almacenamos la lista en la variable stop_words .

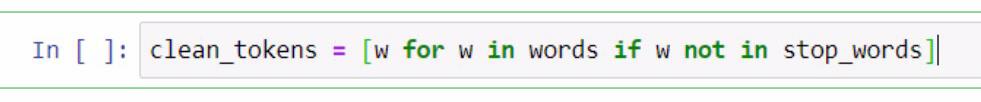

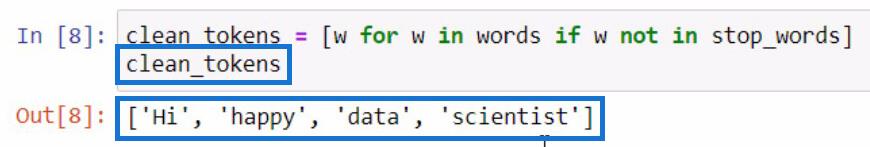

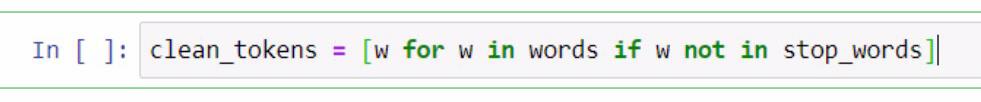

A partir de aquí, vamos a realizar una lista de comprensión para eliminar las palabras que son necesarias para realizar el análisis de texto en Python . Esto incluye limpiar oraciones, tokenizar y comparar diferentes listas. Ahora vamos a comparar estas dos listas y crear una nueva lista de clean_tokens .

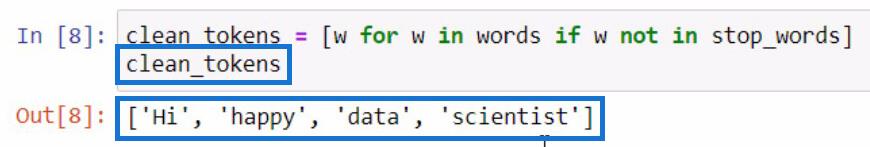

En el código presentado anteriormente, utilizamos un marcador de posición que es w para representar un elemento . Lo que intentamos hacer en esta parte es obtener el elemento en la variable de palabras si el elemento no existe en la variable stop_words . Si vamos a inicializar clean_tokens , este será el resultado.

En este proceso, podemos limpiar nuestros tokens poniendo en marcha un proceso de eliminación de tokens innecesarios, como puntuaciones y artículos. Por eso, solo nos quedan las palabras esenciales en nuestra lista.

Unir tokens para formar una oración en Python

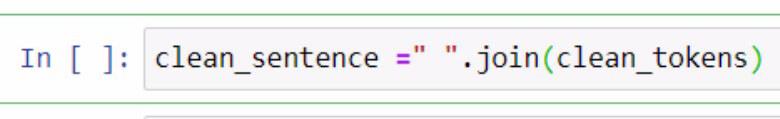

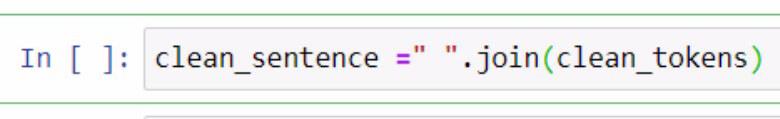

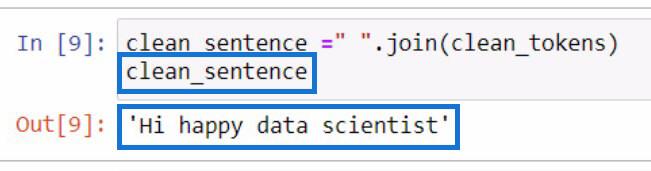

Ahora que hemos separado las fichas limpias , intentemos ponerlas todas juntas en una oración. Para hacer eso, tenemos que utilizar la función .join . Consulte el siguiente ejemplo como referencia.

En el ejemplo anterior, creamos una variable llamada clean_sentence para contener nuestros tokens de limpieza que se combinarán en una oración. También puede notar que agregamos un espacio entre comillas dobles y la función .join . Dentro de los parámetros, incluimos la variable clean_tokens .

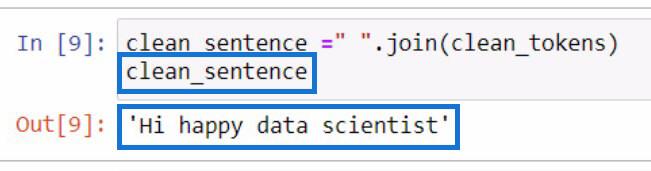

Esta será la salida si inicializamos la variable clean_sentence .

Notablemente, la oración no se ve bien porque eliminamos los artículos y los signos de puntuación anteriormente.

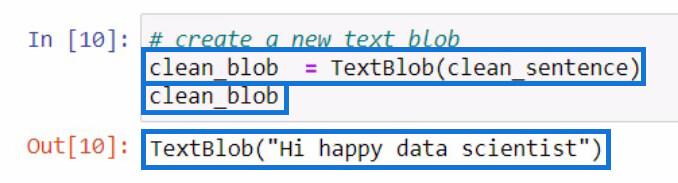

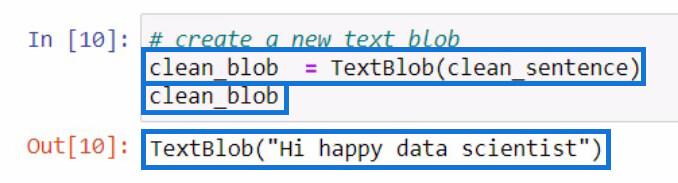

Después de crear clean_sentence , intentemos crear un nuevo textblob que contenga clean_sentence que acabamos de crear. Luego lo almacenaremos en una nueva variable clean_blob .

Disección de una mancha de texto para partes del discurso usando la función .tags

A partir de este blob de análisis, podemos usar las partes de este blob para verificar partes del discurso o realizar incluso más cambios. Intentemos verificar las partes del discurso de cada palabra en nuestro nuevo textblob .

Para verificar las partes del discurso en un textblob, debe usar la función .tags . Hice esto utilizando nuestra variable clean_blob y luego agregué la función .tags justo después.

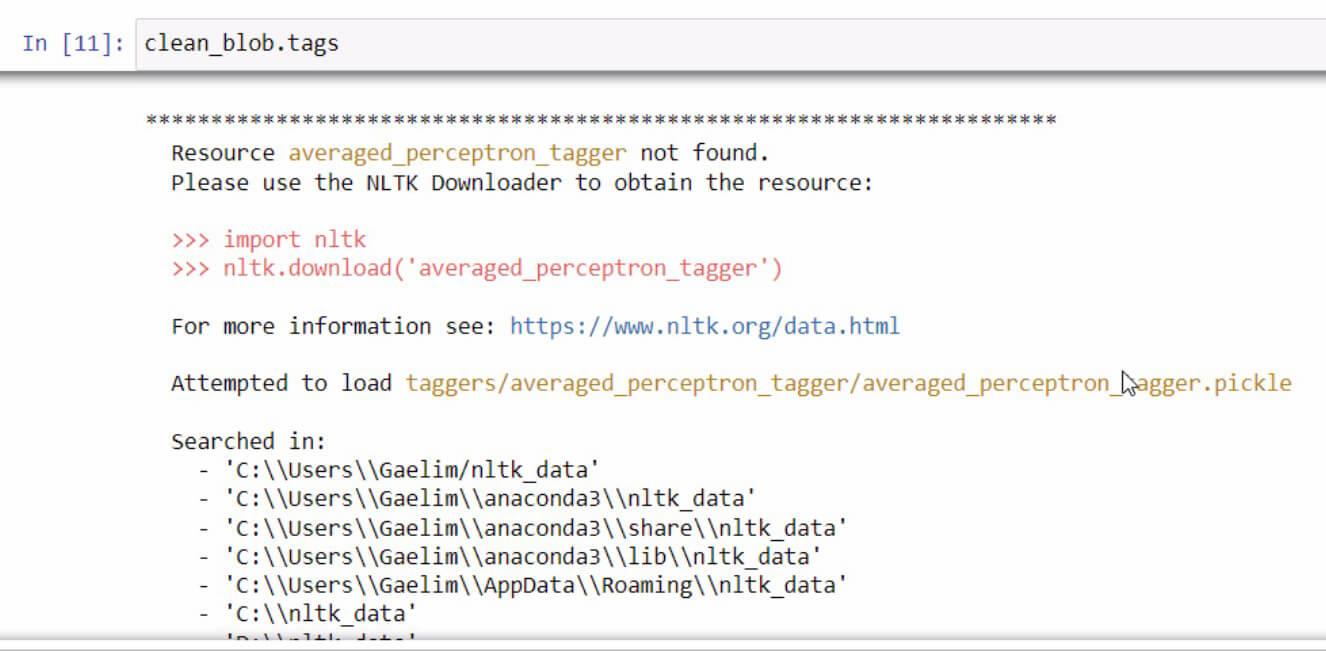

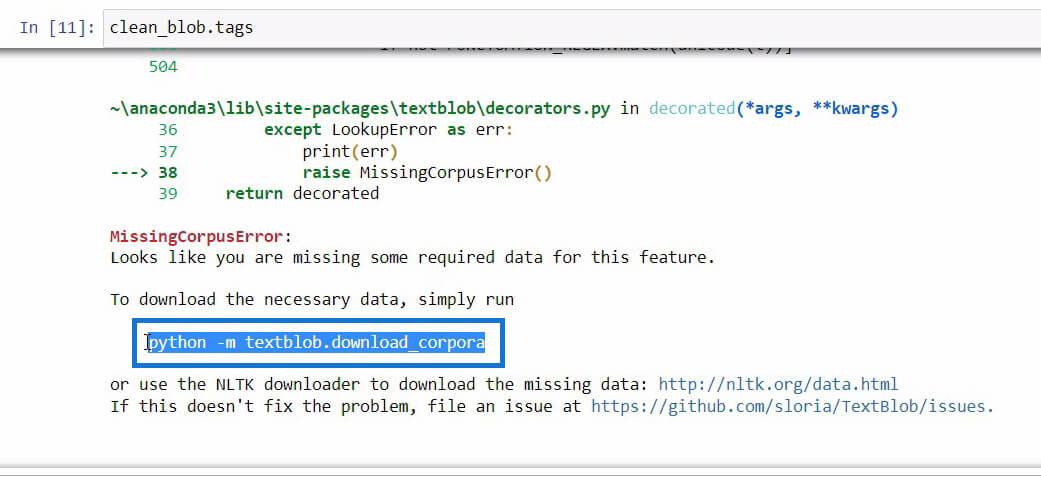

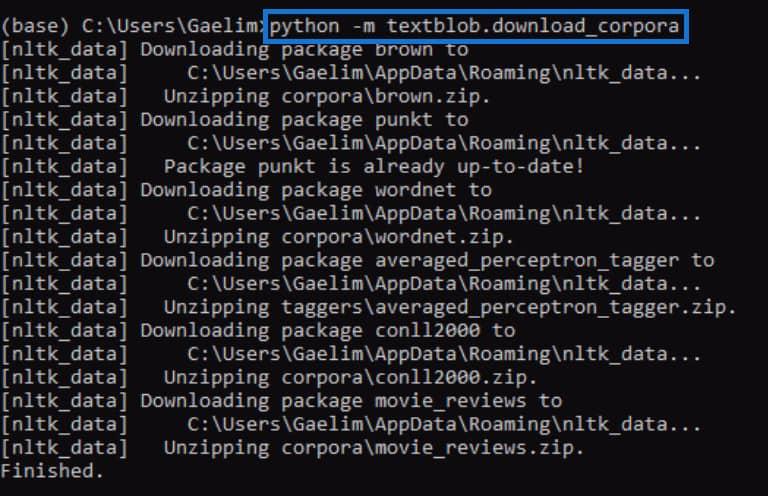

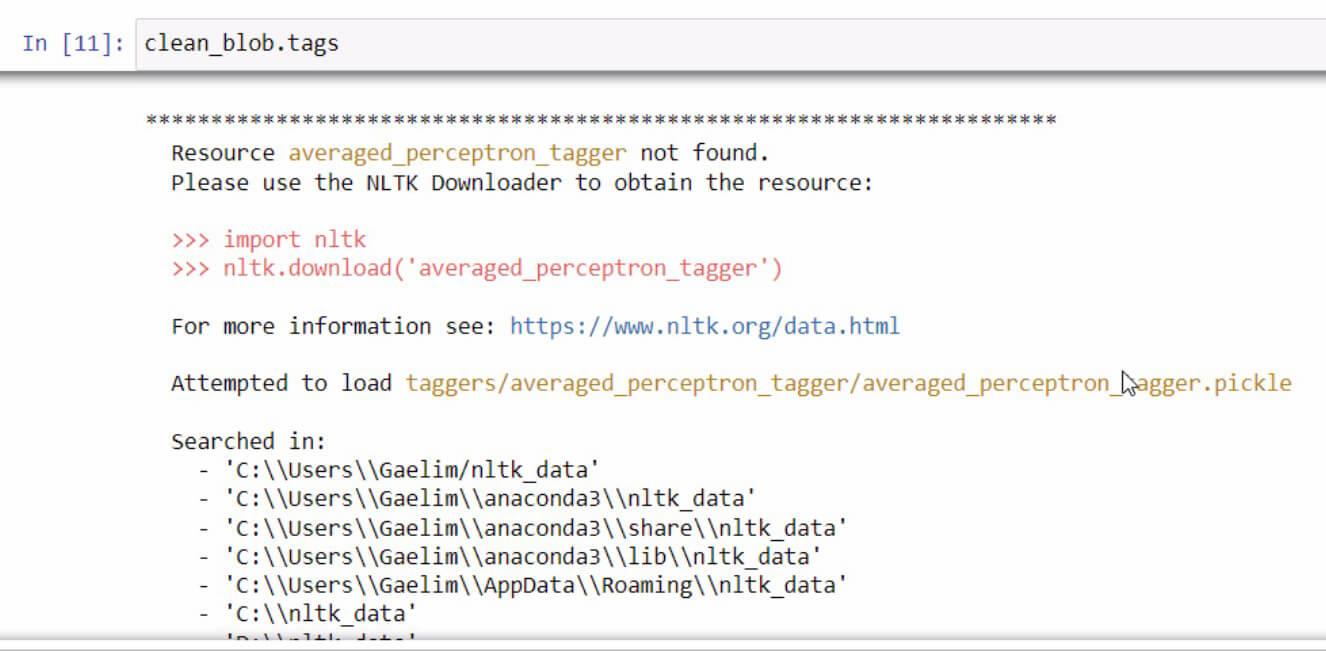

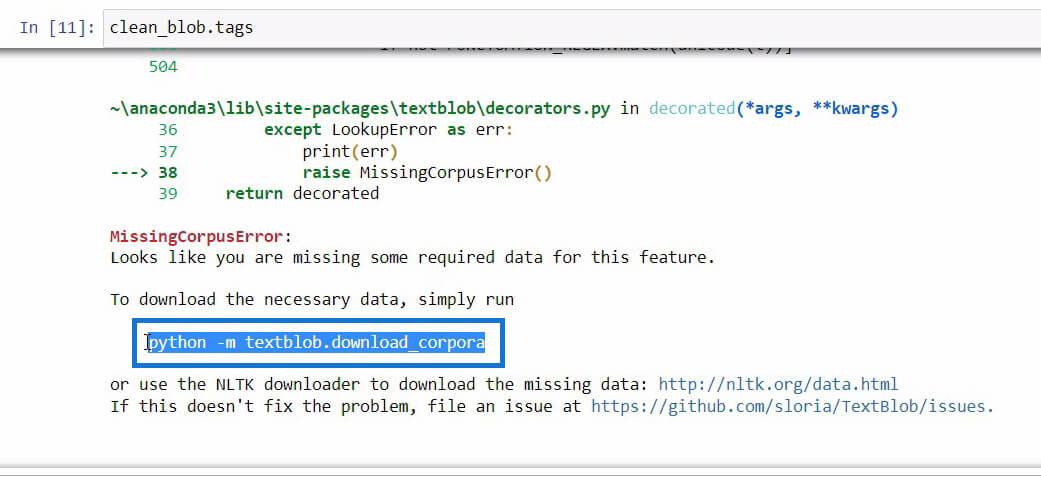

Si alguna vez recibe un mensaje de error al inicializar la función .tags , simplemente lea y siga los pasos para corregir el error. En este caso, así es como se ve.

Si se desplaza hacia abajo al final de este mensaje de error, verá los datos requeridos que necesita para la función que está tratando de usar.

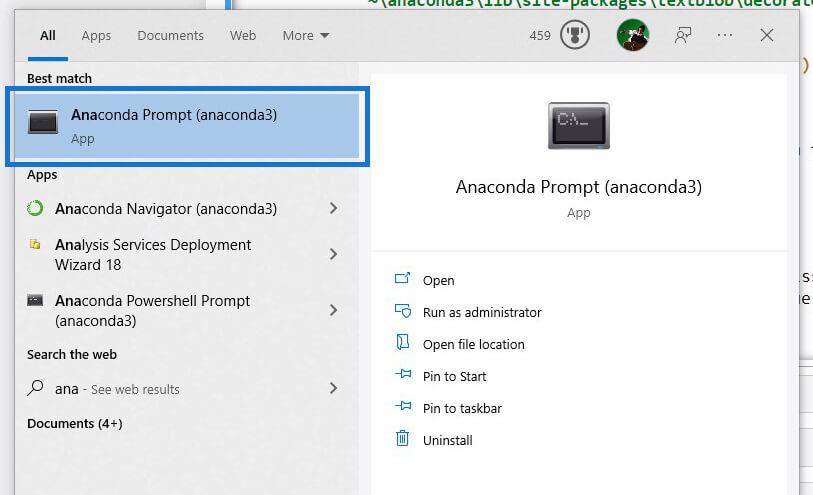

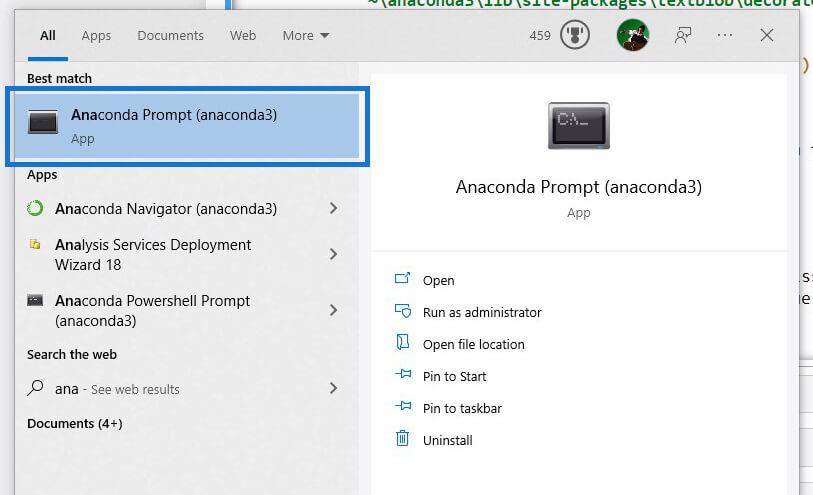

Una vez que encontremos el código que necesitamos inicializar para descargar los datos necesarios, simplemente copie el código y luego abra Anaconda Prompt usando Windows Search .

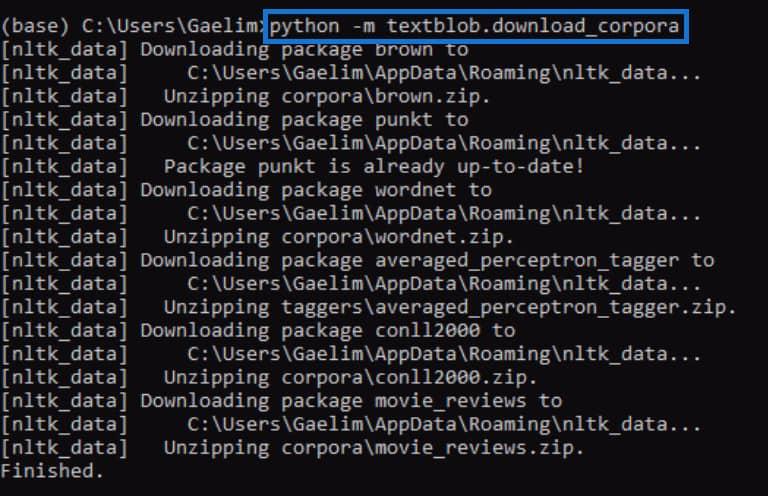

Usando Anaconda Prompt , intentaremos corregir el error que recibimos al inicializar la función .tags . Ahora pegaremos el código que copiamos del mensaje de error anterior y lo ejecutaremos presionando Enter .

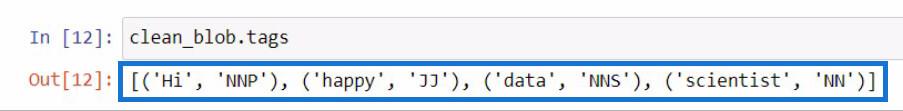

Una vez que haya terminado, intente ejecutar la función .tags nuevamente y vea si funciona.

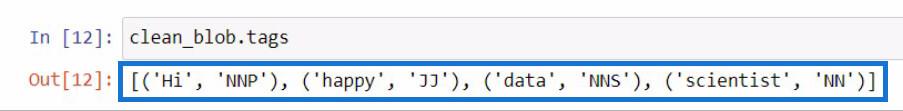

Al volver a ejecutar el código, podemos ver que el error está solucionado y recibimos un resultado que contiene cada palabra del nuevo textblob junto con las etiquetas o partes del discurso.

Si no tiene idea de lo que significan estas etiquetas , simplemente puede ir al sitio web de textblob para verificar qué representan estas etiquetas.

Utilizando la función ngrams para el análisis de texto en Python

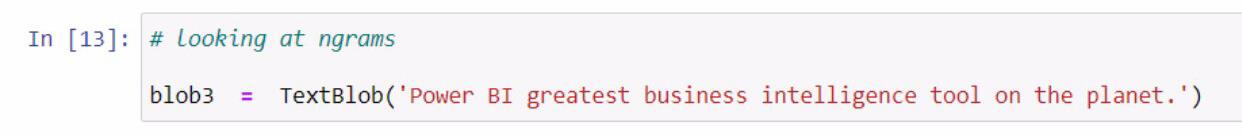

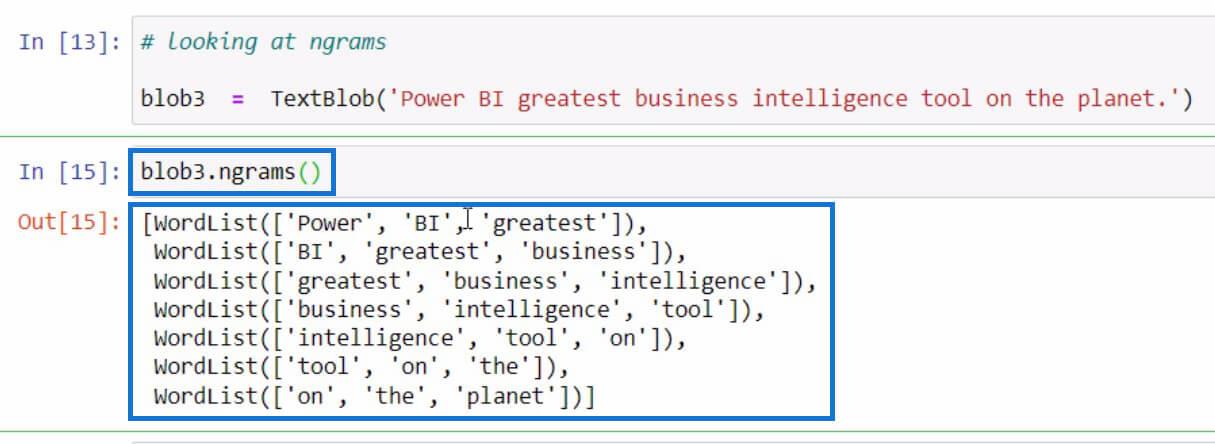

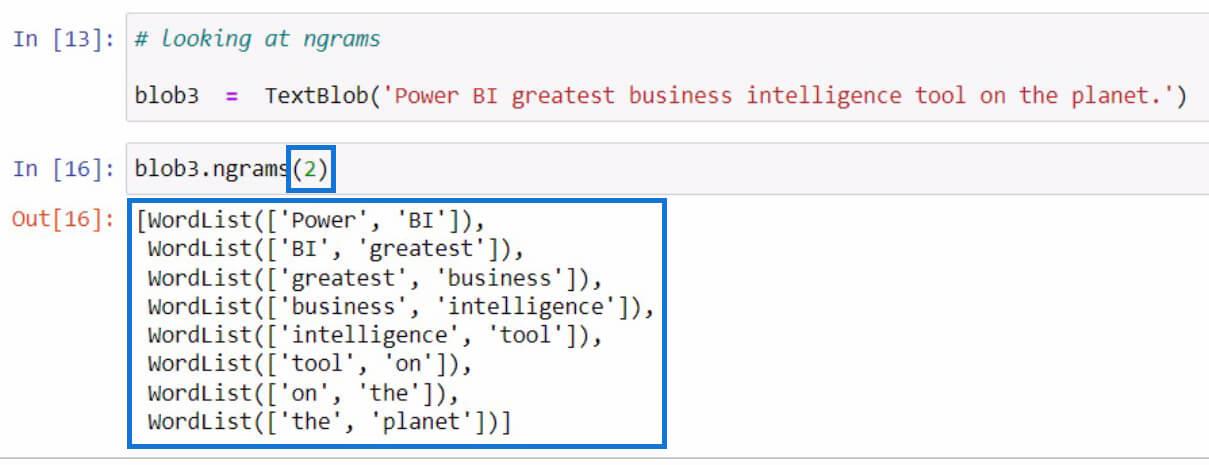

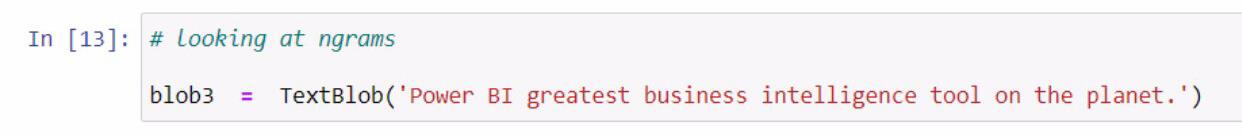

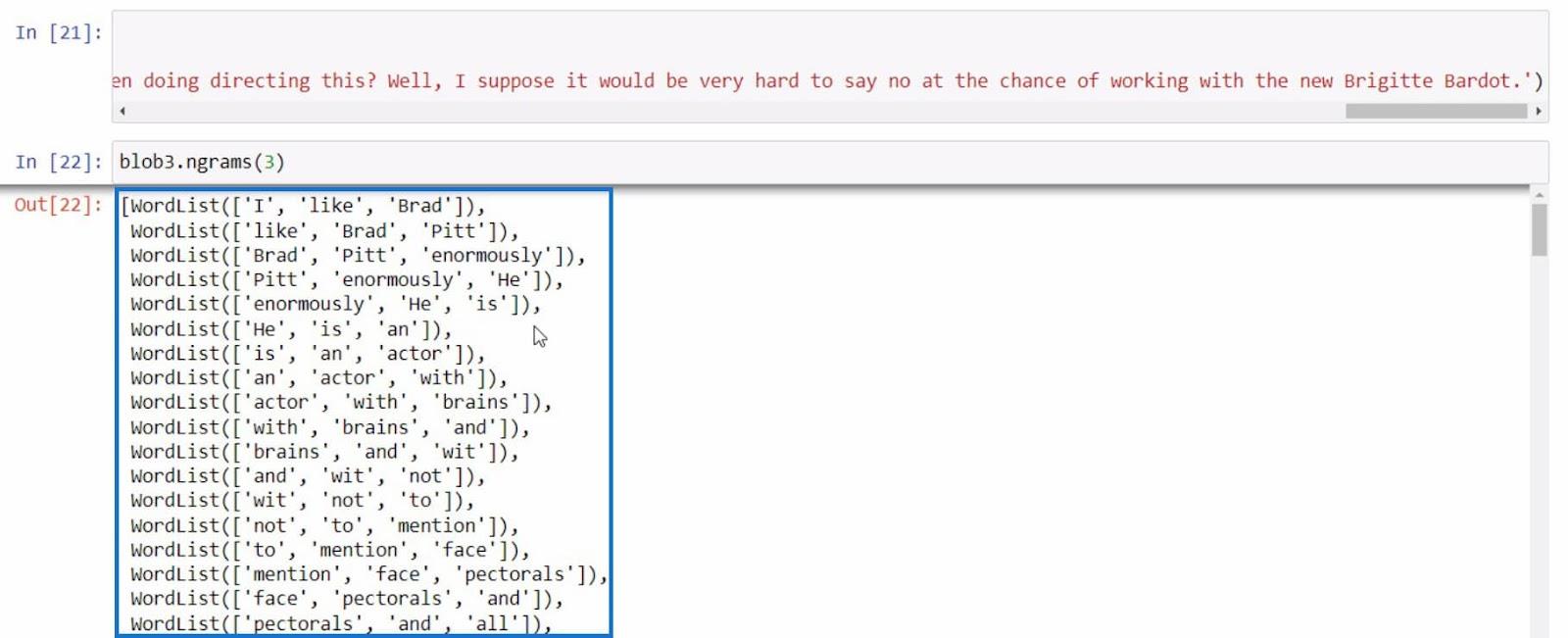

Pasemos a otro ejemplo, que se trata de obtener los ngrams . La función ngrams se utiliza para buscar palabras que se ven frecuentemente juntas en una oración o documento. Como ejemplo, comencemos creando un nuevo textblob y almacenándolo en la variable blob3 .

Después de eso, utilicemos la función ngrams en la variable blob3 para verificar algunas combinaciones de palabras.

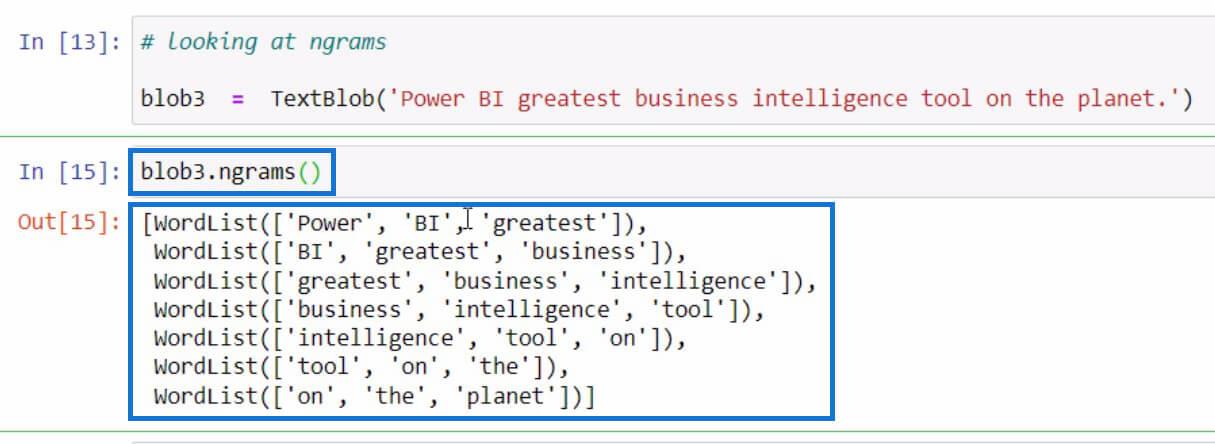

De manera predeterminada, si no especificó un valor en los parámetros, mostrará trigramas o combinaciones de 3 palabras. Pero si queremos ver combinaciones de 2 palabras de la oración, podemos establecer 2 en los parámetros como en el ejemplo a continuación.

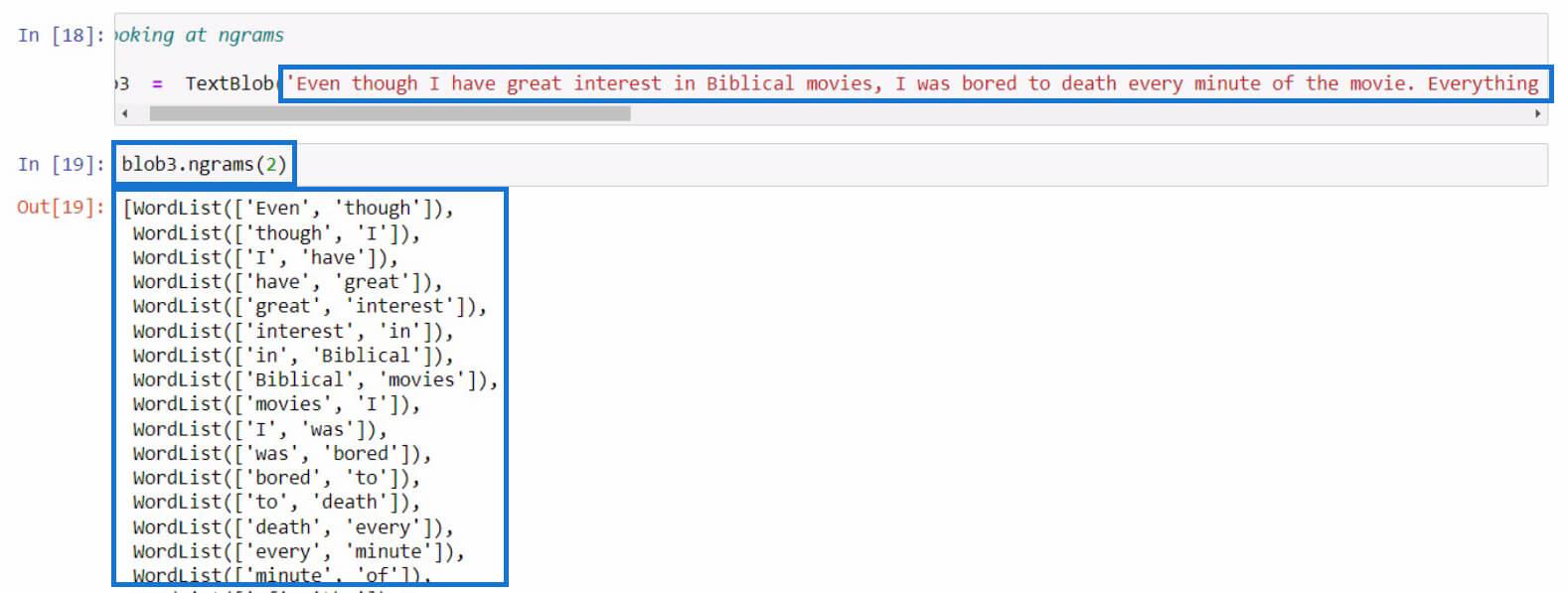

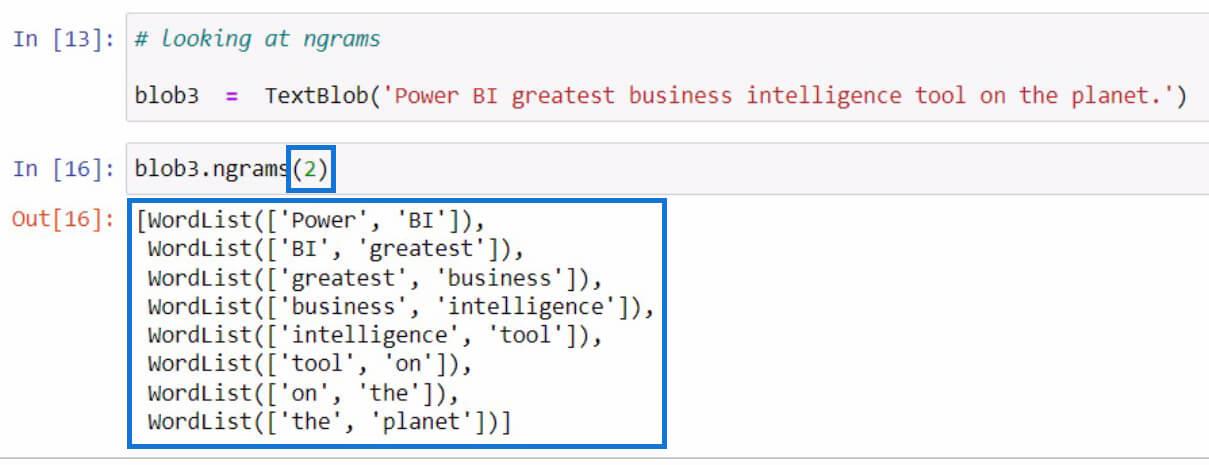

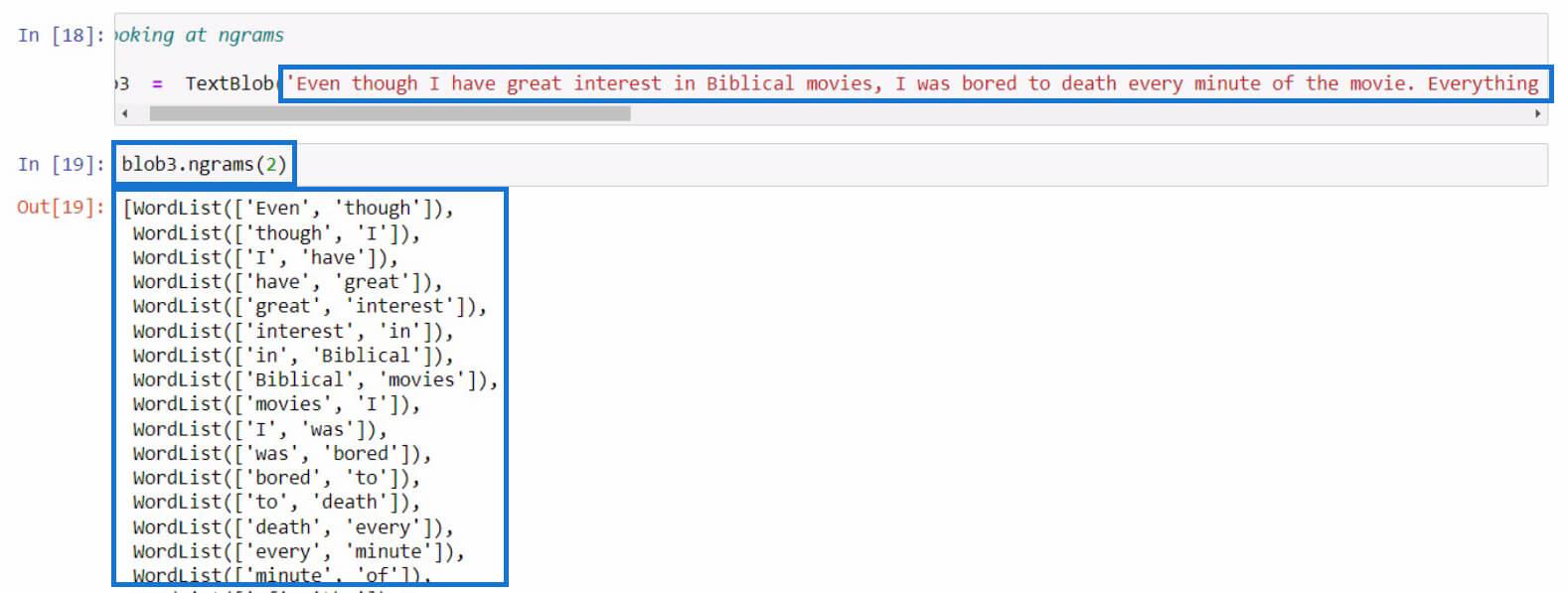

Intentémoslo con una oración más larga esta vez. En este ejemplo, acabo de copiar un texto más largo de una reseña de una película. Puedes usar cualquier oración que quieras para esta parte.

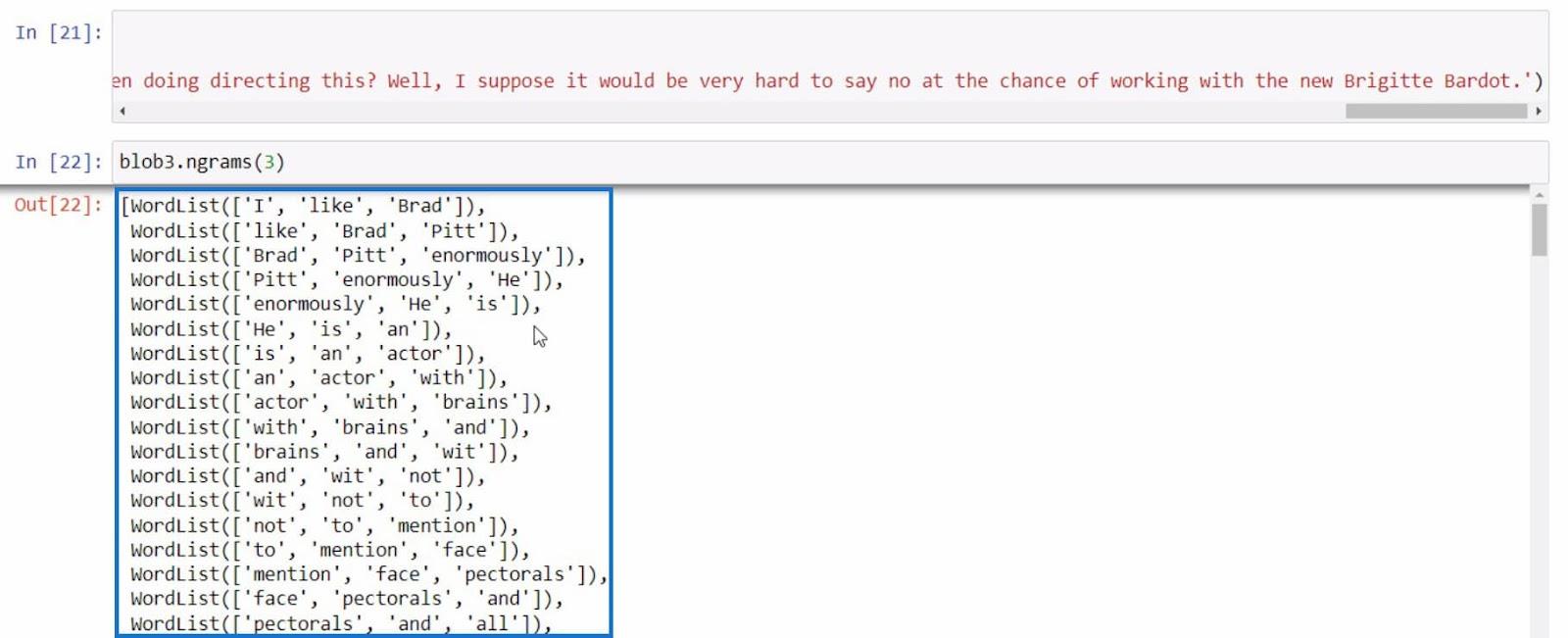

Como ejemplo final, intentemos usar ngrams una vez más con una oración más informativa.

Con todos estos ejemplos, podemos realizar más análisis de texto en Python en función de los resultados que estamos obteniendo con la función ngrams .

Python II para usuarios de LuckyTemplates: nuevo curso en la plataforma bajo demanda

Cómo cargar conjuntos de datos de muestra en Python

usando Python en LuckyTemplates | Conjunto de datos y función de cadena

Conclusión

En resumen, ha aprendido acerca de las diferentes funciones que puede utilizar para realizar análisis de texto en Python.

Estas son la función .tokenize para separar palabras en una oración, la función .join para combinar palabras tokenizadas, la función .tags para verificar las partes del discurso de las palabras y la función ngrams para ver la combinación de palabras.

Además, aprendió a corregir errores como lo que hicimos en la función .tags usando Anaconda Prompt . También aprendió cómo importar, crear un textblob y utilizar esta biblioteca para realizar análisis de texto en Python .

Mis mejores deseos,

Gaellim