SharePoint의 계산된 열 | 개요

SharePoint에서 계산된 열의 중요성과 목록에서 자동 계산 및 데이터 수집을 수행하는 방법을 알아보세요.

이 블로그에서는 텍스트 콘텐츠에서 구성된 데이터를 생성하기 위한 Python의 텍스트 분석에 대해 논의할 것입니다 . 이렇게 하면 많은 양의 데이터를 분석하는 데 도움이 되고 특정 작업에 소요되는 시간을 줄일 수 있습니다. 또한 자연어 처리 작업을 다루는 textblob 에 대한 지식도 습득합니다 .

텍스트 분석은 텍스트 데이터를 생성하고 그룹화하는 자동화된 프로세스를 위해 코드를 사용하여 텍스트를 분석하는 프로세스입니다.

진행하기 전에 이 자습서에서 사용할 라이브러리를 설치해야 할 수 있습니다.

목차

Python에서 텍스트 분석 구현

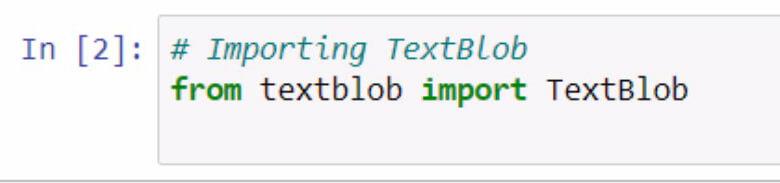

textblob 을 가져오는 것으로 시작하겠습니다 . 주석을 사용하여 수행 중인 작업을 문서화하는 것을 잊지 마십시오.

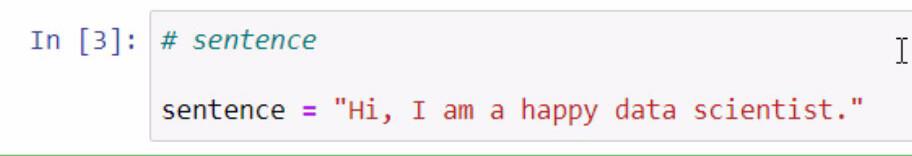

위의 코드를 실행하면 이제 textblob 라이브러리에 액세스할 수 있습니다. 우리가 할 다음 단계는 예제에 사용할 문장을 만드는 것입니다. 우리는 sentence 라는 변수에 문장을 저장하여 이를 수행할 것입니다 .

추가하려는 문장을 큰따옴표로 묶어야 합니다.

textblob은 Python 에서 텍스트 분석을 위해 blob을 만들고 일부 기능을 사용할 수 있는 훌륭한 라이브러리입니다 .

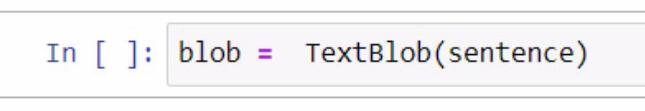

Blob을 만들 때 변수를 만들고 이름을 blob 로 지정하는 것으로 시작합니다 . 이 변수에는 사용 중인 라이브러리인 TextBlob을 추가해야 합니다 .

괄호 안에는 앞에서 만든 문장을 포함하는 문장 변수를 활용합니다. 이 부분의 괄호 안에 문장 자체를 수동으로 입력하도록 선택할 수 있습니다.

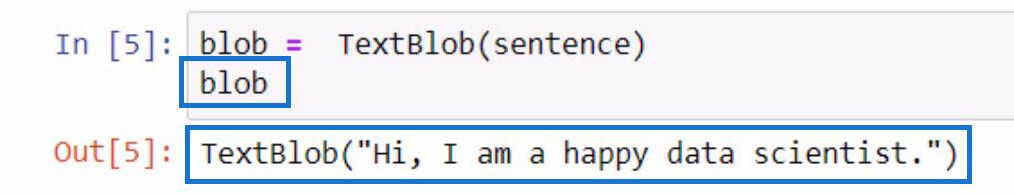

이 blob 변수의 기능을 확인하려면 변수 이름을 입력하고 Shift + Enter 키를 눌러 간단히 초기화할 수 있습니다. 출력은 아래 예와 유사해야 합니다.

결과에서 볼 수 있듯이 sentence 변수에 저장한 문장은 이제 TextBlob 에 포함됩니다 .

Python에서 텍스트 데이터 토큰화

문장에서 일부 단어를 제거하려는 경우 각 단어를 목록의 개별 부분으로 분리할 수 있습니다. 이 주어진 문장으로 우리가 할 일은 그것들을 토큰화하거나 각 단어를 분리하여 목록에 넣는 것입니다.

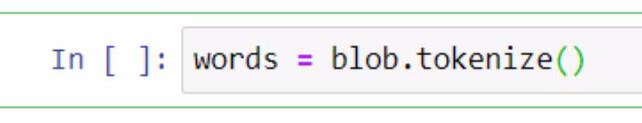

이를 위해 blob 변수를 활용하고 토큰화 기능을 사용할 것입니다. 그런 다음 단어 라는 변수에 저장합니다 .

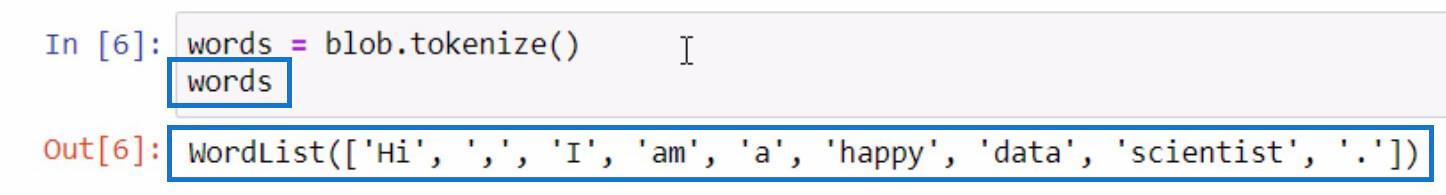

토큰화된 목록 에 무엇이 있는지 확인하기 위해 blob 변수를 초기화할 때 했던 것과 같은 방식으로 words 변수를 초기화해 보겠습니다 .

보시다시피 이제 각 단어와 구두점까지 목록으로 구분됩니다. 이것이 토큰화 기능이 작동하는 방식입니다.

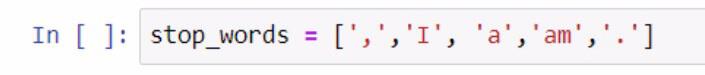

이제 단어 목록이 있으므로 다른 기능을 수행할 수 있습니다. 구두점 및 관사와 같이 목록에 포함하고 싶지 않은 다른 단어 목록을 만들어 봅시다. 이 단계를 수행하려면 아래 스크린샷을 참조하십시오.

불용어 목록을 만들 때 대괄호를 사용하여 불용어 목록을 묶었습니다. 그런 다음 각 중지 단어는 작은따옴표로 묶고 각각은 쉼표로 구분됩니다. stop_words 변수 에 목록을 저장했습니다 .

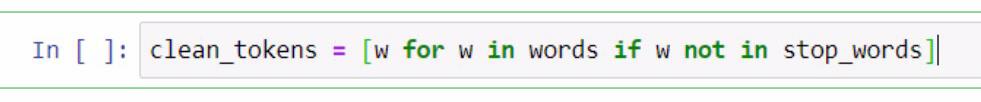

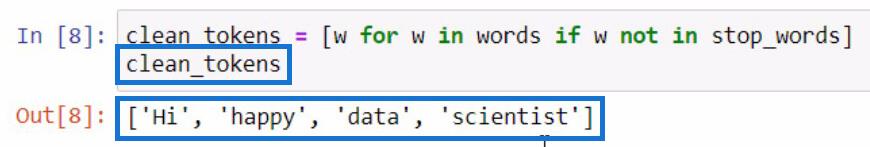

여기서부터는 Python 에서 텍스트 분석을 수행하는 데 필요한 단어를 제거하기 위해 목록 이해를 수행합니다 . 여기에는 문장 정리, 토큰화 및 서로 다른 목록 비교가 포함됩니다. 이제 이 두 목록을 비교하고 clean_tokens 의 새 목록을 만들 것입니다 .

위에 제시된 코드에서 요소를 나타내는 w 자리 표시자를 사용했습니다 . 이 부분에서 하려는 것은 요소가 stop_words 변수에 존재하지 않는 경우 단어 변수의 요소를 가져오는 것 입니다 . clean_tokens 를 초기화하려는 경우 이것이 결과가 됩니다.

이 과정에서 구두점, 관사 등 불필요한 토큰을 제거하는 과정을 거쳐 토큰을 정리할 수 있습니다 . 그 때문에 목록에 핵심 단어만 남아 있습니다.

Python에서 문장을 형성하기 위해 토큰 결합

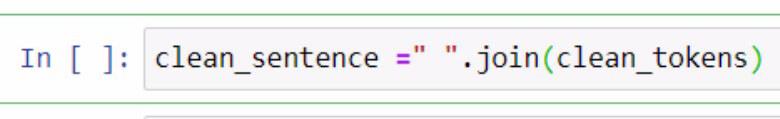

깨끗한 토큰을 분리했으므로 이제 모두 한 문장에 넣어 봅시다. 그러기 위해서는 .join 함수를 활용해야 합니다. 참조를 위해 아래 예를 확인하십시오.

위의 예에서 우리는 clean_sentence 라는 변수를 만들어 문장으로 결합될 깨끗한 토큰을 보관했습니다. 또한 큰따옴표로 묶인 공백과 .join 함수를 추가했음을 알 수 있습니다. 매개변수 내부에 clean_tokens 변수를 포함했습니다 .

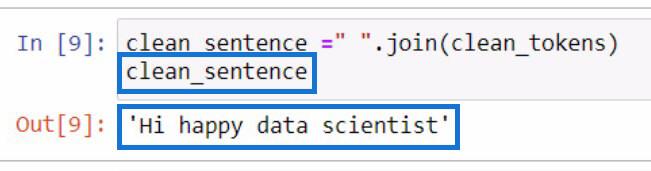

clean_sentence 변수를 초기화하면 출력이 됩니다 .

눈에 띄게, 이전에 관사와 구두점을 제거했기 때문에 문장이 올바르게 보이지 않습니다.

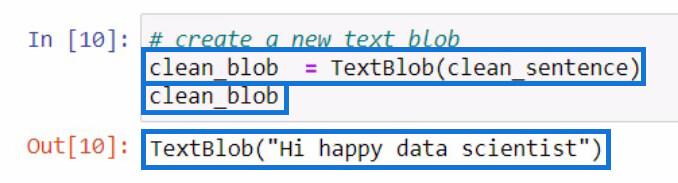

clean_sentence 를 만든 후 방금 만든 clean_sentence 를 포함하는 새 텍스트 블롭을 만들어 보겠습니다 . 그런 다음 새 변수 clean_blob 에 저장합니다 .

.tags 함수를 사용하여 품사에 대한 Textblob 해부

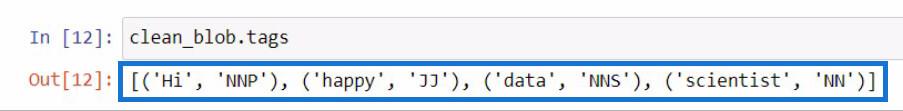

이 분석 blob에서 이 blob의 일부를 사용하여 품사를 확인하거나 더 많은 변경을 수행할 수 있습니다. 새로운 textblob 에서 각 단어의 품사를 확인해 봅시다 .

textblob에서 품사를 확인하려면 .tags 기능을 사용해야 합니다. clean_blob 변수를 활용하여 이 작업 을 수행한 다음 바로 뒤에 .tags 함수를 추가했습니다 .

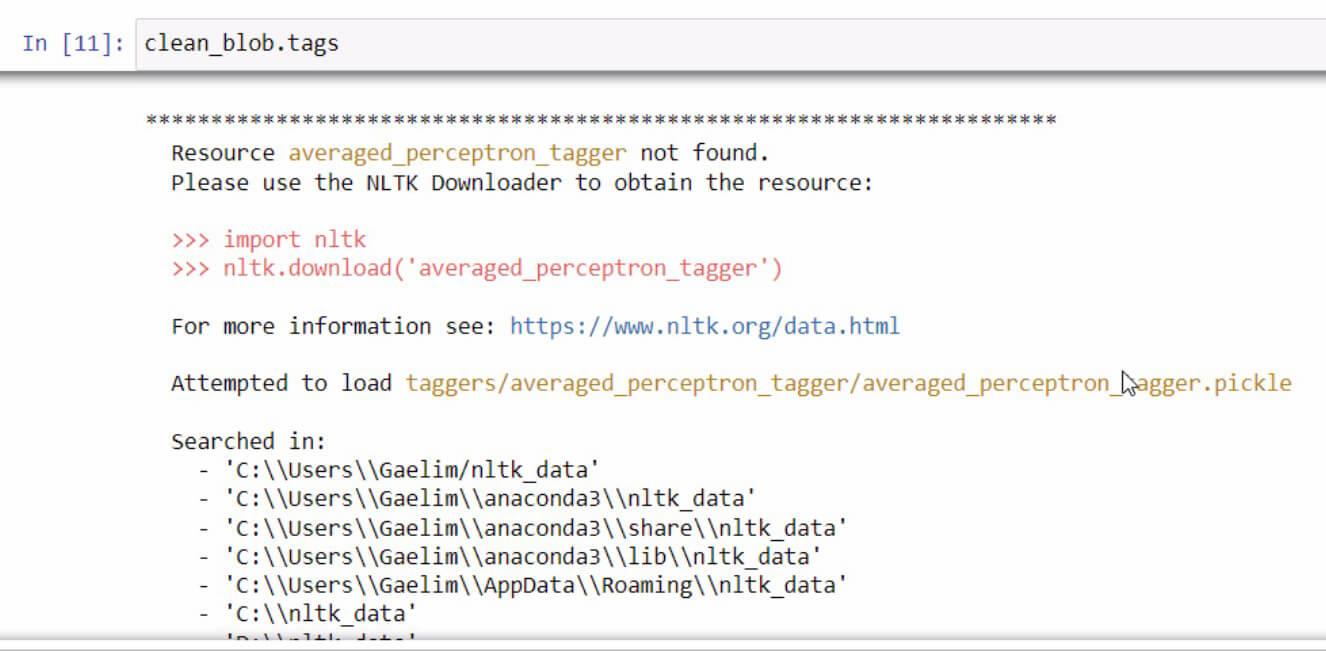

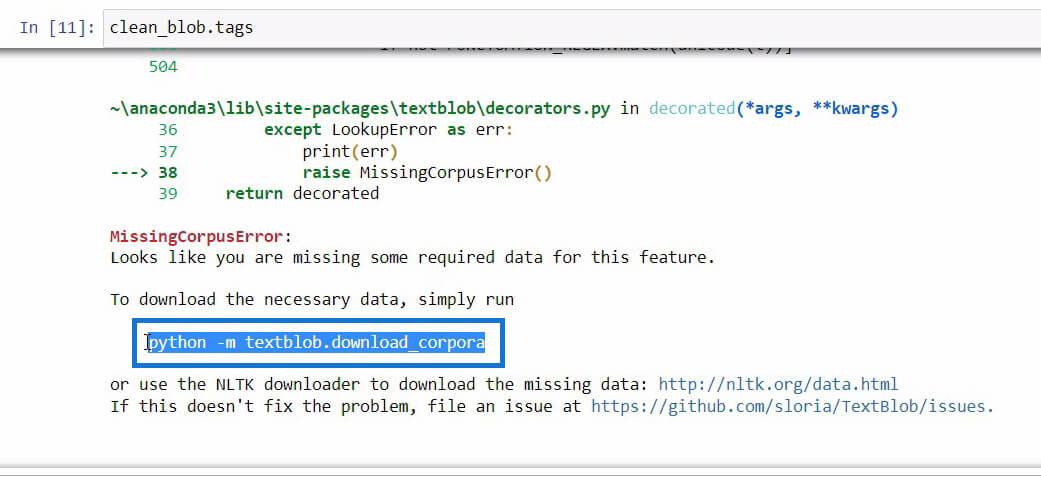

.tags 함수를 초기화할 때 오류 메시지가 표시되면 오류를 수정하기 위한 단계를 읽고 따르십시오. 이 경우에는 이렇게 생겼습니다.

이 오류 메시지 끝에서 아래로 스크롤하면 사용하려는 기능에 필요한 필수 데이터가 표시됩니다.

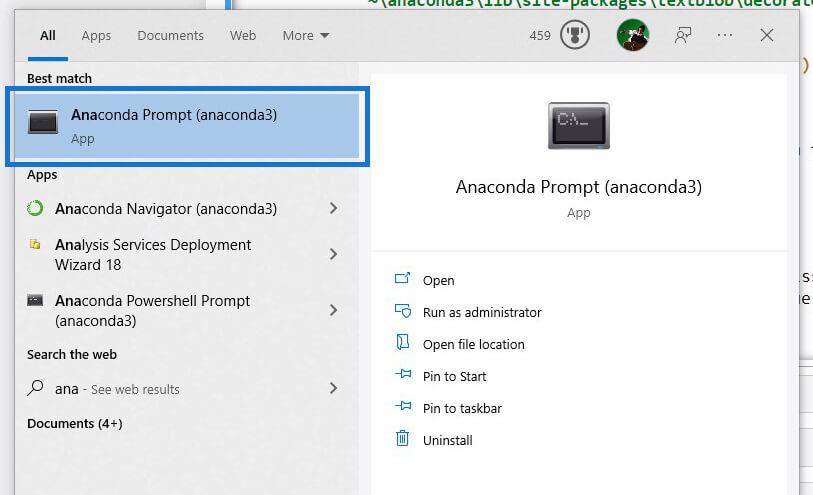

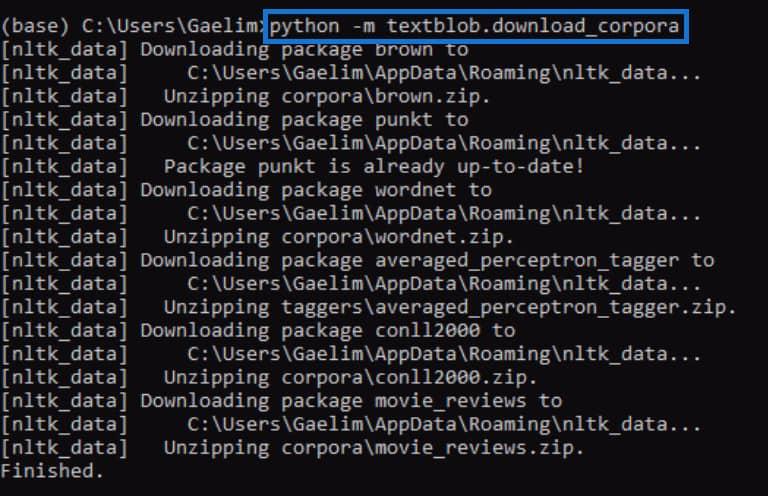

필요한 데이터를 다운로드하기 위해 초기화해야 하는 코드를 찾으면 코드를 복사한 다음 Windows 검색을 사용하여 Anaconda Prompt를 엽니다 .

Anaconda Prompt를 사용하여 .tags 함수 를 초기화할 때 받은 오류를 수정하려고 합니다 . 이제 앞에서 오류 메시지에서 복사한 코드를 붙여넣고 Enter 키를 눌러 실행합니다 .

완료되면 .tags 기능을 다시 실행하고 작동하는지 확인하십시오.

코드를 다시 실행하면 오류가 수정되고 태그 또는 품사 와 함께 새 textblob 의 각 단어가 포함된 결과를 받은 것을 볼 수 있습니다 .

이러한 태그의 의미 를 모르는 경우 textblob 웹 사이트 로 이동하여 이러한 태그가 무엇을 나타내는지 확인할 수 있습니다.

파이썬에서 텍스트 분석을 위한 ngrams 함수 활용

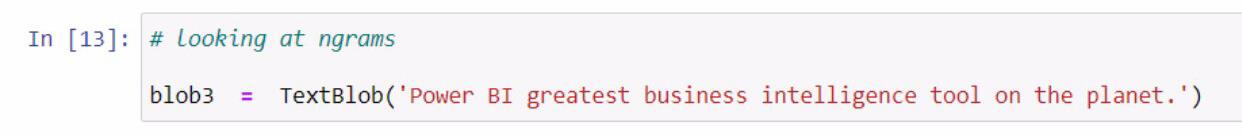

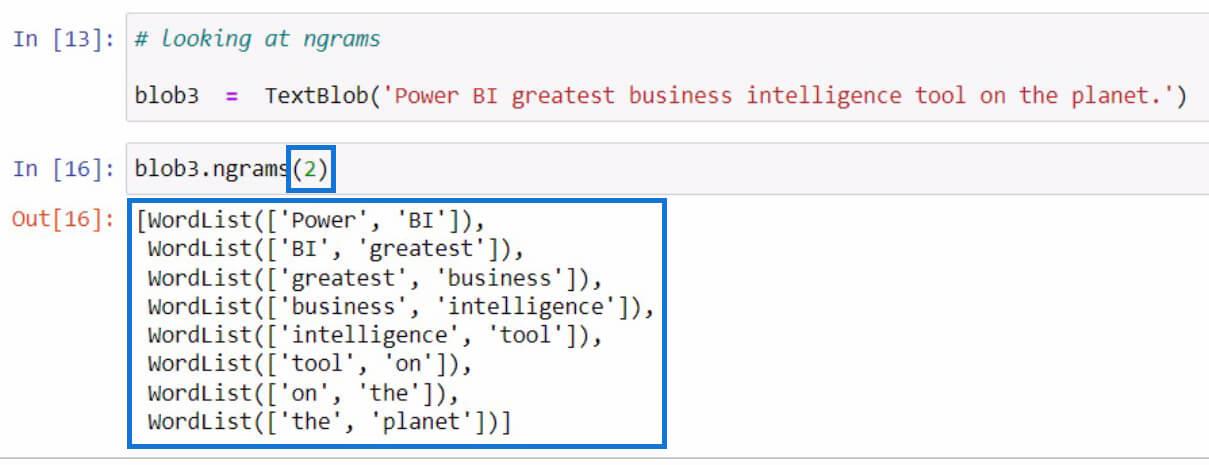

ngrams 가져오기에 관한 다른 예로 이동해 보겠습니다 . ngrams 함수는 문장이나 문서 에서 자주 함께 보이는 단어를 찾는 데 사용됩니다. 예를 들어 새 textblob을 만들고 blob3 변수 에 저장하는 것으로 시작하겠습니다 .

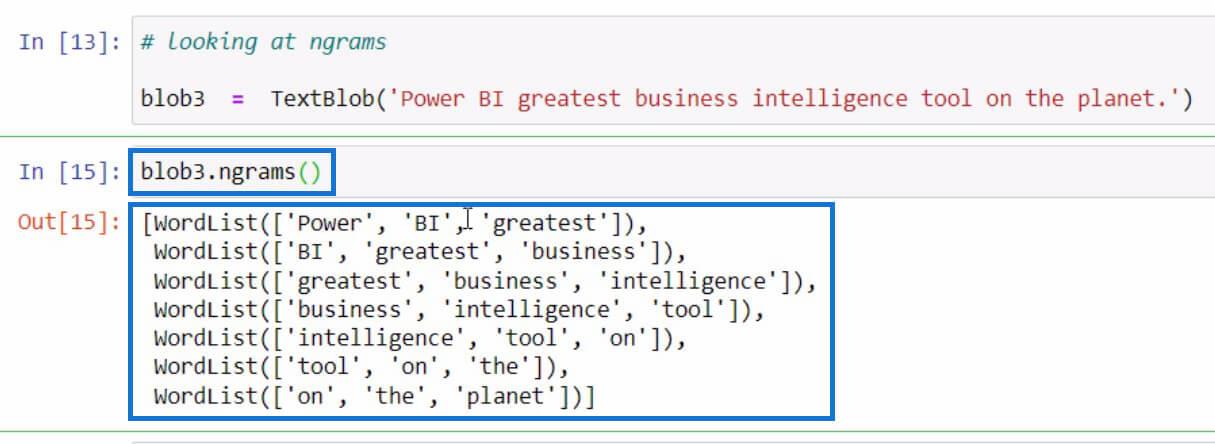

그런 다음 blob3 변수 의 ngrams 함수를 활용하여 일부 단어 조합을 확인하겠습니다.

기본적으로 매개변수에 값을 지정하지 않은 경우 트라이그램 또는 3단어 조합이 표시됩니다 . 하지만 문장에서 2단어 조합을 보고 싶다면 아래 예와 같이 매개 변수에 2를 설정할 수 있습니다.

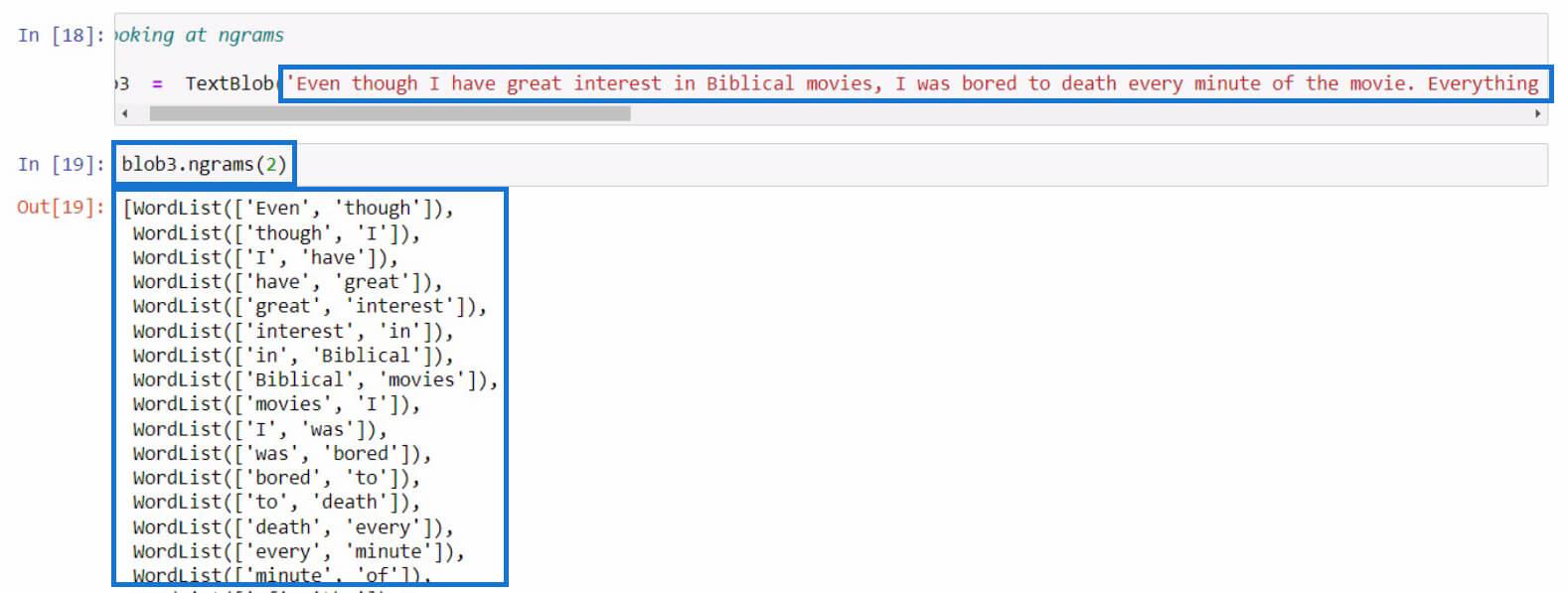

이번에는 좀 더 긴 문장으로 해봅시다. 이 예에서는 영화 리뷰에서 더 긴 텍스트를 복사했습니다. 이 부분에 대해 원하는 문장을 사용할 수 있습니다.

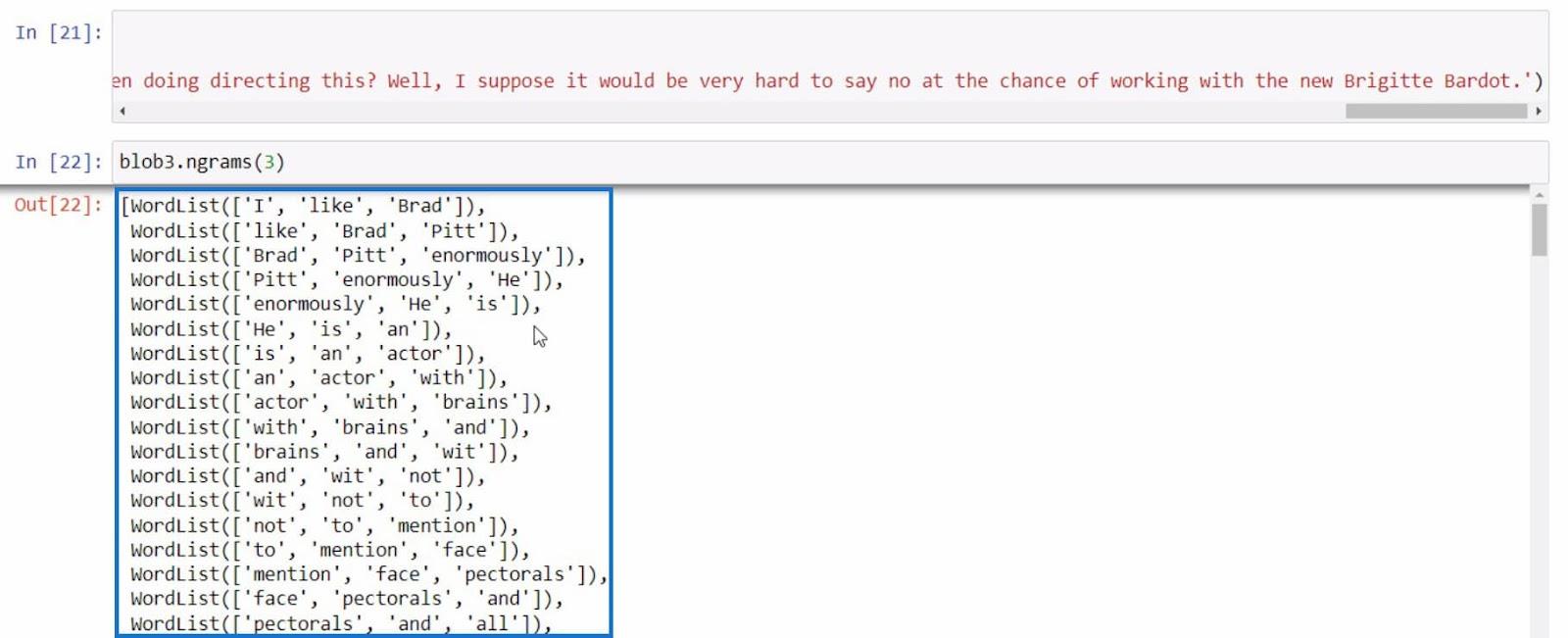

마지막 예로서, 더 많은 정보를 제공하는 문장으로 ngram을 한 번 더 사용해 봅시다 .

이 모든 예제를 통해 ngrams 함수 로 얻은 결과를 기반으로 Python에서 더 많은 텍스트 분석을 수행할 수 있습니다 .

LuckyTemplates 사용자를 위한 Python II – 주문형 플랫폼의 새로운 과정 LuckyTemplates에서 Python을 사용하여 Python

에서 샘플 데이터 세트를 로드하는 방법 |

데이터 세트 및 문자열 함수

결론

요약하면 Python에서 텍스트 분석을 수행하는 데 활용할 수 있는 다양한 기능에 대해 배웠습니다.

문장에서 단어를 분리하는 .tokenize 기능 , 토큰화된 단어를 결합하는 .join 기능 , 단어의 품사를 확인하는 .tags 기능 , 단어 조합을 볼 수 있는 ngrams 기능 입니다 .

또한 Anaconda Prompt를 사용하여 .tags 함수 에서 수행한 것과 같은 오류를 수정하는 방법을 배웠습니다 . 또한 Python 에서 텍스트 분석을 수행하기 위해 텍스트 블롭을 가져오고 생성 하고 이 라이브러리를 활용하는 방법을 배웠습니다 .

모두 제일 좋다,

갤림

SharePoint에서 계산된 열의 중요성과 목록에서 자동 계산 및 데이터 수집을 수행하는 방법을 알아보세요.

컬렉션 변수를 사용하여 Power Apps에서 변수 만드는 방법 및 유용한 팁에 대해 알아보세요.

Microsoft Flow HTTP 트리거가 수행할 수 있는 작업과 Microsoft Power Automate의 예를 사용하여 이를 사용하는 방법을 알아보고 이해하십시오!

Power Automate 흐름 및 용도에 대해 자세히 알아보세요. 다양한 작업 및 시나리오에 사용할 수 있는 다양한 유형의 흐름에 대해 설명합니다.

조건이 충족되지 않는 경우 흐름에서 작업을 종료하는 Power Automate 종료 작업 컨트롤을 올바르게 사용하는 방법을 알아봅니다.

PowerApps 실행 기능에 대해 자세히 알아보고 자신의 앱에서 바로 웹사이트, 전화, 이메일 및 기타 앱과 같은 기타 서비스를 실행하십시오.

타사 애플리케이션 통합과 관련하여 Power Automate의 HTTP 요청이 작동하는 방식을 배우고 이해합니다.

Power Automate Desktop에서 Send Mouse Click을 사용하는 방법을 알아보고 이것이 어떤 이점을 제공하고 흐름 성능을 개선하는지 알아보십시오.

PowerApps 변수의 작동 방식, 다양한 종류, 각 변수가 앱에 기여할 수 있는 사항을 알아보세요.

이 자습서에서는 Power Automate를 사용하여 웹 또는 데스크톱에서 작업을 자동화하는 방법을 알려줍니다. 데스크톱 흐름 예약에 대한 포괄적인 가이드를 제공합니다.