Streudiagramm-Visualisierungen mit Charticulator

In diesem Tutorial erfahren Sie, wie Sie mit Charticulator eine Streudiagramm-Visualisierung für Ihren LuckyTemplates-Bericht erstellen und entwerfen.

In diesem Blog besprechen wir die Textanalyse in Python zum Erstellen konstruierter Daten aus Textinhalten. Dies hilft Ihnen bei der Analyse großer Datenmengen und nimmt weniger Zeit für die Bearbeitung bestimmter Aufgaben in Anspruch. Sie erwerben außerdem Kenntnisse über Textblob , die sich mit Aufgaben der Verarbeitung natürlicher Sprache befassen.

Unter Textanalyse versteht man den Prozess der Analyse von Texten mithilfe von Codes für automatisierte Prozesse zur Erstellung und Gruppierung von Textdaten.

Bevor wir fortfahren, müssen Sie möglicherweise die Bibliothek installieren, die wir in diesem Tutorial verwenden.

Inhaltsverzeichnis

Textanalyse in Python implementieren

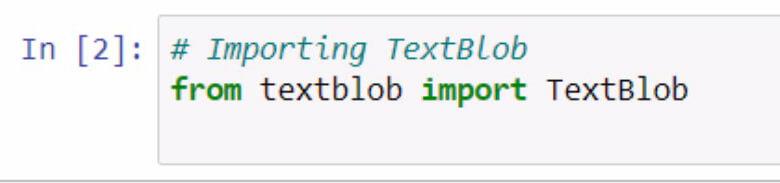

Beginnen wir mit dem Importieren von textblob . Denken Sie daran, mithilfe von Kommentaren zu dokumentieren, was Sie tun.

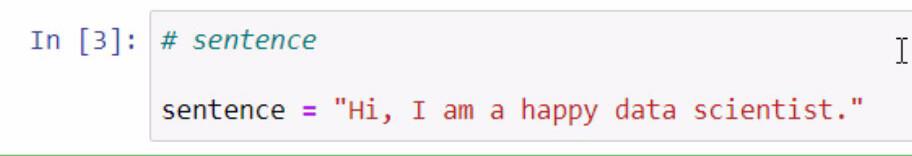

Durch Ausführen des obigen Codes haben wir jetzt Zugriff auf die Textblob- Bibliothek. Der nächste Schritt besteht darin, einen Satz zu erstellen, den wir für unsere Beispiele verwenden werden. Wir werden dies tun, indem wir einen Satz in einer Variablen namens „ Satz“ speichern .

Denken Sie daran, den Satz, den Sie hinzufügen möchten, in doppelte Anführungszeichen zu setzen.

Der Textblob ist eine großartige Bibliothek, in der wir einen Blob erstellen und einige seiner Funktionen für unsere Textanalyse in Python verwenden können .

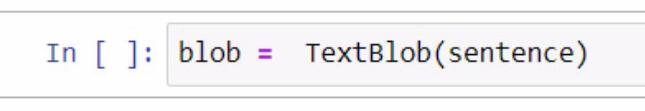

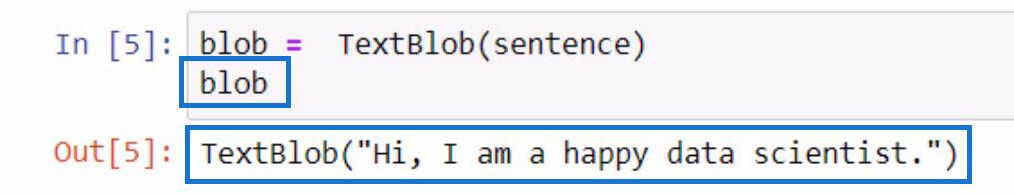

Beim Erstellen des Blobs erstellen wir zunächst eine Variable und nennen sie blob . In dieser Variablen müssen wir TextBlob hinzufügen , die Bibliothek, die wir verwenden.

Innerhalb der Klammern verwenden wir die Satzvariable , die den Satz enthält, den wir zuvor erstellt haben. Beachten Sie, dass Sie für diesen Teil die Möglichkeit haben, den Satz selbst manuell in die Klammern einzugeben.

Um zu überprüfen, was diese Blob- Variable bewirkt, können Sie sie einfach initialisieren, indem Sie den Variablennamen eingeben und die Tasten Umschalt + Eingabetaste drücken. Die Ausgabe sollte dem folgenden Beispiel ähneln.

Wie Sie dem Ergebnis entnehmen können, ist der Satz, den wir in der Satzvariablen gespeichert haben, jetzt in TextBlob enthalten .

Tokenisierung von Textdaten in Python

Wenn Sie einige Wörter in einem Satz entfernen möchten, können wir jedes dieser Wörter in einer Liste in einzelne Teile aufteilen. Was wir mit diesem gegebenen Satz tun werden, ist, ihn zu tokenisieren oder jedes Wort zu trennen und es in eine Liste einzufügen.

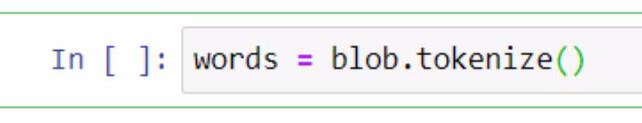

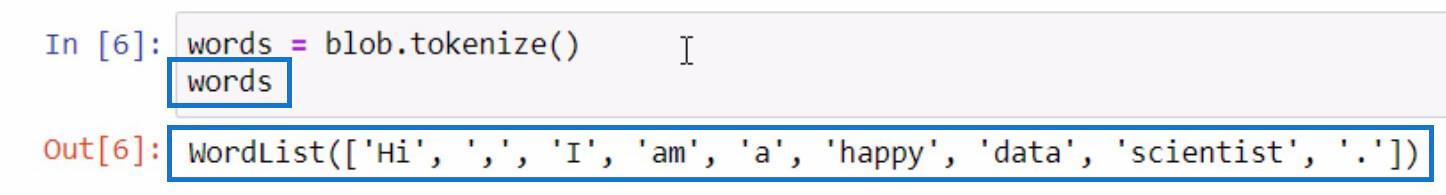

Dazu verwenden wir die Blob- Variable und die Tokenize- Funktion. Dann speichern wir es in einer Variablen namens „words“ .

Lassen Sie uns die Variable „Words“ auf die gleiche Weise initialisieren, wie wir es bei der Initialisierung der Blob- Variable getan haben, um zu sehen, was in der tokenisierten Liste enthalten ist.

Wie Sie sehen, sind jetzt alle Wörter und sogar die Satzzeichen in einer Liste getrennt. So funktioniert die Tokenize- Funktion.

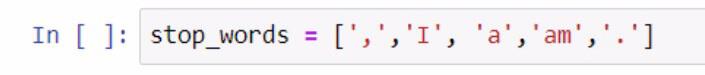

Da wir nun eine Wortliste haben, können wir daraus eine weitere Funktion ausführen. Erstellen wir eine weitere Liste mit Wörtern, die nicht in unsere Liste aufgenommen werden sollen, z. B. Satzzeichen und Artikel. Um diesen Schritt auszuführen, sehen Sie sich den Screenshot unten an.

Bei der Erstellung der Liste der Stoppwörter haben wir Klammern verwendet, um die Liste der Stoppwörter einzuschließen. Dann wird jedes Stoppwort in einfache Anführungszeichen gesetzt und durch ein Komma getrennt. Wir haben die Liste in der Variablen stop_words gespeichert .

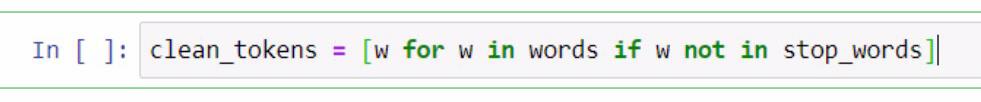

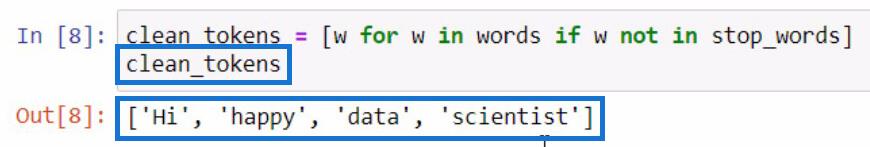

Von hier aus führen wir ein Listenverständnis durch , um Wörter zu entfernen, die für die Durchführung einer Textanalyse in Python erforderlich sind . Dazu gehören das Bereinigen von Sätzen, das Tokenisieren und das Vergleichen verschiedener Listen. Wir werden nun diese beiden Listen vergleichen und eine neue Liste von clean_tokens erstellen .

Im oben dargestellten Code haben wir einen Platzhalter verwendet, der w ist, um ein Element darzustellen . In diesem Teil versuchen wir, das Element in der Variablen „words“ abzurufen, wenn das Element in der Variablen „ stop_words“ nicht vorhanden ist . Wenn wir clean_tokens initialisieren , wird dies das Ergebnis sein.

In diesem Prozess sind wir in der Lage, unsere Token zu bereinigen , indem wir einen Prozess zum Entfernen unnötiger Token wie Satzzeichen und Artikel einführen. Aus diesem Grund haben wir nur noch die wesentlichen Wörter auf unserer Liste.

Zusammenfügen von Token zu einem Satz in Python

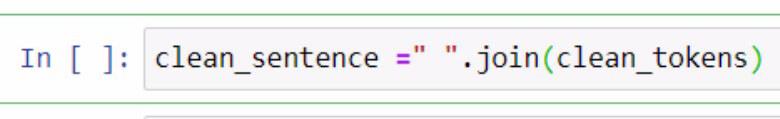

Nachdem wir nun die sauberen Token getrennt haben , versuchen wir, sie alle in einem Satz zusammenzufassen. Dazu müssen wir die .join- Funktion verwenden. Schauen Sie sich das Beispiel unten als Referenz an.

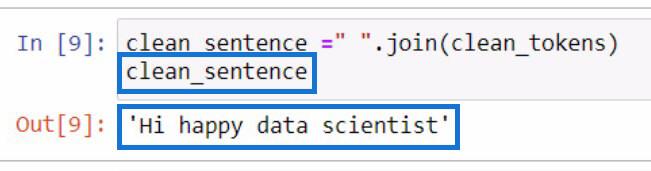

Im obigen Beispiel haben wir eine Variable mit dem Namen „clean_sentence“ erstellt , um unsere Clean-Tokens zu speichern, die zu einem Satz zusammengefasst werden. Sie können auch feststellen, dass wir ein in doppelte Anführungszeichen eingeschlossenes Leerzeichen und die Funktion .join hinzugefügt haben. In die Parameter haben wir die Variable clean_tokens eingefügt .

Dies ist die Ausgabe, wenn wir die Variable „clean_sentence“ initialisieren .

Auffällig ist, dass der Satz nicht richtig aussieht, da wir die Artikel und Satzzeichen zuvor entfernt haben.

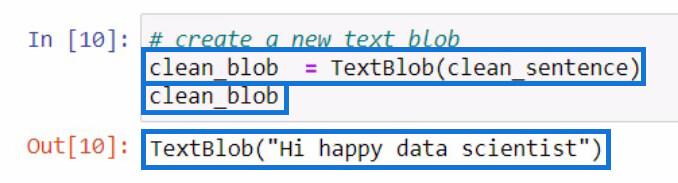

Nachdem wir „clean_sentence“ erstellt haben , versuchen wir, einen neuen Textblob zu erstellen, der den soeben erstellten „clean_sentence“ enthält . Dann speichern wir es in einer neuen Variablen clean_blob .

Zerlegen eines Textblobs nach Wortarten mithilfe der .tags-Funktion

Anhand dieses Analyse-Blobs können wir die Teile dieses Blobs verwenden, um nach Wortarten zu suchen oder noch mehr Änderungen vorzunehmen. Versuchen wir, die Wortarten jedes Wortes in unserem neuen Textblob zu überprüfen .

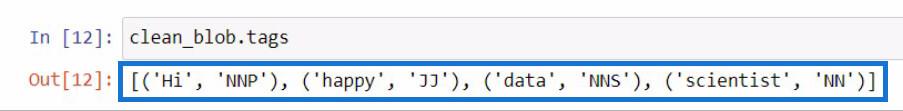

Um die Wortarten in einem Textblob zu überprüfen, sollten Sie die Funktion .tags verwenden . Dazu habe ich unsere Variable „clean_blob“ verwendet und direkt danach die Funktion „.tags“ hinzugefügt .

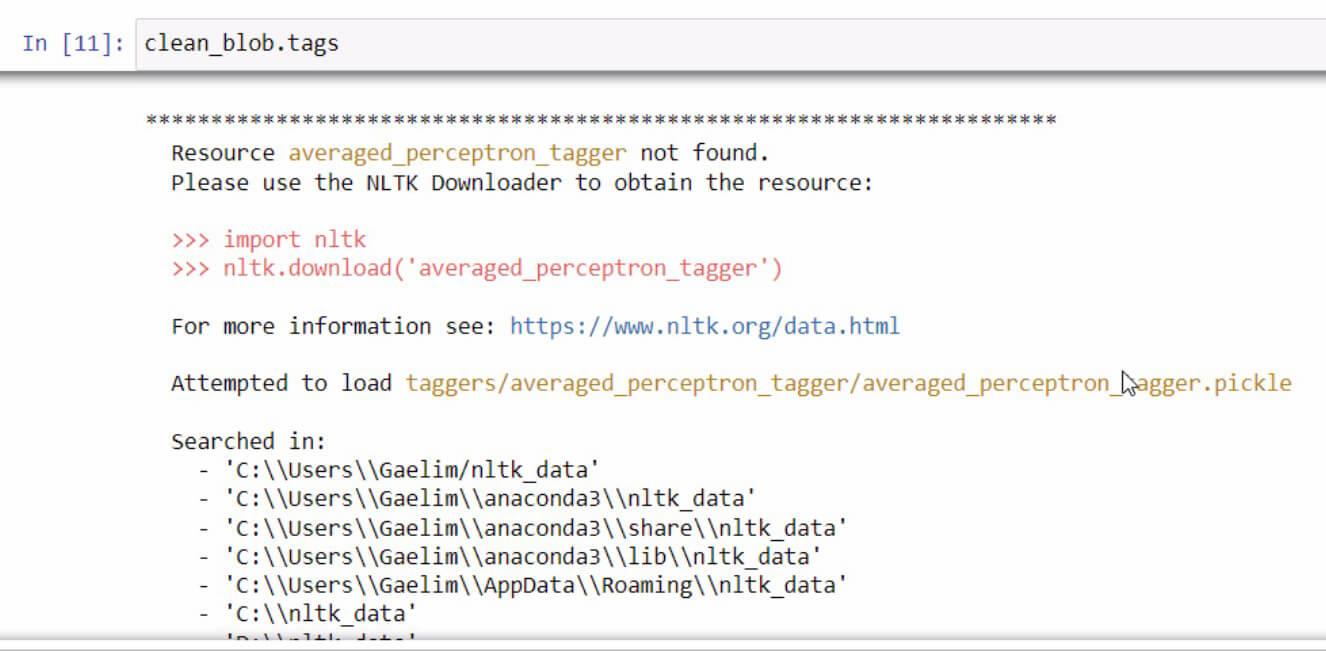

Sollten Sie beim Initialisieren der .tags- Funktion jemals eine Fehlermeldung erhalten , lesen Sie einfach die Schritte durch und befolgen Sie sie, um den Fehler zu beheben. In diesem Fall sieht es so aus.

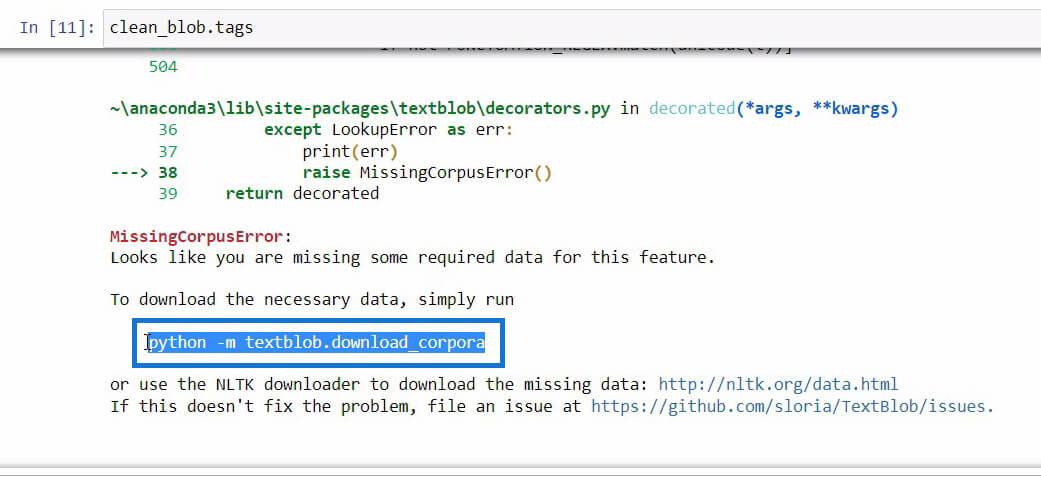

Wenn Sie am Ende dieser Fehlermeldung nach unten scrollen, werden die erforderlichen Daten angezeigt, die Sie für die Funktion benötigen, die Sie verwenden möchten.

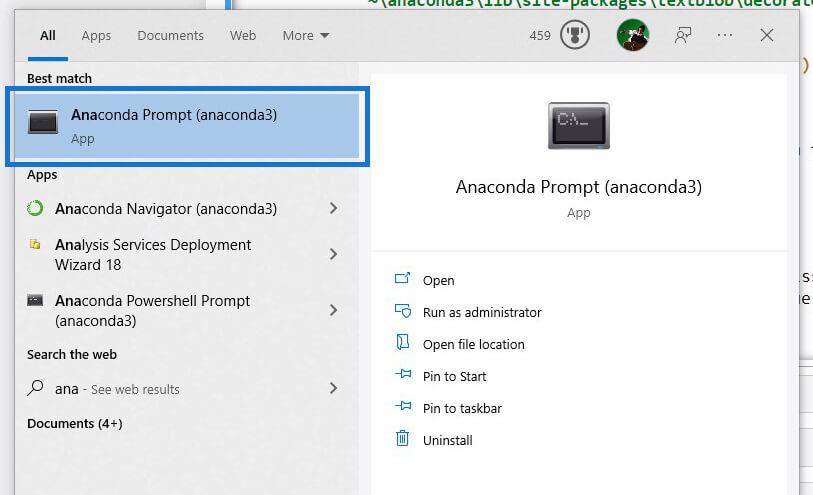

Sobald wir den Code gefunden haben, den wir initialisieren müssen, um die erforderlichen Daten herunterzuladen, kopieren Sie einfach den Code und öffnen Sie dann die Anaconda-Eingabeaufforderung mit der Windows-Suche .

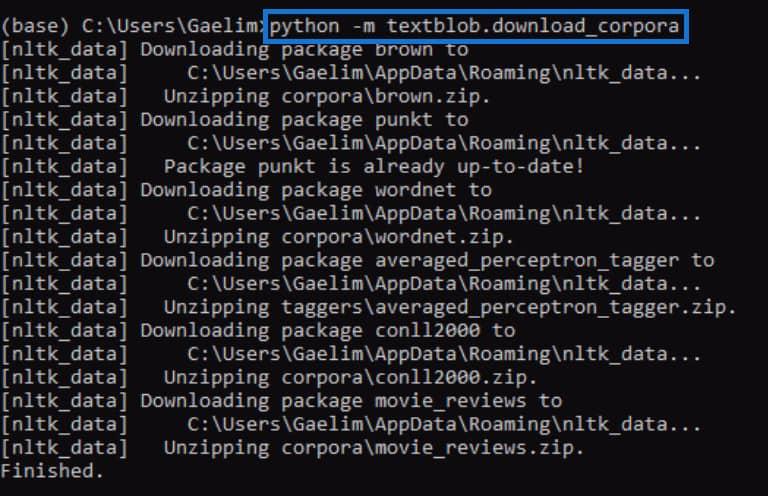

Mithilfe der Anaconda-Eingabeaufforderung versuchen wir, den Fehler zu beheben, der bei der Initialisierung der .tags- Funktion aufgetreten ist. Wir fügen nun den Code ein, den wir zuvor aus der Fehlermeldung kopiert haben, und führen ihn durch Drücken der Eingabetaste aus .

Versuchen Sie nach Abschluss erneut, die .tags- Funktion auszuführen, und prüfen Sie, ob sie funktioniert.

Wenn wir den Code erneut ausführen, können wir sehen, dass der Fehler behoben ist, und wir haben ein Ergebnis erhalten, das jedes Wort aus dem neuen Textblob zusammen mit den Tags oder Wortarten enthält.

Wenn Sie keine Ahnung haben, was diese Tags bedeuten, können Sie einfach auf der Textblob-Website nachsehen, was diese Tags bedeuten.

Verwendung der ngrams-Funktion für die Textanalyse in Python

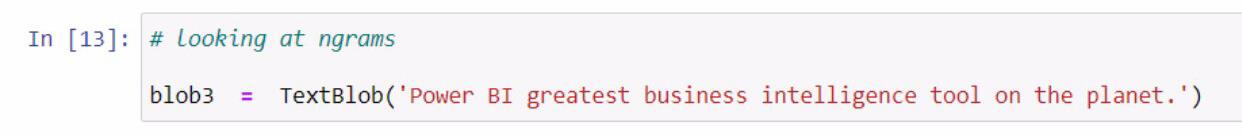

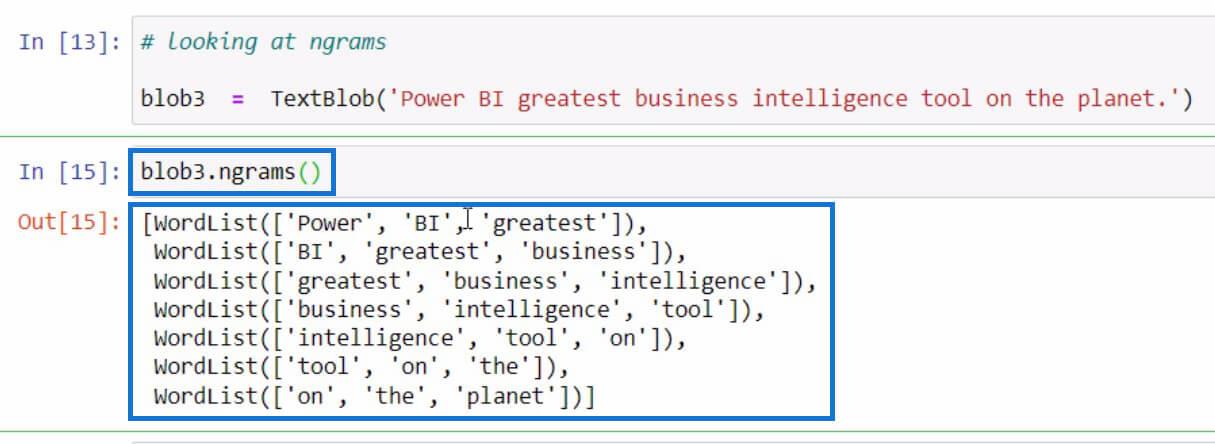

Kommen wir zu einem anderen Beispiel, bei dem es darum geht, die ngrams zu erhalten . Die ngrams- Funktion wird verwendet, um nach Wörtern zu suchen, die häufig zusammen in einem Satz oder Dokument vorkommen. Als Beispiel beginnen wir damit, einen neuen Textblob zu erstellen und ihn in der Variable blob3 zu speichern .

Anschließend verwenden wir die Funktion ngrams in der Variablen blob3 , um einige Wortkombinationen zu überprüfen.

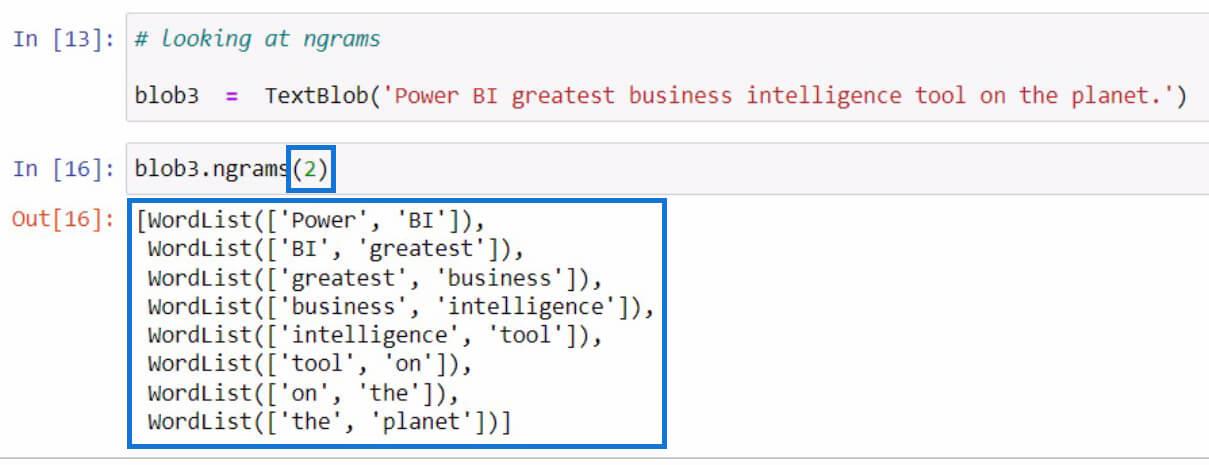

Wenn Sie in den Parametern keinen Wert angegeben haben, werden standardmäßig Trigramme oder 3-Wort-Kombinationen angezeigt. Wenn wir jedoch 2-Wort-Kombinationen aus dem Satz sehen möchten, können wir wie im folgenden Beispiel 2 in den Parametern festlegen.

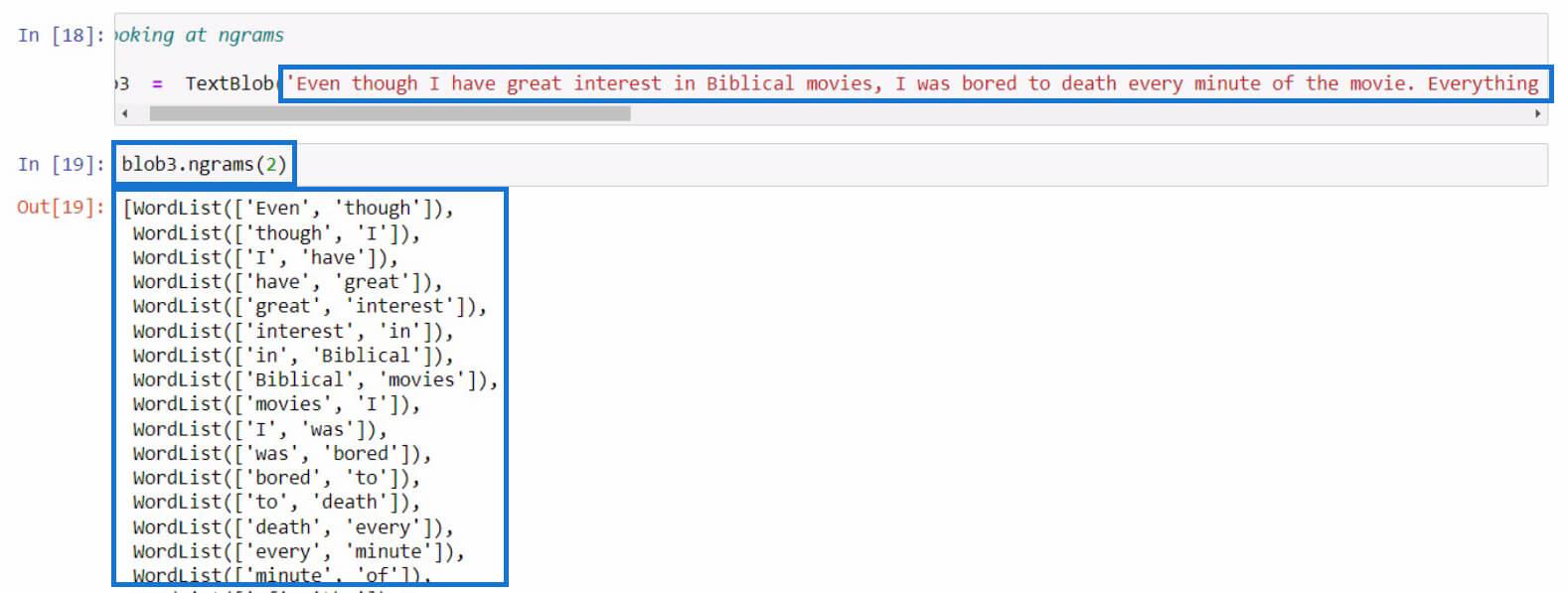

Versuchen wir es dieses Mal mit einem längeren Satz. In diesem Beispiel habe ich gerade einen längeren Text aus einer Filmkritik kopiert. Sie können für diesen Teil einen beliebigen Satz verwenden.

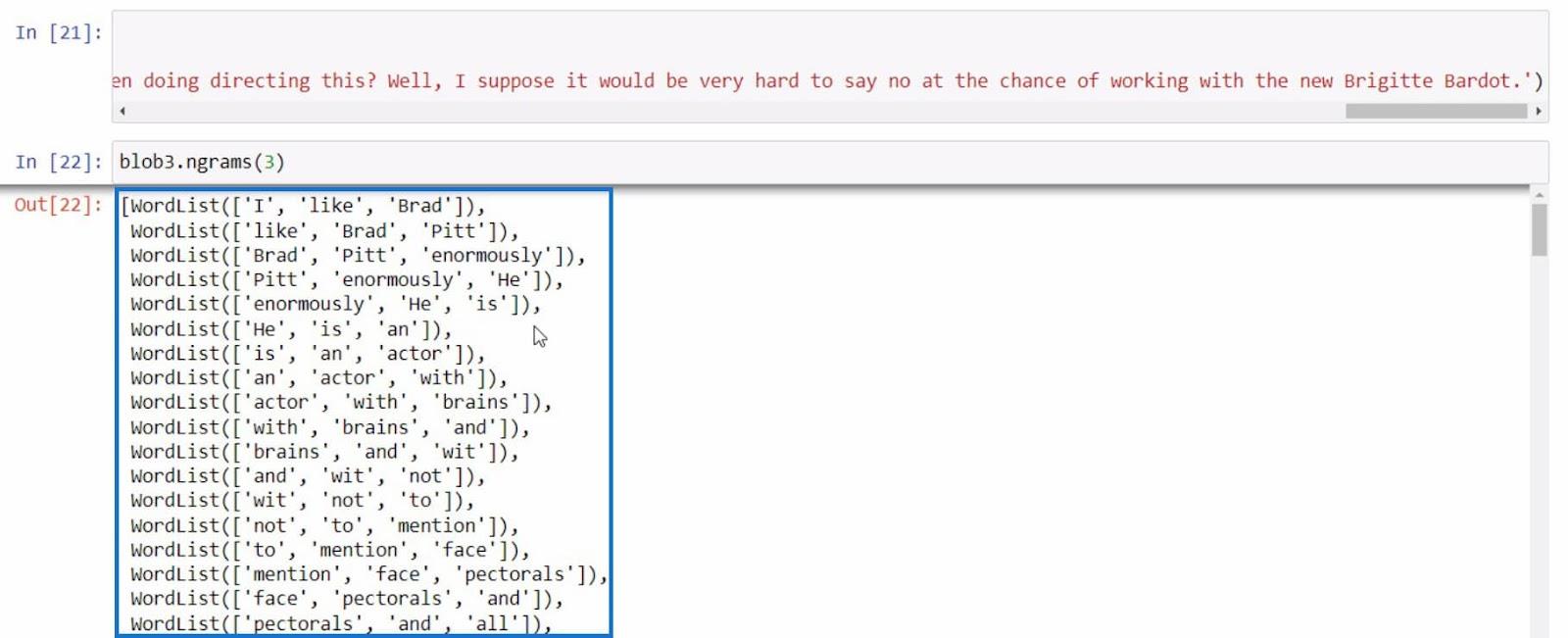

Als letztes Beispiel versuchen wir noch einmal, ngrams mit einem informativeren Satz zu verwenden.

Mit all diesen Beispielen können wir basierend auf den Ergebnissen, die wir mit der ngrams- Funktion erhalten, weitere Textanalysen in Python durchführen .

Python II für LuckyTemplates-Benutzer – Neuer Kurs in der On-Demand-Plattform

So laden Sie Beispieldatensätze in Python

mithilfe von Python in LuckyTemplates | Datensatz- und String-Funktion

Abschluss

Zusammenfassend haben Sie die verschiedenen Funktionen kennengelernt, die Sie zur Durchführung von Textanalysen in Python verwenden können.

Dies sind die Funktion .tokenize zum Trennen von Wörtern in einem Satz, die Funktion .join zum Kombinieren tokenisierter Wörter, die Funktion .tags zum Überprüfen der Wortarten und die Funktion ngrams zum Anzeigen der Wortkombination.

Darüber hinaus haben Sie gelernt, wie Sie Fehler beheben können, wie wir es in der .tags -Funktion mit Anaconda Prompt getan haben . Sie haben außerdem gelernt, wie Sie diese Bibliothek importieren, einen Textblob erstellen und für die Durchführung einer Textanalyse in Python verwenden .

Alles Gute,

Gaellim

In diesem Tutorial erfahren Sie, wie Sie mit Charticulator eine Streudiagramm-Visualisierung für Ihren LuckyTemplates-Bericht erstellen und entwerfen.

Erfahren Sie, wie Sie ein PowerApps-Suchfeld von Grund auf erstellen und es an das Gesamtthema Ihrer App anpassen.

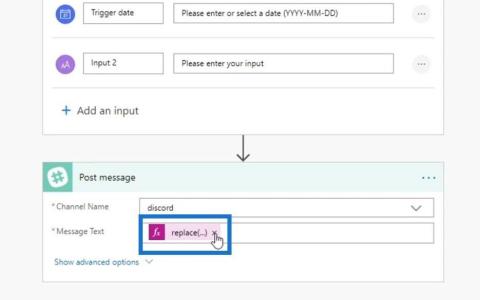

Erlernen Sie ganz einfach zwei komplizierte Power Automate String-Funktionen, die in Microsoft Flows verwendet werden können – die Funktionen substring und indexOf.

Dieses Tutorial konzentriert sich auf die Power Query M-Funktion „number.mod“, um ein abwechselndes 0-1-Muster in der Datumstabelle zu erstellen.

In diesem Tutorial führe ich eine Prognosetechnik durch, bei der ich meine tatsächlichen Ergebnisse mit meinen Prognosen vergleiche und sie kumulativ betrachte.

In diesem Blog erfahren Sie, wie Sie mit Power Automate E-Mail-Anhänge automatisch in SharePoint speichern und E-Mails anschließend löschen.

Erfahren Sie, wie die Do Until Schleifensteuerung in Power Automate funktioniert und welche Schritte zur Implementierung erforderlich sind.

In diesem Tutorial erfahren Sie, wie Sie mithilfe der ALLSELECTED-Funktion einen dynamischen gleitenden Durchschnitt in LuckyTemplates berechnen können.

Durch diesen Artikel erhalten wir ein klares und besseres Verständnis für die dynamische Berechnung einer laufenden oder kumulativen Gesamtsumme in LuckyTemplates.

Erfahren und verstehen Sie die Bedeutung und ordnungsgemäße Verwendung der Power Automate-Aktionssteuerung „Auf jede anwenden“ in unseren Microsoft-Workflows.